Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

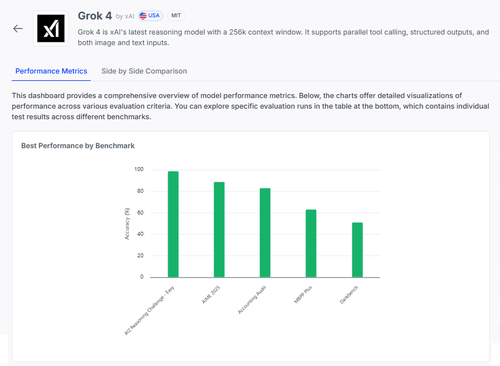

🧠 Grok 4 de @xai está avanzando en los benchmarks de razonamiento, pero la imagen es más matizada de lo que sugieren las puntuaciones.

Aquí está cómo se compara — y lo que realmente podemos aprender de sus resultados 🧵

📊 Evaluación completa:

1️⃣ Puntuaciones de Grok 4:

• Desafío de Razonamiento AI2 (Fácil): 98%

• AIME 2025 (Matemáticas): 89%

• Auditoría Contable: 84%

• MMLU-Plus: 64%

• Data4Health: 55%

Estas son puntuaciones generales — pero vamos a profundizar en lo que funciona y lo que aún falla.

2️⃣ AIME 2025

✅ Maneja álgebra, geometría, teoría de números

✅ Sigue las reglas de formato de LaTeX

❌ Tiene problemas con la lógica de múltiples pasos

❌ Errores en combinatoria

❌ Problemas de precisión en el formato (por ejemplo, falta el °)

3️⃣ Auditoría Contable

✅ Fuerte en ética e informes

✅ Sólido entendimiento de los principios de auditoría

❌ Mala interpretación de procedimientos similares

❌ No detecta diferencias sutiles en las respuestas

❌ Dificultad para aplicar la teoría a casos del mundo real

4️⃣ ¿La verdadera percepción?

Incluso un modelo con un 98% en algunas tareas puede fallar gravemente bajo ambigüedad o estrés de formato.

Los benchmarks como AIME y Auditoría muestran cómo falla, no solo cuánto puntúa.

5️⃣ ¿Por qué esto es importante?

Necesitamos una evaluación transparente, por tarea — no solo tablas de clasificación.

#Grok4 es poderoso, pero aún frágil en dominios del mundo real de alto riesgo.

🧪 Explora el desglose completo:

#AI #LLMs #Benchmarking

1,12K

Parte superior

Clasificación

Favoritos