Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

🧠 Grok 4 von @xai macht Fortschritte bei den Denkbenchmarks, aber das Bild ist nuancierter, als die Ergebnisse vermuten lassen.

Hier ist, wie es abschneidet – und was wir wirklich aus seinen Ergebnissen lernen können 🧵

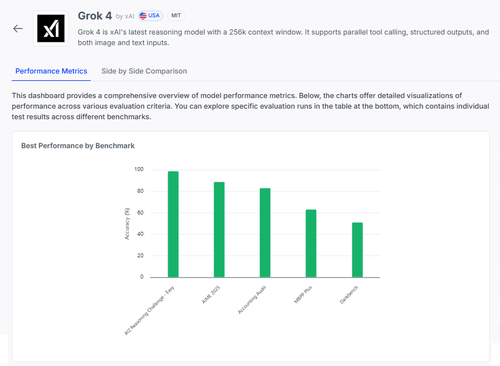

📊 Vollständige Bewertung:

1️⃣ Grok 4 Ergebnisse:

• AI2 Reasoning Challenge (Einfach): 98%

• AIME 2025 (Mathematik): 89%

• Buchhaltungsprüfung: 84%

• MMLU-Plus: 64%

• Data4Health: 55%

Das sind die Gesamtergebnisse – aber lassen Sie uns genauer betrachten, was funktioniert und was noch scheitert.

2️⃣ AIME 2025

✅ Bewältigt Algebra, Geometrie, Zahlentheorie

✅ Befolgt LaTeX-Formatierungsregeln

❌ Hat Schwierigkeiten mit mehrstufiger Logik

❌ Fehler in der Kombinatorik

❌ Probleme mit der Formatgenauigkeit (z. B. fehlendes °)

3️⃣ Buchhaltungsprüfung

✅ Stark in Ethik & Berichterstattung

✅ Solides Verständnis der Prüfungsprinzipien

❌ Fehlinterpretation ähnlicher Verfahren

❌ Versäumt es, subtile Unterschiede in den Antworten zu erkennen

❌ Schwierigkeiten, Theorie auf reale Fälle anzuwenden

4️⃣ Die echte Erkenntnis?

Selbst ein Modell mit 98% in einigen Aufgaben kann bei Mehrdeutigkeit oder Formatierungsstress stark versagen.

Benchmarks wie AIME und Audit zeigen, wie es scheitert, nicht nur, wie viel es erzielt.

5️⃣ Warum das wichtig ist:

Wir brauchen transparente, aufgabenbezogene Bewertungen – nicht nur Bestenlisten.

#Grok4 ist leistungsstark, aber immer noch anfällig in hochriskanten, realen Bereichen.

🧪 Erkunden Sie die vollständige Analyse:

#AI #LLMs #Benchmarking

1,04K

Top

Ranking

Favoriten