Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

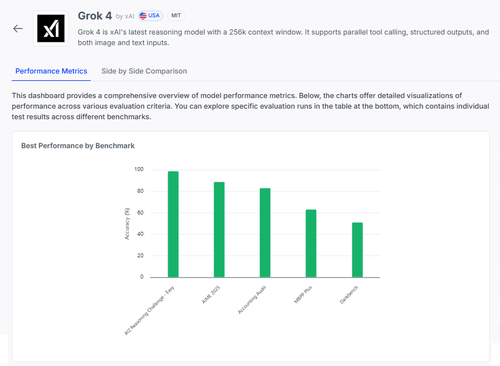

🧠 Grok 4 van @xai maakt vooruitgang in redeneerbenchmarks, maar het plaatje is genuanceerder dan de scores suggereren.

Hier is hoe het zich verhoudt — en wat we echt kunnen leren van de resultaten 🧵

📊 Volledige evaluatie:

1️⃣ Grok 4 scores:

• AI2 Redeneeruitdaging (Gemakkelijk): 98%

• AIME 2025 (Wiskunde): 89%

• Accounting Audit: 84%

• MMLU-Plus: 64%

• Data4Health: 55%

Dit zijn toplijnscores — maar laten we inzoomen op wat werkt en wat nog steeds faalt.

2️⃣ AIME 2025

✅ Beheert algebra, meetkunde, getaltheorie

✅ Volgt LaTeX opmaakregels

❌ Heeft moeite met meerstapslogica

❌ Fouten in combinatoriek

❌ Probleem met precisie in opmaak (bijv. ontbrekende °)

3️⃣ Accounting Audit

✅ Sterk op ethiek & rapportage

✅ Goede grip op auditprincipes

❌ Interpreteert vergelijkbare procedures verkeerd

❌ Herkent subtiele verschillen in antwoorden niet

❌ Moeite met het toepassen van theorie op echte situaties

4️⃣ Het echte inzicht?

Zelfs een model met 98% op sommige taken kan hard falen onder ambiguïteit of opmaakstress.

Benchmarks zoals AIME en Audit tonen aan hoe het faalt, niet alleen hoeveel het scoort.

5️⃣ Waarom dit belangrijk is:

We hebben transparante, per-taak evaluatie nodig — niet alleen ranglijsten.

#Grok4 is krachtig, maar nog steeds kwetsbaar in risicovolle, echte domeinen.

🧪 Verken de volledige uitsplitsing:

#AI #LLMs #Benchmarking

1,12K

Boven

Positie

Favorieten