Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

🧠 Grok 4 от @xai делает успехи в тестах на рассуждение, но ситуация более сложная, чем предполагают оценки.

Вот как он выглядит — и что мы действительно можем узнать из его результатов 🧵

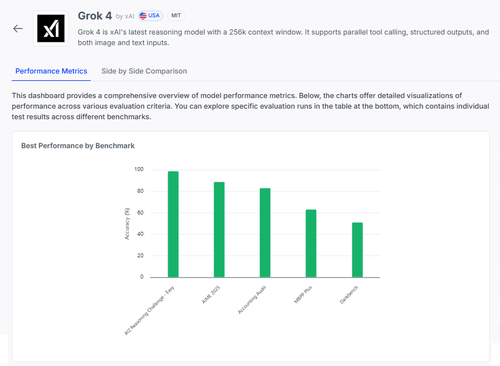

📊 Полная оценка:

1️⃣ Оценки Grok 4:

• AI2 Reasoning Challenge (Легкий): 98%

• AIME 2025 (Математика): 89%

• Аудит бухгалтерского учета: 84%

• MMLU-Plus: 64%

• Data4Health: 55%

Это верхние оценки — но давайте углубимся в то, что работает, а что все еще не удается.

2️⃣ AIME 2025

✅ Обрабатывает алгебру, геометрию, теорию чисел

✅ Соблюдает правила форматирования LaTeX

❌ Испытывает трудности с многошаговой логикой

❌ Ошибки в комбинаторике

❌ Проблемы с точностью формата (например, отсутствие °)

3️⃣ Аудит бухгалтерского учета

✅ Сильные стороны в этике и отчетности

✅ Хорошее понимание принципов аудита

❌ Неправильно интерпретирует схожие процедуры

❌ Не замечает тонкие различия в ответах

❌ Трудности с применением теории к реальным случаям

4️⃣ Настоящее понимание?

Даже модель с 98% по некоторым задачам может сильно провалиться в условиях неопределенности или стресса форматирования.

Тесты, такие как AIME и Аудит, показывают, как она проваливается, а не только сколько она набирает.

5️⃣ Почему это важно:

Нам нужна прозрачная оценка по каждой задаче — а не просто таблицы лидеров.

#Grok4 мощный, но все еще хрупкий в условиях высокой ставки в реальном мире.

🧪 Изучите полный анализ:

#AI #LLMs #Бенчмаркинг

1,12K

Топ

Рейтинг

Избранное