Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Shane Gu

Tvillingarna - RL, Spjälsäng, flerspråkighet. Högre tjänstemän RS @GoogleDeepMind MTV. 🇯🇵 -Född. 🇨🇳🇨🇦 ex: @OpenAI (JP: @shanegJP)

Efter ÅR av väntan och ovisshet är green card för min familj godkänt, och vi flyttade till Silicon Valley från Japan förra veckan. Jag har varit i bukten sedan 2012 till och från men det här är den mest spännande tiden att vara här. Glada över att gå med mina fantastiska kollegor och göra ASI🔥

25,55K

Shane Gu delade inlägget

🚨 Olympiad matematik + AI:

Vi körde Googles Gemini 2.5 Pro på de nya IMO 2025-problemen. Med noggranna uppmaningar och pipeline-design löste den 5 av 6 – anmärkningsvärt för uppgifter som kräver djup insikt och kreativitet.

Modellen kan vinna guld! 🥇

#AI #Math #LLMs #IMO2025

269,49K

Asiater: vi kommer att fixa vår egen röra

Patrick Shen18 juli 03:03

Vid lanseringen hävdade Cluely att det skulle döda 9 industrier.

Vi är här för att döda en av dem: att fuska.

Meet Truely – verktyget med öppen källkod som flaggar AI-assisterade intervjuer i realtid. Fungerar med Zoom, Meets, Teams med mera.

Framtiden för onlineintervjuer är här.

2,06K

För att bekämpa asiater behöver du asiater

Patrick Shen18 juli 03:03

Vid lanseringen hävdade Cluely att det skulle döda 9 industrier.

Vi är här för att döda en av dem: att fuska.

Meet Truely – verktyget med öppen källkod som flaggar AI-assisterade intervjuer i realtid. Fungerar med Zoom, Meets, Teams med mera.

Framtiden för onlineintervjuer är här.

282

Varför team före och efter träning måste komma överens

David Mizrahi18 juli 06:21

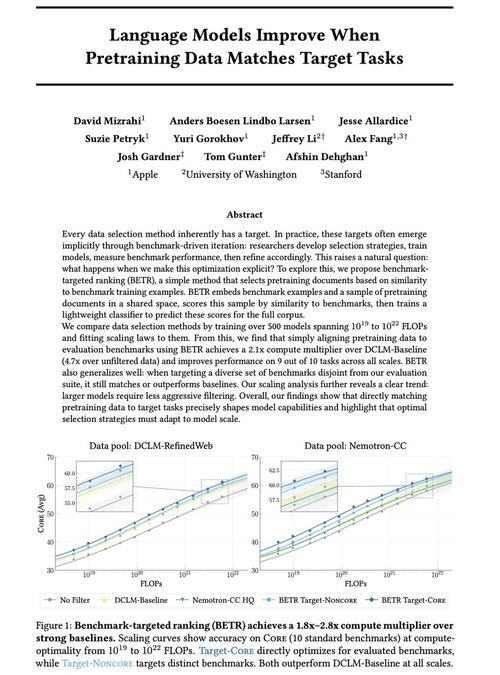

Vi är glada över att dela med oss av vårt nya arbete: "Språkmodeller förbättras när förträningsdata matchar måluppgifter"

Ja, det låter självklart (och det är det!), men vanligtvis sker detta bara implicit och indirekt: välj intuitivt data → benchmarka → förfina → upprepa.

Vi undrade: vad händer om vi uttryckligen matchar förträningsdata med riktmärken? Resultatet är en mycket enkel metod som ger 2x+ beräkningsmultiplikatorer över starka baslinjer och ger oss ett principiellt sätt att studera hur benchmarkval formar (och begränsar!) modellfunktioner.

Bonus: omfattande skalningslagar från träning av 500+ modeller som avslöjar hur optimalt dataval utvecklas när modellerna skalas.

🧵 Betyg (1/14)

2,73K

Grok-teamet internaliserar mänskliga dataoperationer (t.ex. rekrytering för rollen som AI-handledare för japaner). Sannolikt tänker fler gränslaboratorier på att äga och driva dataarbetet.

Koki Ikeda | SoftBank15 juli 22:12

"xAI", som utvecklar Grok, söker en japansk AI-handledare.

Jobbet innebär att märka och kommentera japansk text-, ljud- och videodata. Du kan arbeta helt på distans från Japan, och lönen är till ett högt timpris som motsvarar amerikansk standard.

🗣️ Personer som har japanska som modersmål

🧑 💻 Helt på distans

💰 Timpris på $35–65 (5200-9600 yen)

🕐 6-månaderskontrakt (med möjlighet till förlängning)

8,42K

Grok-teamet internaliserar mänskliga dataoperationer (t.ex. rekrytering för rollen som AI-handledare för japaner). Med tanke på övergången till AI i skala är det troligt att fler gränslaboratorier funderar på att äga och driva dataarbetet.

Koki Ikeda | SoftBank15 juli 22:12

"xAI", som utvecklar Grok, söker en japansk AI-handledare.

Jobbet innebär att märka och kommentera japansk text-, ljud- och videodata. Du kan arbeta helt på distans från Japan, och lönen är till ett högt timpris som motsvarar amerikansk standard.

🗣️ Personer som har japanska som modersmål

🧑 💻 Helt på distans

💰 Timpris på $35–65 (5200-9600 yen)

🕐 6-månaderskontrakt (med möjlighet till förlängning)

379

Om du är på ICML och intresserad av RL eller flerspråkighet, säg hej till @marafinkels! Vi har haft ett nära samarbete under de senaste månaderna för att leverera en RL-metod för att åtgärda ett kritiskt kvalitetsproblem med Gemini. Hon har också bra forskningsidéer! Hoppas Gemini x academia håller kontakten.

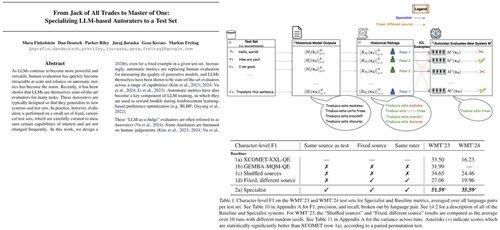

Mara Finkelstein27 nov. 2024

LLM:er utvärderas vanligtvis med automatiska mätvärden på standardtestuppsättningar, men mätvärden + testuppsättningar utvecklas oberoende. Detta väcker en viktig fråga: Kan vi utforma automatiska mätvärden specifikt för att utmärka oss på de testuppsättningar vi prioriterar? Svar: Ja!

5,81K

Shane Gu delade inlägget

Nytt blogginlägg om asymmetri i verifiering och "verifierarens lag":

Asymmetri för verifiering – idén att vissa uppgifter är mycket lättare att verifiera än att lösa – blir en viktig idé eftersom vi har RL som äntligen fungerar generellt.

Bra exempel på asymmetri i verifiering är saker som sudoku-pussel, att skriva koden för en webbplats som instagram och BrowseComp-problem (tar ~100 webbplatser att hitta svaret, men lätt att verifiera när du väl har svaret).

Andra uppgifter har nästan symmetri i verifieringen, som att summera två 900-siffriga tal eller vissa databehandlingsskript. Men andra uppgifter är mycket lättare att föreslå genomförbara lösningar för än att verifiera dem (t.ex. faktagranskning av en lång uppsats eller att ange en ny diet som "ät bara bison").

En viktig sak att förstå om asymmetri i verifiering är att du kan förbättra asymmetrin genom att göra lite arbete i förväg. Till exempel om du har svarsnyckeln till ett matematiskt problem eller om du har testfall för ett Leetcode-problem. Detta ökar kraftigt uppsättningen problem med önskvärd verifieringsasymmetri.

"Verifierarens lag" säger att hur lätt det är att träna AI att lösa en uppgift är proportionell mot hur verifierbar uppgiften är. Alla uppgifter som är möjliga att lösa och lätta att verifiera kommer att lösas av AI. Möjligheten att träna AI för att lösa en uppgift är proportionell mot om uppgiften har följande egenskaper:

1. Objektiv sanning: alla är överens om vad bra lösningar är

2. Snabbt att verifiera: alla givna lösningar kan verifieras på några sekunder

3. Skalbar att verifiera: många lösningar kan verifieras samtidigt

4. Lågt brus: verifieringen är så nära korrelerad till lösningens kvalitet som möjligt

5. Kontinuerlig belöning: det är lätt att rangordna godheten hos många lösningar på ett enda problem

En uppenbar exemplifiering av verifierarens lag är det faktum att de flesta riktmärken som föreslås i AI är lätta att verifiera och hittills har lösts. Lägg märke till att praktiskt taget alla populära riktmärken under de senaste tio åren passar in på kriterium #1-4; Riktmärken som inte uppfyller kriterium #1-4 skulle kämpa för att bli populära.

Varför är verifierbarhet så viktigt? Mängden lärande i AI som sker maximeras när ovanstående kriterier är uppfyllda; Du kan ta många gradientsteg där varje steg har mycket signal. Iterationshastigheten är avgörande – det är anledningen till att framstegen i den digitala världen har varit så mycket snabbare än framstegen i den fysiska världen.

AlphaEvolve från Google är ett av de bästa exemplen på att utnyttja asymmetri i verifieringen. Den fokuserar på upplägg som passar alla ovanstående kriterier och har lett till ett antal framsteg inom matematik och andra områden. Till skillnad från vad vi har gjort inom AI under de senaste två decennierna är det ett nytt paradigm i och med att alla problem optimeras i en miljö där tågsetet är likvärdigt med testsetet.

Asymmetri för verifiering finns överallt och det är spännande att tänka på en värld av ojämn intelligens där allt vi kan mäta kommer att lösas.

298,83K

Topp

Rankning

Favoriter

Trendande på kedjan

Trendande på X

Senaste toppfinansieringarna

Mest anmärkningsvärda