Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Shane Gu

Tvillingene - RL, CoT, flerspråklighet. Seniorstab RS @GoogleDeepMind MTV. 🇯🇵 -født 🇨🇳🇨🇦 . eks: @OpenAI (JP: @shanegJP)

Shane Gu lagt ut på nytt

🚨 Olympiade matematikk + AI:

Vi kjørte Googles Gemini 2.5 Pro på de ferske IMO 2025-problemene. Med nøye oppfordring og rørledningsdesign løste den 5 av 6 – bemerkelsesverdig for oppgaver som krever dyp innsikt og kreativitet.

Modellen kan vinne gull! 🥇

#AI #Math #LLMs #IMO2025

116,76K

Asiater: vi vil fikse vårt eget rot

Patrick Shen18. juli, 03:03

Ved lanseringen hevdet Cluely at det ville drepe 9 industrier.

Vi er her for å drepe bare én: juks.

Møt Truely – åpen kildekode-verktøyet som flagger AI-assisterte intervjuer i sanntid. Fungerer med Zoom, Meets, Teams og mer.

Fremtiden for nettintervjuer er her.

1,98K

For å bekjempe asiater trenger du asiater

Patrick Shen18. juli, 03:03

Ved lanseringen hevdet Cluely at det ville drepe 9 industrier.

Vi er her for å drepe bare én: juks.

Møt Truely – åpen kildekode-verktøyet som flagger AI-assisterte intervjuer i sanntid. Fungerer med Zoom, Meets, Teams og mer.

Fremtiden for nettintervjuer er her.

201

Hvorfor team før og etter trening må komme overens

David Mizrahi18. juli, 06:21

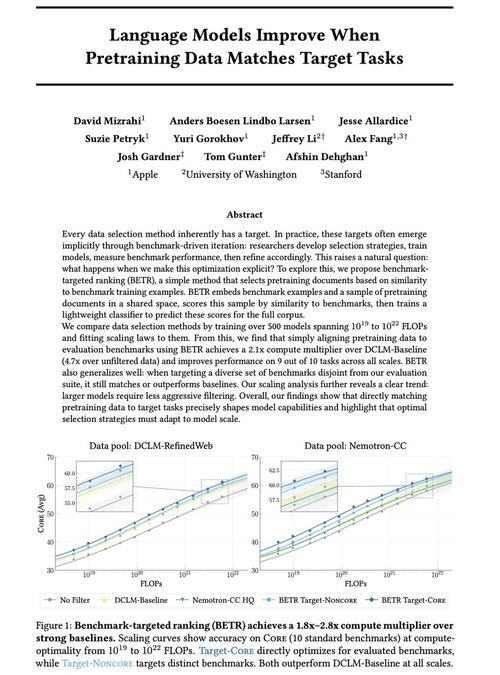

Glad for å dele vårt nye arbeid: "Språkmodeller forbedres når forhåndsopplæringsdata samsvarer med måloppgaver"

Ja, det høres åpenbart ut (og det er det!), men vanligvis skjer dette bare implisitt og indirekte: velg intuitivt data → benchmark → avgrense → gjenta.

Vi lurte på: hva skjer hvis vi eksplisitt matcher pretraining-data med benchmarks? Resultatet er en dødsenkel tilnærming som gir 2x+ beregningsmultiplikatorer over sterke grunnlinjer og gir oss en prinsipiell måte å studere hvordan referansevalg former (og begrenser!) modellfunksjoner.

Bonus: omfattende skaleringslover fra trening av 500+ modeller som avslører hvordan optimalt datautvalg utvikler seg etter hvert som modeller skaleres.

🧵 (1/14)

2,65K

Grok-teamet internaliserer menneskelige dataoperasjoner (f.eks. rekruttering til AI-veilederrolle for japansk). Sannsynligvis tenker flere frontlaboratorier på å eie og drive dataarbeidet.

Koki Ikeda | SoftBank15. juli, 22:12

«xAI», som utvikler Grok, leter etter en japansk AI-veileder.

Jobben innebærer å merke og kommentere japanske tekst-, lyd- og videodata. Du kan jobbe helt eksternt fra Japan, og lønnen er til en høy timepris tilsvarende amerikanske standarder.

🗣️ Har japansk som morsmål

🧑 💻 Helt eksternt

💰 Timepris på $35–65 (5200-9600 yen)

🕐 6-måneders kontrakt (med mulighet for forlengelse)

8,34K

Grok-teamet internaliserer menneskelige dataoperasjoner (f.eks. rekruttering til AI-veilederrolle for japansk). Gitt Scale AI-overgangen, tenker sannsynligvis flere frontlaboratorier på å eie og drive dataarbeidet.

Koki Ikeda | SoftBank15. juli, 22:12

«xAI», som utvikler Grok, leter etter en japansk AI-veileder.

Jobben innebærer å merke og kommentere japanske tekst-, lyd- og videodata. Du kan jobbe helt eksternt fra Japan, og lønnen er til en høy timepris tilsvarende amerikanske standarder.

🗣️ Har japansk som morsmål

🧑 💻 Helt eksternt

💰 Timepris på $35–65 (5200-9600 yen)

🕐 6-måneders kontrakt (med mulighet for forlengelse)

295

Hvis du er på ICML og interessert i RL eller flerspråklighet, vennligst si hei til @marafinkels! Vi har jobbet tett de siste månedene for å sende en RL-metode for å fikse et kritisk Gemini-kvalitetsproblem. Hun har også gode forskningsideer! Håper Gemini x akademia holder kontakten.

Mara Finkelstein27. nov. 2024

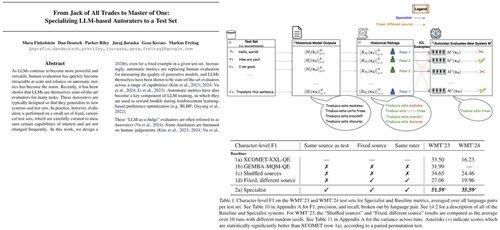

LLM-er evalueres vanligvis med automatiske beregninger på standard testsett, men beregninger + testsett utvikles uavhengig. Dette reiser et avgjørende spørsmål: Kan vi designe automatiske beregninger spesifikt for å utmerke oss på testsettene vi prioriterer? Svar: Ja!

5,73K

Shane Gu lagt ut på nytt

Nytt blogginnlegg om asymmetri i verifikasjon og «verifikatorloven»:

Asymmetri i verifisering – ideen om at noen oppgaver er mye lettere å verifisere enn å løse – er i ferd med å bli en viktig idé ettersom vi har RL som endelig fungerer generelt.

Gode eksempler på asymmetri i verifisering er ting som sudoku-gåter, å skrive koden for et nettsted som instagram og BrowseComp-problemer (tar ~100 nettsteder for å finne svaret, men lett å verifisere når du har svaret).

Andre oppgaver har nesten symmetri av verifisering, som å summere to 900-sifrede tall eller noen databehandlingsskript. Likevel er andre oppgaver mye lettere å foreslå gjennomførbare løsninger for enn å verifisere dem (f.eks. faktasjekke et langt essay eller oppgi en ny diett som "bare spis bison").

En viktig ting å forstå om asymmetri i verifisering er at du kan forbedre asymmetrien ved å gjøre litt arbeid på forhånd. For eksempel hvis du har svarnøkkelen til en matematisk oppgave eller hvis du har testtilfeller for et Leetcode-problem. Dette øker settet med problemer med ønskelig verifiseringsasymmetri betraktelig.

"Verifikatorloven" sier at det er enkelt å trene AI til å løse en oppgave er proporsjonalt med hvor verifiserbar oppgaven er. Alle oppgaver som er mulige å løse og enkle å verifisere vil bli løst av AI. Muligheten til å lære opp kunstig intelligens til å løse en oppgave er proporsjonal med om oppgaven har følgende egenskaper:

1. Objektiv sannhet: alle er enige om hva gode løsninger er

2. Rask å verifisere: enhver gitt løsning kan verifiseres på noen få sekunder

3. Skalerbar for å verifisere: mange løsninger kan verifiseres samtidig

4. Lav støy: verifiseringen er så tett korrelert til løsningskvaliteten som mulig

5. Kontinuerlig belønning: det er lett å rangere godheten til mange løsninger for et enkelt problem

En åpenbar forekomst av verifikatorloven er det faktum at de fleste benchmarks som er foreslått i AI er enkle å verifisere og så langt har blitt løst. Legg merke til at praktisk talt alle populære benchmarks de siste ti årene passer til kriteriene #1-4; Benchmarks som ikke oppfyller kriteriene #1-4 vil slite med å bli populære.

Hvorfor er verifiserbarhet så viktig? Mengden læring i AI som skjer maksimeres når kriteriene ovenfor er oppfylt; Du kan ta mange gradienttrinn der hvert trinn har mye signal. Hastigheten på iterasjonen er avgjørende – det er grunnen til at fremgangen i den digitale verden har vært så mye raskere enn fremgangen i den fysiske verden.

AlphaEvolve fra Google er et av de beste eksemplene på å utnytte asymmetri i verifisering. Den fokuserer på oppsett som passer til alle de ovennevnte kriteriene, og har ført til en rekke fremskritt innen matematikk og andre felt. Forskjellig fra det vi har gjort innen AI de siste to tiårene, er det et nytt paradigme ved at alle problemer er optimalisert i en setting der togsettet tilsvarer testsettet.

Asymmetri i verifisering er overalt, og det er spennende å tenke på en verden av taggete intelligens der alt vi kan måle vil bli løst.

298,72K

Virkningsfullt arbeid alle kan gjøre er å bruke LLM-er til å journalføre og digitalisere så mye av arbeidsflyten, CoT-ene og inspirasjonen din.

Kontekstteknikk for å automatisere og forbedre deg selv i liv og arbeid.

Thariq15. juli, 05:51

Tidsskrifter og gjøremål

Jeg har noen egendefinerte kommandoer:

/journal som oppretter en ny journaloppføring for dagen.

/todos en kommando som lar meg opprette nye til dos eller merke andre som ferdige. Gjøremål er organisert etter emne i filer, f.eks.

Claude vil ofte søke i koden min, prosjekter osv.

796

Topp

Rangering

Favoritter

Trendende onchain

Trendende på X

Nylig toppfinansiering

Mest lagt merke til