Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Shane Gu

Géminis - RL, CoT, multilingüismo. Personal superior RS @GoogleDeepMind MTV. 🇯🇵 -nacido 🇨🇳🇨🇦 . ej: @OpenAI (JP: @shanegJP)

Shane Gu reposteó

🚨 Olimpiada de matemáticas + IA:

Ejecutamos Gemini 2.5 Pro de Google en los nuevos problemas de IMO 2025. Con un cuidadoso diseño de canalización, resolvió 5 de 6, lo que es notable para tareas que exigen una visión profunda y creatividad.

¡La modelo podría ganar el oro! 🥇

#AI #Math #LLMs #IMO2025

116.75K

Asiáticos: arreglaremos nuestro propio desastre

Patrick Shen18 jul, 03:03

En su lanzamiento, Cluely afirmó que mataría a 9 industrias.

Estamos aquí para matar solo a uno: hacer trampa.

Conoce a Truely, la herramienta de código abierto que marca las entrevistas asistidas por IA en tiempo real. Funciona con Zoom, Meets, Teams y más.

El futuro de las entrevistas online ya está aquí.

1.97K

Para luchar contra los asiáticos, necesitas asiáticos

Patrick Shen18 jul, 03:03

En su lanzamiento, Cluely afirmó que mataría a 9 industrias.

Estamos aquí para matar solo a uno: hacer trampa.

Conoce a Truely, la herramienta de código abierto que marca las entrevistas asistidas por IA en tiempo real. Funciona con Zoom, Meets, Teams y más.

El futuro de las entrevistas online ya está aquí.

198

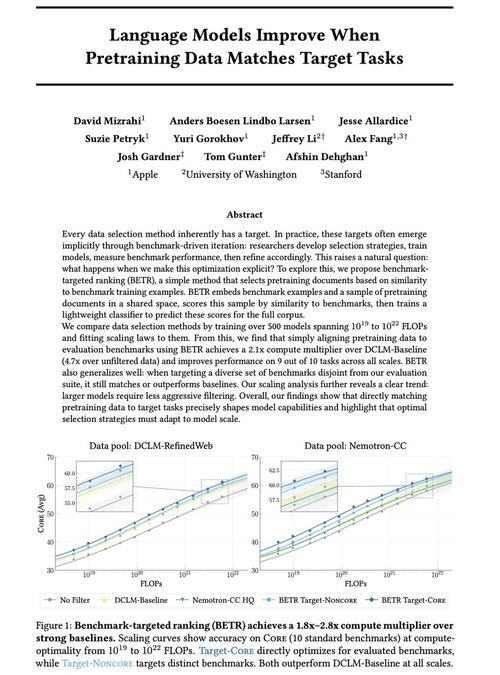

Por qué los equipos previos y posteriores a la formación deben llevarse bien

David Mizrahi18 jul, 06:21

Emocionado de compartir nuestro nuevo trabajo: "Los modelos de lenguaje mejoran cuando los datos de preentrenamiento coinciden con las tareas de destino"

Sí, suena obvio (¡y lo es!), pero normalmente esto solo sucede implícita e indirectamente: seleccione intuitivamente los datos → punto de referencia → refine → repita.

Nos preguntamos: ¿qué sucede si hacemos coincidir explícitamente los datos de preentrenamiento con los puntos de referencia? El resultado es un enfoque muy simple que produce multiplicadores de cómputo 2x + sobre líneas de base sólidas y nos brinda una forma basada en principios de estudiar cómo las opciones de referencia dan forma (¡y restringen!) las capacidades del modelo.

Bono: amplias leyes de escalado del entrenamiento de 500+ modelos que revelan cómo evoluciona la selección óptima de datos a medida que los modelos escalan.

🧵 (1/14)

2.65K

El equipo de Grok está internalizando las operaciones de datos humanos (por ejemplo, reclutando para el papel de tutor de IA para japonés). Es probable que más laboratorios fronterizos piensen en poseer y operar la mano de obra de datos.

Koki Ikeda | SoftBank15 jul, 22:12

"xAI", que está desarrollando Grok, está buscando un tutor de IA japonés.

El trabajo consiste en etiquetar y anotar datos de texto, audio y vídeo en japonés. Puede trabajar de forma totalmente remota desde Japón y el pago es a una tarifa por hora alta equivalente a los estándares estadounidenses.

🗣️ Hablante nativo de japonés

🧑 💻 Totalmente remoto

💰 Tarifa por hora de $35–65 (5200-9600 yenes)

🕐 Contrato de 6 meses (con posibilidad de prórroga)

8.34K

El equipo de Grok está internalizando las operaciones de datos humanos (por ejemplo, reclutando para el papel de tutor de IA para japonés). Dada la transición de Scale AI, es probable que más laboratorios de frontera piensen en poseer y operar la mano de obra de datos.

Koki Ikeda | SoftBank15 jul, 22:12

"xAI", que está desarrollando Grok, está buscando un tutor de IA japonés.

El trabajo consiste en etiquetar y anotar datos de texto, audio y vídeo en japonés. Puede trabajar de forma totalmente remota desde Japón y el pago es a una tarifa por hora alta equivalente a los estándares estadounidenses.

🗣️ Hablante nativo de japonés

🧑 💻 Totalmente remoto

💰 Tarifa por hora de $35–65 (5200-9600 yenes)

🕐 Contrato de 6 meses (con posibilidad de prórroga)

292

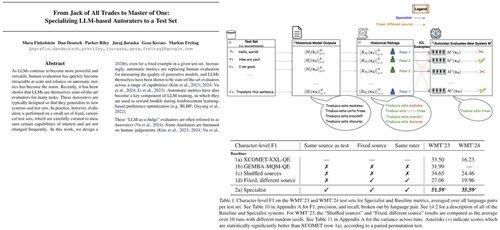

Si estás en ICML y estás interesado en RL o multilingüismo, ¡saluda a @marafinkels! Trabajamos en estrecha colaboración en los últimos meses para lanzar un método de RL para solucionar un problema crítico de calidad de Gemini. ¡Ella también tiene grandes ideas de investigación! Espero que Gemini x academia se mantengan en contacto.

Mara Finkelstein27 nov 2024

Los LLM generalmente se evalúan con métricas automáticas en conjuntos de pruebas estándar, pero las métricas + conjuntos de pruebas se desarrollan de forma independiente. Esto plantea una pregunta crucial: ¿Podemos diseñar métricas automáticas específicamente para sobresalir en los conjuntos de pruebas que priorizamos? Respuesta: ¡Sí!

5.73K

Shane Gu reposteó

Nueva entrada de blog sobre la asimetría de la verificación y la "ley del verificador":

La asimetría de la verificación, la idea de que algunas tareas son mucho más fáciles de verificar que de resolver, se está convirtiendo en una idea importante a medida que tenemos RL que finalmente funciona en general.

Grandes ejemplos de asimetría de verificación son cosas como los rompecabezas de sudoku, escribir el código para un sitio web como Instagram y los problemas de BrowseComp (se necesitan ~ 100 sitios web para encontrar la respuesta, pero fácil de verificar una vez que tiene la respuesta).

Otras tareas tienen casi simetría de verificación, como sumar dos números de 900 dígitos o algunos scripts de procesamiento de datos. Sin embargo, es mucho más fácil proponer soluciones factibles para otras tareas que verificarlas (por ejemplo, verificar un ensayo largo o establecer una nueva dieta como "solo come bisonte").

Una cosa importante que hay que entender sobre la asimetría de la verificación es que se puede mejorar la asimetría haciendo un poco de trabajo de antemano. Por ejemplo, si tienes la clave de respuestas para un problema de matemáticas o si tienes casos de prueba para un problema de Leetcode. Esto aumenta en gran medida el conjunto de problemas con la asimetría de verificación deseable.

La "ley del verificador" establece que la facilidad de entrenar a la IA para resolver una tarea es proporcional a la verificabilidad de la tarea. Todas las tareas que sean posibles de resolver y fáciles de verificar serán resueltas por la IA. La capacidad de entrenar a la IA para resolver una tarea es proporcional a si la tarea tiene las siguientes propiedades:

1. Verdad objetiva: todo el mundo está de acuerdo en lo que son las buenas soluciones

2. Rápido de verificar: cualquier solución dada se puede verificar en unos segundos

3. Escalable para verificar: se pueden verificar muchas soluciones simultáneamente

4. Bajo nivel de ruido: la verificación está lo más estrechamente relacionada posible con la calidad de la solución

5. Recompensa continua: es fácil clasificar la bondad de muchas soluciones para un solo problema

Un ejemplo obvio de la ley del verificador es el hecho de que la mayoría de los puntos de referencia propuestos en IA son fáciles de verificar y hasta ahora se han resuelto. Tenga en cuenta que prácticamente todos los puntos de referencia populares en los últimos diez años se ajustan a los criterios # 1-4; Los puntos de referencia que no cumplan con los criterios #1-4 tendrían dificultades para volverse populares.

¿Por qué es tan importante la verificabilidad? La cantidad de aprendizaje en IA que se produce se maximiza cuando se cumplen los criterios anteriores; Puede tomar muchos pasos de gradiente donde cada paso tiene mucha señal. La velocidad de iteración es fundamental: es la razón por la que el progreso en el mundo digital ha sido mucho más rápido que el progreso en el mundo físico.

AlphaEvolve de Google es uno de los mejores ejemplos de cómo aprovechar la asimetría de la verificación. Se centra en configuraciones que se ajustan a todos los criterios anteriores y ha dado lugar a una serie de avances en matemáticas y otros campos. A diferencia de lo que hemos estado haciendo en IA durante las últimas dos décadas, es un nuevo paradigma en el que todos los problemas se optimizan en un entorno en el que el conjunto de entrenamiento es equivalente al conjunto de prueba.

La asimetría de la verificación está en todas partes y es emocionante considerar un mundo de inteligencia irregular donde cualquier cosa que podamos medir se resolverá.

298.72K

El trabajo impactante que cualquiera puede hacer es usar los LLM para registrar y digitalizar la mayor parte de su flujo de trabajo, CoT e inspiración.

Ingeniería de contexto para automatizar y aumentar tu experiencia en la vida y el trabajo.

Thariq15 jul, 05:51

Diarios y tareas pendientes

Tengo algunos comandos personalizados:

/journal que creará una nueva entrada de diario para el día.

/todos un comando que me permitirá crear nuevas tareas pendientes o marcar otras como hechas. Las tareas pendientes se organizan por tema en archivos, por ejemplo, '

Claude a menudo busca en mi código, proyectos, etc. más contexto cuando agrego una tarea pendiente, lo cual es muy útil.

793

Populares

Ranking

Favoritas

Onchain en tendencia

Tendencia en X

Principales fondos recientes

Más destacadas