Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hvorfor team før og etter trening må komme overens

18. juli, 06:21

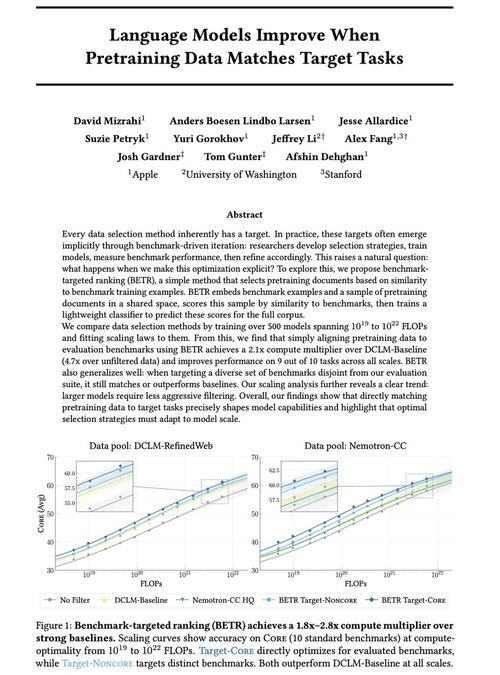

Glad for å dele vårt nye arbeid: "Språkmodeller forbedres når forhåndsopplæringsdata samsvarer med måloppgaver"

Ja, det høres åpenbart ut (og det er det!), men vanligvis skjer dette bare implisitt og indirekte: velg intuitivt data → benchmark → avgrense → gjenta.

Vi lurte på: hva skjer hvis vi eksplisitt matcher pretraining-data med benchmarks? Resultatet er en dødsenkel tilnærming som gir 2x+ beregningsmultiplikatorer over sterke grunnlinjer og gir oss en prinsipiell måte å studere hvordan referansevalg former (og begrenser!) modellfunksjoner.

Bonus: omfattende skaleringslover fra trening av 500+ modeller som avslører hvordan optimalt datautvalg utvikler seg etter hvert som modeller skaleres.

🧵 (1/14)

2,67K

Topp

Rangering

Favoritter