Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Por que as equipes de pré e pós-treinamento precisam se dar bem

18 de jul., 06:21

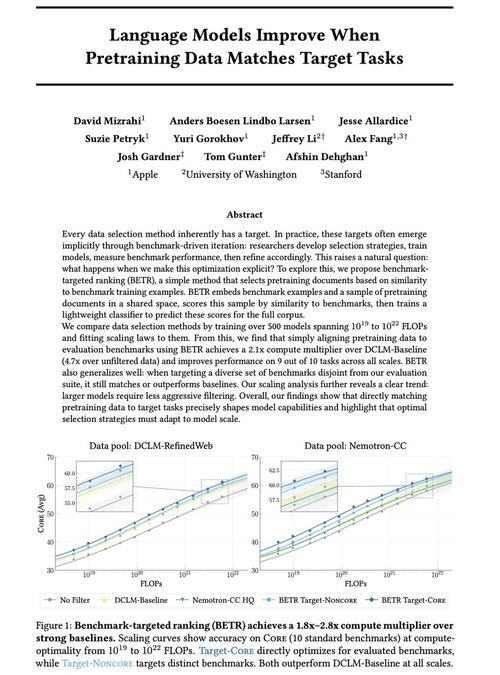

Animado para compartilhar nosso novo trabalho: "Os modelos de linguagem melhoram quando os dados de pré-treinamento correspondem às tarefas de destino"

Sim, parece óbvio (e é!), mas normalmente isso só acontece implícita e indiretamente: selecione intuitivamente os dados → benchmark → refine → repita.

Nós nos perguntamos: o que acontece se combinarmos explicitamente os dados de pré-treinamento com os benchmarks? O resultado é uma abordagem muito simples que produz multiplicadores de computação 2x+ em linhas de base fortes e nos dá uma maneira baseada em princípios de estudar como as escolhas de benchmark moldam (e restringem!) os recursos do modelo.

Bônus: extensas leis de dimensionamento do treinamento de 500+ modelos que revelam como a seleção de dados ideal evolui à medida que os modelos são dimensionados.

🧵 (1/14)

2,68K

Melhores

Classificação

Favoritos