Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Чому команди до та після тренування мають ладнати

18 лип., 06:21

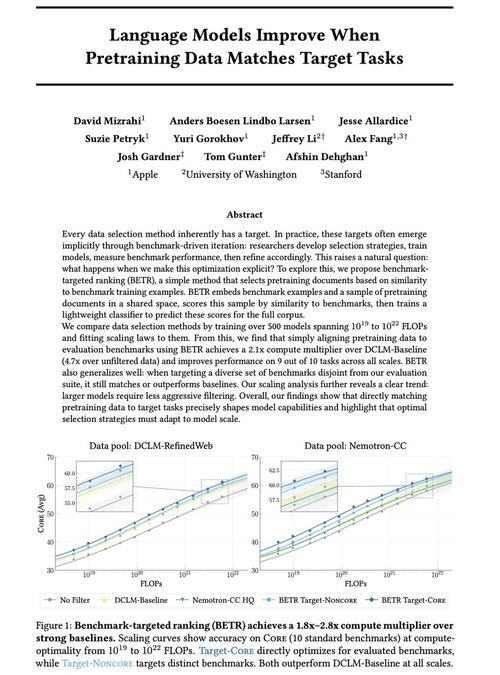

Раді поділитися нашою новою роботою: "Мовні моделі вдосконалюються, коли дані попереднього навчання відповідають цільовим завданням"

Так, це звучить очевидно (і це так!), але зазвичай це відбувається лише неявно і опосередковано: інтуїтивно вибираєте дані → бенчмарку → уточнюєте → повторюєте.

Ми задалися питанням: що станеться, якщо ми явно зіставимо дані передтренувальної підготовки з бенчмарками? Результатом є надзвичайно простий підхід, який дає множники обчислень 2x+ над сильними базовими лініями та дає нам принциповий спосіб вивчити, як вибір еталонних показників формує (і обмежує!) можливості моделі.

Бонус: широкі закони масштабування з навчання 500+ моделей, які показують, як оптимальний відбір даних еволюціонує в міру масштабування моделей.

🧵 (1/14)

2,67K

Найкращі

Рейтинг

Вибране