Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jag är oerhört entusiastisk över potentialen i tankekedjans trofasthet och tolkningsbarhet. Det har i hög grad påverkat utformningen av våra resonemangsmodeller, med början med o1-preview.

I takt med att AI-system ägnar mer tid åt att arbeta med t.ex. långsiktiga forskningsproblem är det viktigt att vi har något sätt att övervaka deras interna process. Den underbara egenskapen hos dolda CoT:er är att även om de till en början är grundade i ett språk som vi kan tolka, är den skalbara optimeringsproceduren inte fientlig mot observatörens förmåga att verifiera modellens avsikt - till skillnad från t.ex. direkt övervakning med en belöningsmodell.

Spänningen här är att om CoTs inte var dolda som standard, och vi ser processen som en del av AI:ns resultat, finns det många incitament (och i vissa fall nödvändighet) att sätta övervakning på den. Jag tror att vi kan arbeta mot det bästa av två världar här - träna våra modeller att vara bra på att förklara sitt interna resonemang, men samtidigt behålla förmågan att ibland verifiera det.

CoT-trohet är en del av en bredare forskningsinriktning, som är träning i tolkningsbarhet: att sätta upp mål på ett sätt som tränar åtminstone en del av systemet att förbli ärligt och kontrollerbart i stor skala. Vi fortsätter att öka våra investeringar i denna forskning på OpenAI.

16 juli 00:09

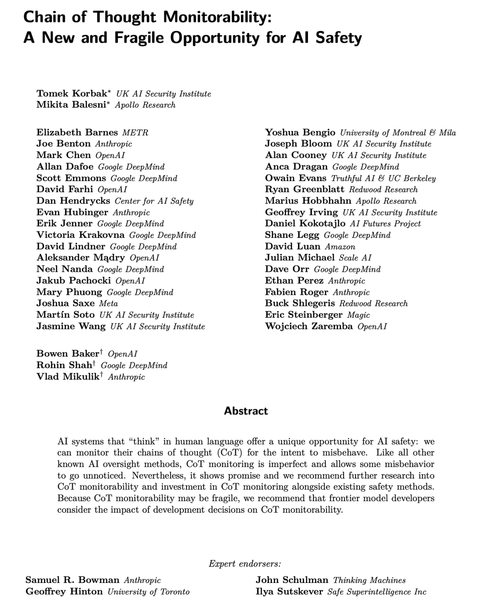

Moderna resonemangsmodeller tänker på vanlig engelska.

Att övervaka deras tankar kan vara ett kraftfullt, men ömtåligt, verktyg för att övervaka framtida AI-system.

Jag och forskare i många organisationer anser att vi bör arbeta för att utvärdera, bevara och till och med förbättra CoT-övervakningen.

264,21K

Topp

Rankning

Favoriter