Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Estoy muy entusiasmado con el potencial de la fidelidad e interpretabilidad de la cadena de pensamiento. Ha influido significativamente en el diseño de nuestros modelos de razonamiento, empezando por o1-preview.

A medida que los sistemas de IA dedican más tiempo a trabajar en cómputo, por ejemplo, en problemas de investigación a largo plazo, es fundamental que tengamos alguna forma de supervisar su proceso interno. La maravillosa propiedad de los CoT ocultos es que, si bien comienzan basados en un lenguaje que podemos interpretar, el procedimiento de optimización escalable no es contradictorio con la capacidad del observador para verificar la intención del modelo, a diferencia, por ejemplo, de la supervisión directa con un modelo de recompensa.

La tensión aquí es que si los CoT no estaban ocultos de forma predeterminada, y vemos el proceso como parte de la salida de la IA, hay muchos incentivos (y en algunos casos, necesidad) para supervisarlo. Creo que podemos trabajar hacia lo mejor de ambos mundos aquí: entrenar a nuestros modelos para que sean excelentes explicando su razonamiento interno, pero al mismo tiempo conserven la capacidad de verificarlo ocasionalmente.

La fidelidad del CoT es parte de una dirección de investigación más amplia, que es el entrenamiento para la interpretabilidad: establecer objetivos de una manera que entrene al menos a una parte del sistema para que siga siendo honesto y monitoreable con escala. Seguimos aumentando nuestra inversión en esta investigación en OpenAI.

16 jul, 00:09

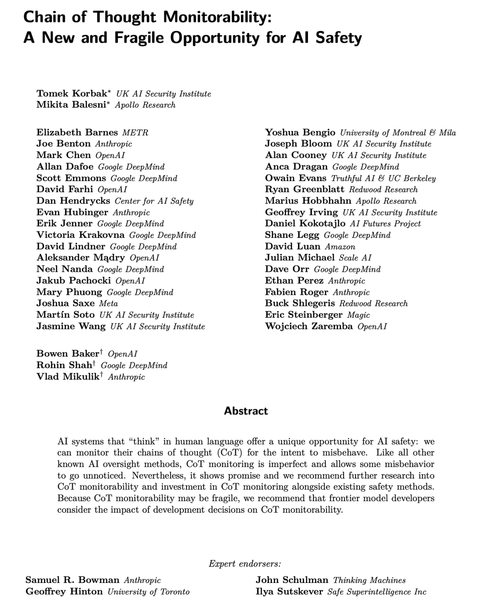

Los modelos de razonamiento modernos piensan en un lenguaje sencillo.

El seguimiento de sus pensamientos podría ser una herramienta poderosa, aunque frágil, para supervisar los futuros sistemas de IA.

Yo y los investigadores de muchas organizaciones pensamos que deberíamos trabajar para evaluar, preservar e incluso mejorar la capacidad de supervisión del CoT.

264.13K

Populares

Ranking

Favoritas