Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Je suis extrêmement enthousiaste à propos du potentiel de la fidélité et de l'interprétabilité en chaîne de pensée. Cela a significativement influencé la conception de nos modèles de raisonnement, en commençant par o1-preview.

Alors que les systèmes d'IA consacrent plus de puissance de calcul à des problèmes de recherche à long terme, il est crucial que nous ayons un moyen de surveiller leur processus interne. La merveilleuse propriété des CoTs cachés est que, bien qu'ils commencent ancrés dans un langage que nous pouvons interpréter, la procédure d'optimisation évolutive n'est pas adversaire à la capacité de l'observateur à vérifier l'intention du modèle - contrairement, par exemple, à la supervision directe avec un modèle de récompense.

La tension ici est que si les CoTs n'étaient pas cachés par défaut, et que nous considérions le processus comme faisant partie de la sortie de l'IA, il y aurait beaucoup d'incitation (et dans certains cas, de nécessité) à y mettre de la supervision. Je crois que nous pouvons travailler vers le meilleur des deux mondes ici - former nos modèles à être excellents pour expliquer leur raisonnement interne, tout en conservant la capacité de le vérifier occasionnellement.

La fidélité des CoT fait partie d'une direction de recherche plus large, qui est la formation à l'interprétabilité : définir des objectifs de manière à former au moins une partie du système à rester honnête et surveillable à grande échelle. Nous continuons à augmenter notre investissement dans cette recherche chez OpenAI.

16 juil., 00:09

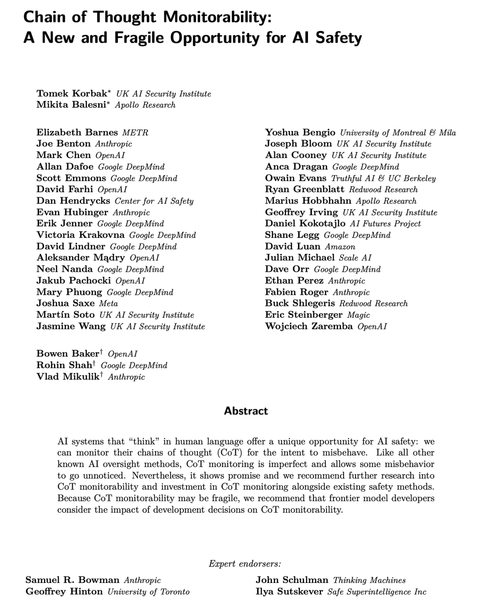

Les modèles de raisonnement modernes pensent en anglais simple.

Surveiller leurs pensées pourrait être un outil puissant, mais fragile, pour superviser les futurs systèmes d'IA.

Moi et des chercheurs de nombreuses organisations pensons que nous devrions travailler à évaluer, préserver et même améliorer la surveillabilité de CoT.

264,14K

Meilleurs

Classement

Favoris