Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Varför du bör sluta arbeta med RL-forskning och istället arbeta med produkt //

Tekniken som låste upp det stora skalningsskiftet inom AI är internet, inte transformatorer

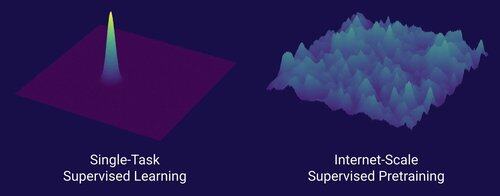

Jag tror att det är välkänt att data är det viktigaste inom AI, och att forskare väljer att inte arbeta med det ändå. ... Vad innebär det att arbeta med data (på ett skalbart sätt)?

Internet tillhandahöll en rik källa till rikligt med data, som var mångsidigt, gav en naturlig läroplan, representerade de kompetenser som människor faktiskt bryr sig om och var en ekonomiskt lönsam teknik att distribuera i stor skala – det blev det perfekta komplementet till nästa token-förutsägelse och var den ursprungliga soppan för AI att ta fart.

Utan transformatorer hade hur många tillvägagångssätt som helst kunnat ta fart, vi skulle förmodligen ha haft CNN eller statliga rymdmodeller på GPT-4.5-nivå. Men det har inte skett någon dramatisk förbättring av basmodellerna sedan GPT-4. Resonemangsmodeller är bra inom smala domäner, men inte ett lika stort steg som GPT-4 var i mars 2023 (för över 2 år sedan...)

Vi har något bra med reinforcement learning, men min djupa rädsla är att vi kommer att upprepa misstagen från det förflutna (2015-2020 era RL) och göra RL-forskning som inte spelar någon roll.

På det sätt som internet var dubbeln av övervakad förträning, vad kommer att vara dubbeln av RL som kommer att leda till ett massivt framsteg som GPT-1 -> GPT-4? Jag tycker att det ser ut som forskning-produkt-co-design.

389,68K

Topp

Rankning

Favoriter