Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Por qué deberías dejar de trabajar en la investigación de RL y en su lugar trabajar en el producto //

La tecnología que desbloqueó el gran cambio de escala en la IA es Internet, no los transformadores

Creo que es bien sabido que los datos son lo más importante en la IA, y también que los investigadores eligen no trabajar en ellos de todos modos. ... ¿Qué significa trabajar con datos (de forma escalable)?

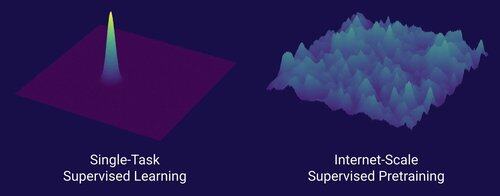

Internet proporcionaba una rica fuente de datos abundantes, que eran diversos, proporcionaban un plan de estudios natural, representaban las competencias que realmente interesan a la gente y era una tecnología económicamente viable para implementar a escala: se convirtió en el complemento perfecto para la predicción del próximo token y fue la sopa primordial para el despegue de la IA.

Sin transformadores, cualquier número de enfoques podría haber despegado, probablemente podríamos tener CNN o modelos de espacio de estados al nivel de GPT-4.5. Pero no ha habido una mejora dramática en los modelos base desde GPT-4. Los modelos de razonamiento son excelentes en dominios estrechos, pero no un salto tan grande como lo fue GPT-4 en marzo de 2023 (hace más de 2 años...)

Tenemos algo genial con el aprendizaje por refuerzo, pero mi miedo profundo es que repitamos los errores del pasado (RL de la era 2015-2020) y hagamos investigaciones de RL que no importan.

De la misma manera que Internet fue el dual del preentrenamiento supervisado, ¿cuál será el dual de RL que conducirá a un avance masivo como GPT-1 > GPT-4? Creo que se parece a un codiseño de productos de investigación.

389.66K

Populares

Ranking

Favoritas