Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Waarom je zou moeten stoppen met werken aan RL-onderzoek en in plaats daarvan aan producten zou moeten werken //

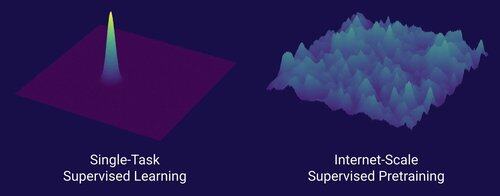

De technologie die de grote schaalverschuiving in AI heeft ontgrendeld, is het internet, niet transformers.

Ik denk dat het algemeen bekend is dat data het belangrijkste is in AI, en ook dat onderzoekers ervoor kiezen om er niet aan te werken. ... Wat betekent het om op data te werken (op een schaalbare manier)?

Het internet bood een rijke bron van overvloedige data, die divers was, een natuurlijke leerroute bood, de competenties vertegenwoordigde waar mensen daadwerkelijk om geven, en een economisch levensvatbare technologie was om op grote schaal in te zetten -- het werd de perfecte aanvulling op next-token voorspelling en was de oersoep voor AI om van de grond te komen.

Zonder transformers hadden verschillende benaderingen kunnen opkomen, we zouden waarschijnlijk CNN's of toestandsruimte-modellen op het niveau van GPT-4.5 kunnen hebben. Maar er is sinds GPT-4 geen dramatische verbetering in basismodellen geweest. Redeneringsmodellen zijn geweldig in smalle domeinen, maar niet zo'n grote sprong als GPT-4 was in maart 2023 (meer dan 2 jaar geleden...)

We hebben iets geweldigs met reinforcement learning, maar mijn diepe vrees is dat we de fouten uit het verleden (de RL-periode van 2015-2020) zullen herhalen en RL-onderzoek doen dat er niet toe doet.

Op de manier waarop het internet de tegenhanger was van gesuperviseerde pretraining, wat zal de tegenhanger van RL zijn die zal leiden tot een enorme vooruitgang zoals GPT-1 -> GPT-4? Ik denk dat het eruitziet als onderzoek-product co-ontwerp.

389,67K

Boven

Positie

Favorieten