Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Alexander Long

Grundare @PluralisHQ | ML PhD

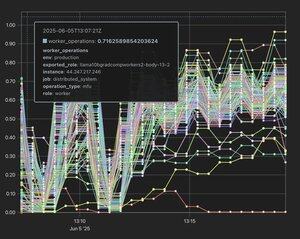

Protokollinlärning: Parallell modell med flera deltagare och låg bandbredd

Noam har en tendens att inte överdriva.

Noam Brown19 juli 15:52

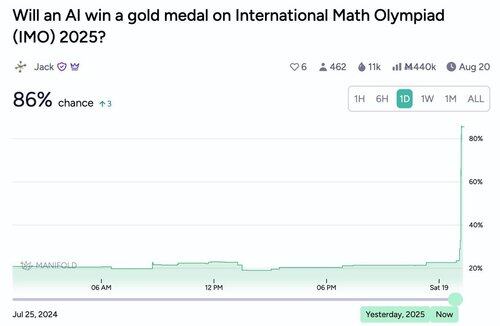

Vart tar det här vägen? Så snabbt som de senaste AI-framstegen har varit, förväntar jag mig att trenden kommer att fortsätta. Det är viktigt att påpeka att jag tror att vi är nära att AI i hög grad bidrar till vetenskapliga upptäckter. Det är stor skillnad mellan AI som ligger strax under den mänskliga toppprestationen jämfört med den som ligger något ovanför.

825

Håller helt med - Flower labs är en annan grupp som aktivt publicerar bra saker och nu helt och hållet fokuserar på decentraliserad utbildning. Borde vara en viktig datapunkt för alla som fortfarande är skeptiska till området - flower team är så legitimt som det kan bli och Nic Lane är ganska mycket toppen av toppen i Federated Learning.

Varenda signal till mig är att vi är på väg att bevittna en massiv akademisk brytpunkt inom detta område på ML-sidan. Egentligen inte ens contrarian längre, det har flyttats från det till bara tydligt tidiga dagar av vad som kommer att bli ett stort och mycket effektfullt område.

nic lane16 juli 19:35

Grattis på pappret @_AlexanderLong. Men du utelämnade @flwrlabs som publicerade ett fullständigt system (foton) med validerad in-the-wild, helt decentraliserad träning upp till 13B @MLSysConf. Tillsammans med en nyckelteknik för den decentraliserade stacken (frikopplade inbäddningar) som publiceras som en muntlig @iclr_conf. Detta var ett arbete som gjordes tillsammans med @CaMLSys på @Cambridge_Uni.

1,05K

Alexander Long delade inlägget

Av min erfarenhet kan det vara ganska svårt att få ett papper om decentraliserat DL accepterat till konferenser på toppnivå. Motivationen är inte bekant för många granskare, och standardinställningarna för experiment tar inte hänsyn till de problem som du försöker lösa.

Därför är jag väldigt spänd på att se företag som @PluralisHQ och @PrimeIntellect satsa på att dela med sig av sina resultat och få dem publicerade på stora konferenser! IMO, till och med att förbereda inlämningen tvingar dig att vara mer noggrann med dina experiment + extern feedback från granskare hjälper dig att vässa artikelns budskap.

7,28K

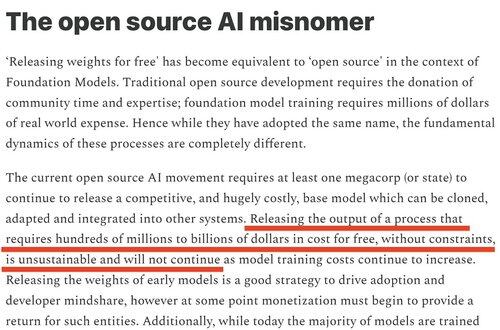

Känns som att meta stängningsmodeller var väldigt förutsägbara. Jag sa uttryckligen att detta skulle hända förra året och förklarade varför (från ).

Shane Gu15 juli 05:35

RIP till enhörningens AI-startups som har noll produkter, noll foundation-modeller och som bara skulle vara beroende av stora laboratorier som släpper modeller med öppen källkod gratis för att modellera sammanslagning. Jag känner en eller två.

3,66K

Alexander Long delade inlägget

Talade 50 minuter i sträck inför ett fullsatt rum med knäckta AI-forskare på ICML och presenterade arbete av @akashnet_, @PrimeIntellect, @gensynai, @NousResearch, @PluralisHQ och @GoogleDeepMind.

Det finns nu ett enormt intresse för DeAI.

Uppdraget är (delvis) slutfört.

10,78K

För personer som inte är bekanta med AI-publicering; Det finns 3 huvudkonferenser varje år. ICML, ICLR och NeurIPS. Dessa är tekniska konferenser och motsvarigheten till tidskrifter inom andra discipliner – de är den huvudsakliga publiceringsplatsen för AI. Konkurrensen om att ha artiklar på dessa konferenser är nu på en löjlig nivå, att få artiklar accepterade är mycket svårt, och det finns en hel del oro över granskningsprocessen som är ganska bullrig vid denna tidpunkt. En stark uppsats utan brister har cirka 50 % chans att bli accepterad, och vanligtvis skickas en uppsats in med granskarändringar flera gånger tills den accepteras. Trots allt detta är artiklar på dessa arenor fortfarande den primära stämpeln för legitimitet i AI-världen, och är förmodligen fortfarande de primära karriärmåtten för ML-forskare (även om detta försvagas imo eftersom så mycket av forskningen i gränslaboratorierna är opublicerad).

Main Track-papper skiljer sig markant från verkstadspapper. Huvudspåret har en intensiv och seriös peer review. Workshoppapper är för förarbeten, som ger en indikation på ett intressant resultat, men som antingen inte är färdiga eller så är resultatet inte tillräckligt signifikant för huvudspåret. De behöver bara granskas av workshopens granskarpool och de visas inte i förfarandet.

Många bra papper har först dykt upp i workshops (t.ex. grokking) - men workshop- och huvudspårspapper är fundamentalt olika saker, med en fundamentalt annorlunda nivå av inverkan. De enda två bolagen inom decentraliserad AI som har huvudspår i år är @PrimeIntellect och Pluralis.

18,8K

Topp

Rankning

Favoriter

Trendande på kedjan

Trendande på X

Senaste toppfinansieringarna

Mest anmärkningsvärda