Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Alexander Long

Gründer @PluralisHQ | ML PhD

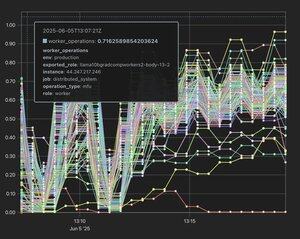

Protokolllernen: Mehrteiliges Modell mit geringer Bandbreite parallel

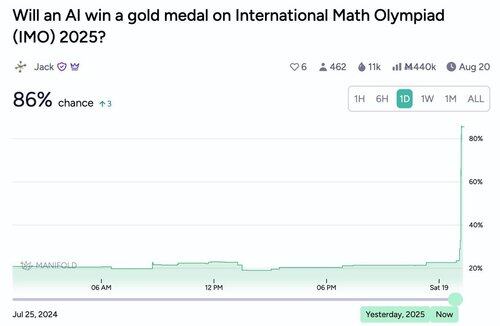

Noam neigt dazu, nicht zu übertreiben.

Noam Brown19. Juli, 15:52

Wohin führt das? So schnell wie der jüngste Fortschritt in der KI war, erwarte ich, dass der Trend anhält. Wichtig ist, dass ich denke, dass wir kurz davor stehen, dass KI erheblich zur wissenschaftlichen Entdeckung beiträgt. Es gibt einen großen Unterschied zwischen KI, die leicht unter der besten menschlichen Leistung liegt, und KI, die leicht darüber liegt.

757

Ich stimme vollkommen zu - Flower Labs ist eine weitere Gruppe, die aktiv großartige Inhalte veröffentlicht und sich jetzt ganz auf dezentrales Training konzentriert. Das sollte ein wichtiger Anhaltspunkt für alle sein, die in diesem Bereich noch skeptisch sind - das Flower-Team ist so legitim, wie es nur geht, und Nic Lane ist praktisch an der Spitze des Pinnacles im Bereich des föderierten Lernens.

Jedes einzelne Signal deutet für mich darauf hin, dass wir kurz davor stehen, einen massiven akademischen Wendepunkt in diesem Bereich auf der ML-Seite zu erleben. Es ist nicht einmal mehr konträr, es hat sich von dieser Position zu den klaren frühen Tagen dessen entwickelt, was ein bedeutendes und sehr einflussreiches Feld werden wird.

nic lane16. Juli, 19:35

Herzlichen Glückwunsch zum Paper @_AlexanderLong. Aber du hast @flwrlabs vergessen, die ein vollständiges System (Photon) veröffentlicht haben, mit validiertem, vollständig dezentralisiertem Training in der Praxis bis zu 13B @MLSysConf. Zusammen mit einer Schlüsseltechnik des dezentralen Stacks (entkoppelte Embeddings), die als mündlicher Beitrag @iclr_conf veröffentlicht wurde. Dies war eine Arbeit, die zusammen mit @CaMLSys bei @Cambridge_Uni durchgeführt wurde.

993

Alexander Long erneut gepostet

Aus meiner Erfahrung kann es ziemlich schwierig sein, ein Paper über dezentrale DL bei hochkarätigen Konferenzen akzeptiert zu bekommen. Die Motivation ist vielen Gutachtern nicht vertraut, und die standardmäßigen Experimentiereinstellungen berücksichtigen nicht die Probleme, die Sie lösen möchten.

Daher bin ich sehr gespannt zu sehen, dass Unternehmen wie @PluralisHQ und @PrimeIntellect die Mühe investieren, ihre Ergebnisse zu teilen und sie auf großen Konferenzen zu veröffentlichen! Meiner Meinung nach zwingt Sie bereits die Vorbereitung der Einreichung dazu, rigoroser mit Ihren Experimenten umzugehen, und das Feedback von Gutachtern hilft Ihnen, die Botschaft des Papers zu schärfen.

7,23K

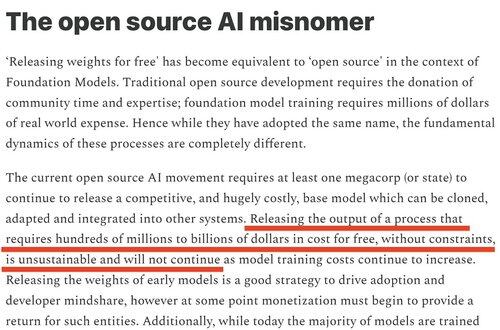

Ich hatte das Gefühl, dass das Schließen der Meta-Modelle sehr vorhersehbar war. Ich habe ausdrücklich gesagt, dass dies letztes Jahr passieren würde und erklärt, warum (von ).

Shane Gu15. Juli, 05:35

Ruhe in Frieden für die Einhorn-AI-Startups, die null Produkte, null Basis-Modelle haben und einfach darauf angewiesen waren, dass große Labore Open-Source-Modelle kostenlos veröffentlichen, um sie zu kombinieren. Ich kenne ein oder zwei.

3,6K

Alexander Long erneut gepostet

50 Minuten lang ohne Unterbrechung vor einem vollbesetzten Raum von KI-Forschern bei ICML gesprochen und Arbeiten von @akashnet_, @PrimeIntellect, @gensynai, @NousResearch, @PluralisHQ und @GoogleDeepMind präsentiert.

Es gibt jetzt ein enormes Interesse an DeAI.

Mission (teilweise) erfüllt.

10,77K

Für Menschen, die mit der Veröffentlichung von KI nicht vertraut sind, gibt es jedes Jahr 3 Hauptkonferenzen: ICML, ICLR und NeurIPS. Dies sind technische Konferenzen und das Äquivalent zu Fachzeitschriften in anderen Disziplinen - sie sind der Hauptveröffentlichungsort für KI. Der Wettbewerb, um auf diesen Konferenzen Papers zu haben, ist mittlerweile auf einem lächerlichen Niveau, es ist sehr schwierig, Papers akzeptiert zu bekommen, und es gibt viele Bedenken hinsichtlich des Überprüfungsprozesses, der zu diesem Zeitpunkt ziemlich laut ist. Ein starkes Paper ohne Mängel hat etwa eine 50%ige Chance, akzeptiert zu werden, und typischerweise wird ein Paper mehrere Male mit Änderungen der Gutachter eingereicht, bis es akzeptiert wird. Trotz alledem bleiben Papers in diesen Veranstaltungsorten der primäre Stempel der Legitimität in der KI-Welt und sind wahrscheinlich immer noch die primären Karrieremetriken für ML-Forscher (obwohl dies meiner Meinung nach schwächer wird, da so viel der Forschung in den Grenzlabors unveröffentlicht ist).

Haupttrack-Papers unterscheiden sich erheblich von Workshop-Papers. Der Haupttrack hat eine intensive, ernsthafte Peer-Review. Workshop-Papers sind für vorläufige Arbeiten, die einen Hinweis auf ein interessantes Ergebnis geben, aber entweder nicht vollständig sind oder das Ergebnis nicht signifikant genug für den Haupttrack ist. Sie müssen nur von dem Gutachterpool des Workshops überprüft werden und erscheinen nicht in den Proceedings.

Viele großartige Papers sind zuerst in Workshops erschienen (z.B. Grokking) - aber Workshop- und Haupttrack-Papers sind grundlegend unterschiedliche Dinge, mit einem grundlegend unterschiedlichen Einflussniveau. Die einzigen beiden Unternehmen im dezentralen KI-Bereich, die in diesem Jahr Haupttrack-Papers haben, sind @PrimeIntellect und Pluralis.

18,75K

Top

Ranking

Favoriten

Onchain-Trends

Im Trend auf X

Aktuelle Top-Finanzierungen

Am bemerkenswertesten