Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Alexander Long

Fundador @PluralisHQ | Doctorado ML

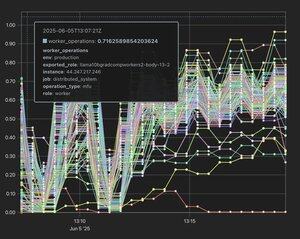

Aprendizaje de protocolos: Paralelo de modelo multiparticipante y de bajo ancho de banda

Noam tiende a no exagerar.

Noam Brown19 jul, 15:52

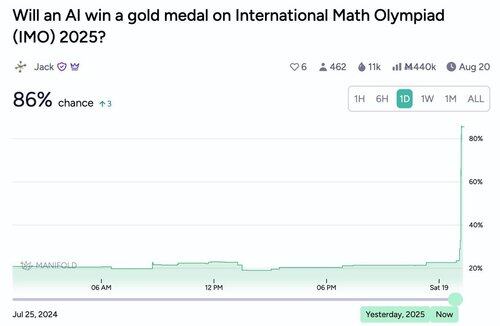

¿A dónde va esto? Tan rápido como ha sido el progreso reciente de la IA, espero que la tendencia continúe. Es importante, creo que estamos cerca de que la IA contribuya sustancialmente al descubrimiento científico. Hay una gran diferencia entre la IA que está ligeramente por debajo del rendimiento humano superior y la que está ligeramente por encima.

794

Totalmente de acuerdo: Flower labs es otro grupo que publica cosas excelentes y ahora está completamente enfocado en la formación descentralizada. Debería ser un punto de referencia importante para todos los que aún son escépticos en esta área: el equipo de Flower es tan legítimo como se puede ser y Nic Lane está prácticamente en la cima del pináculo en Aprendizaje Federado.

Cada señal para mí indica que estamos a punto de presenciar un enorme punto de inflexión académico en esta área del lado del ML. Ya no es realmente contracorriente, ha pasado de eso a ser claramente los primeros días de lo que se convertirá en un campo importante y muy impactante.

nic lane16 jul, 19:35

Felicidades por el artículo @_AlexanderLong. Pero te olvidaste de @flwrlabs, que publicó un sistema completo (photon) con entrenamiento totalmente descentralizado validado en el mundo real de hasta 13B en @MLSysConf. Junto con una técnica clave de la pila descentralizada (embeddings desacoplados) publicada como una presentación oral en @iclr_conf. Este fue un trabajo realizado junto con @CaMLSys en @Cambridge_Uni.

1,02K

Alexander Long republicó

Desde mi experiencia, conseguir que un artículo sobre DL descentralizado sea aceptado en conferencias de alto nivel puede ser bastante difícil. La motivación no es familiar para muchos revisores, y los ajustes experimentales estándar no tienen en cuenta los problemas que intentas resolver.

Por lo tanto, estoy muy emocionado de ver a empresas como @PluralisHQ y @PrimeIntellect invirtiendo el esfuerzo para compartir sus resultados y publicarlos en conferencias importantes. En mi opinión, incluso preparar la presentación te obliga a ser más riguroso con tus experimentos y la retroalimentación externa de los revisores te ayuda a afinar el mensaje del artículo.

7,24K

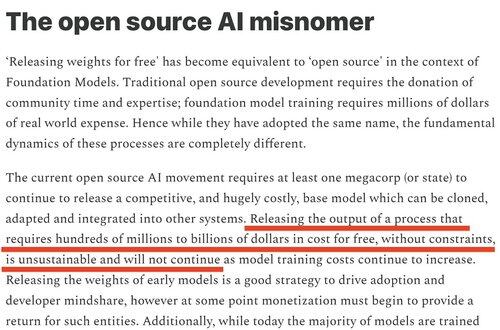

Sentí que el cierre de modelos de meta era muy predecible. Dije explícitamente que esto sucedería el año pasado y expliqué por qué (de ).

Shane Gu15 jul, 05:35

Descanse en paz a las startups de IA unicornio que no tienen productos, ni modelos de base, y que solo iban a depender de grandes laboratorios que lanzan modelos de código abierto de forma gratuita para fusionar modelos. Conozco una o dos.

3,62K

Alexander Long republicó

Hablé 50 minutos seguidos ante una sala llena de investigadores de IA entusiastas en ICML, presentando el trabajo de @akashnet_, @PrimeIntellect, @gensynai, @NousResearch, @PluralisHQ y @GoogleDeepMind.

Ahora hay un enorme interés en DeAI.

Misión (parcialmente) cumplida.

10,77K

Para las personas que no están familiarizadas con la publicación de IA; hay 3 conferencias principales cada año. ICML, ICLR y NeurIPS. Estas son conferencias técnicas y el equivalente a revistas en otras disciplinas: son el principal lugar de publicación para la IA. La competencia para tener artículos en estas conferencias ahora está en un nivel ridículo, conseguir que acepten artículos es muy difícil, y hay mucha preocupación sobre el proceso de revisión, que en este momento es bastante ruidoso. Un artículo sólido sin fallos tiene alrededor de un 50% de posibilidades de ser aceptado, y típicamente un artículo se presenta con cambios de los revisores varias veces hasta que es aceptado. A pesar de todo eso, los artículos en estos lugares siguen siendo el principal sello de legitimidad en el mundo de la IA, y probablemente siguen siendo las principales métricas de carrera para los investigadores de ML (aunque esto está debilitándose, en mi opinión, ya que gran parte de la investigación en los laboratorios de frontera no está publicada).

Los artículos de la pista principal son significativamente diferentes a los artículos de los talleres. La pista principal tiene una revisión por pares intensa y seria. Los artículos de los talleres son para trabajos preliminares, que dan alguna indicación de un resultado interesante, pero que están incompletos o el resultado no es lo suficientemente significativo para la pista principal. Solo se requiere que sean revisados por el grupo de revisores del taller y no aparecen en las actas.

Muchos grandes artículos han aparecido por primera vez en talleres (por ejemplo, grokking) - pero los artículos de talleres y de la pista principal son cosas fundamentalmente diferentes, con un nivel de impacto fundamentalmente diferente. Las únicas dos empresas en IA descentralizada que tienen artículos de la pista principal este año son @PrimeIntellect y Pluralis.

18,77K

Parte superior

Clasificación

Favoritos

En tendencia on-chain

En tendencia en X

Principales fondos recientes

Más destacado