Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jason Wei

Cercetător AI @openai

Jason Wei a repostat

📣 Suntem încântați să împărtășim studiul nostru din lumea reală al unui copilot clinic LLM, o colaborare între @OpenAI și @PendaHealth.

În 39.849 de vizite de pacienți în direct, clinicienii cu AI au avut o reducere relativă de 16% a erorilor de diagnostic și o reducere de 13% a erorilor de tratament față de cei fără. 🧵

197,77K

Jason Wei a repostat

Aceasta este prelegerea mea de acum 2 luni la @Cornell

"Cum îmi măresc producția?" Un răspuns firesc este "Voi mai lucra câteva ore". Munca mai lungă poate ajuta, dar în cele din urmă atingi o limită fizică.

O întrebare mai bună este: "Cum îmi cresc producția fără a crește atât de mult intrarea?" Aceasta este pârghie.

Auzim "pârghie" atât de des încât implicația sa este ușor de trecut cu vederea. Clasificarea mea preferată a pârghiei este de Naval Ravikant: muncă umană, capital și cod / media. Fiecare a alimentat valuri majore de creare de bogăție în istorie.

Cu toate acestea, odată ce o sursă de levier devine populară (gândiți-vă la canalele YouTube de astăzi față de acum zece ani), concurența comprimă marja. Deci, atunci când apare un nou efect de levier, este o șansă rară pentru câștiguri supradimensionate.

În acest discurs, descriu AI ca fiind acea pârghie emergentă. Un agent AI combină pârghia forței de muncă (funcționează pentru tine și este fără permisiune) cu pârghia codului (o poți copia și lipi).

Este un clișeu să spui că AI va crea o bogăție masivă. Dar utilizarea acestei lentile de pârghie ne permite să interpretăm ciclul zgomotos de știri AI într-un mod consecvent și să identificăm oportunitățile reale.

Mulțumesc @unsojo că m-ai găzduit!

402,4K

O nouă postare pe blog despre asimetria verificării și "legea verificatorului":

Asimetria verificării – ideea că unele sarcini sunt mult mai ușor de verificat decât de rezolvat – devine o idee importantă, deoarece avem RL care funcționează în sfârșit în general.

Exemple grozave de asimetrie a verificării sunt lucruri precum puzzle-urile sudoku, scrierea codului pentru un site web precum instagram și problemele BrowseComp (durează ~ 100 de site-uri web pentru a găsi răspunsul, dar ușor de verificat odată ce aveți răspunsul).

Alte sarcini au aproape simetrie de verificare, cum ar fi însumarea a două numere de 900 de cifre sau unele scripturi de procesare a datelor. Cu toate acestea, alte sarcini sunt mult mai ușor de propus soluții fezabile decât de a le verifica (de exemplu, verificarea unui eseu lung sau afirmarea unei noi diete precum "mănâncă doar bizoni").

Un lucru important de înțeles despre asimetria verificării este că puteți îmbunătăți asimetria făcând ceva muncă în prealabil. De exemplu, dacă aveți cheia de răspuns la o problemă de matematică sau dacă aveți cazuri de testare pentru o problemă Leetcode. Acest lucru crește foarte mult setul de probleme cu asimetria de verificare dezirabilă.

"Legea verificatorului" afirmă că ușurința de a antrena AI pentru a rezolva o sarcină este proporțională cu cât de verificabilă este sarcina. Toate sarcinile care sunt posibile de rezolvat și ușor de verificat vor fi rezolvate de AI. Capacitatea de a antrena AI pentru a rezolva o sarcină este proporțională cu faptul dacă sarcina are următoarele proprietăți:

1. Adevărul obiectiv: toată lumea este de acord ce sunt soluțiile bune

2. Rapid de verificat: orice soluție dată poate fi verificată în câteva secunde

3. Scalabil de verificat: multe soluții pot fi verificate simultan

4. Zgomot redus: verificarea este cât se poate de strâns corelată cu calitatea soluției

5. Recompensă continuă: este ușor să clasifici bunătatea mai multor soluții pentru o singură problemă

O instanțiere evidentă a legii verificatorului este faptul că majoritatea benchmark-urilor propuse în AI sunt ușor de verificat și până acum au fost rezolvate. Observați că practic toate reperele populare din ultimii zece ani se încadrează în criteriile #1-4; Benchmark-urile care nu îndeplinesc criteriile #1-4 ar avea dificultăți să devină populare.

De ce este atât de importantă verificabilitatea? Cantitatea de învățare în AI care are loc este maximizată atunci când sunt îndeplinite criteriile de mai sus; Puteți face o mulțime de pași de gradient în care fiecare pas are mult semnal. Viteza de iterație este critică – este motivul pentru care progresul în lumea digitală a fost mult mai rapid decât progresul în lumea fizică.

AlphaEvolve de la Google este unul dintre cele mai bune exemple de valorificare a asimetriei de verificare. Se concentrează pe configurații care se potrivesc tuturor criteriilor de mai sus și a dus la o serie de progrese în matematică și în alte domenii. Spre deosebire de ceea ce am făcut în AI în ultimele două decenii, este o nouă paradigmă în sensul că toate problemele sunt optimizate într-un cadru în care trenul este echivalent cu setul de testare.

Asimetria verificării este peste tot și este interesant să luăm în considerare o lume a inteligenței zimțate în care orice putem măsura va fi rezolvat.

298,75K

banger drept, am citit imediat

Kevin Lu10 iul., 00:01

De ce ar trebui să încetați să lucrați la cercetarea RL și să lucrați în schimb la produs //

Tehnologia care a deblocat marea schimbare de scalare în AI este internetul, nu transformatorii

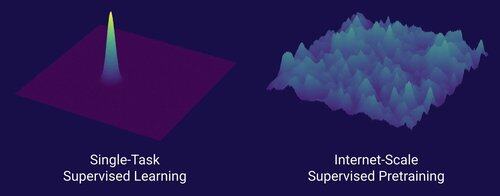

Cred că este bine cunoscut faptul că datele sunt cel mai important lucru în AI și, de asemenea, că cercetătorii aleg să nu lucreze oricum la ele. ... Ce înseamnă să lucrezi pe date (într-un mod scalabil)?

Internetul a oferit o sursă bogată de date abundente, care a fost diversă, a oferit un curriculum natural, a reprezentat competențele de care oamenii sunt cu adevărat interesați și a fost o tehnologie viabilă din punct de vedere economic pentru a fi implementată la scară largă.

Fără transformatoare, orice număr de abordări ar fi putut decola, probabil că am putea avea CNN-uri sau modele spațiale de stare la nivelul GPT-4.5. Dar nu a existat o îmbunătățire dramatică a modelelor de bază de la GPT-4. Modelele de raționament sunt grozave în domenii înguste, dar nu la fel de mari ca GPT-4 în martie 2023 (acum peste 2 ani...)

Avem ceva grozav cu învățarea prin întărire, dar teama mea profundă este că vom repeta greșelile din trecut (RL din era 2015-2020) și vom face cercetări RL care nu contează.

În modul în care internetul a fost dualul pre-antrenamentului supravegheat, care va fi dualul RL care va duce la un progres masiv precum GPT-1 -> GPT-4? Cred că arată ca un co-design cercetare-produs.

18,61K

Sfaturi pentru întâlniri cu oameni normali: Nu vă căsătoriți devreme dacă creșteți și vă schimbați mult în fiecare an

Prieten AI (@YiTayML): Ești ca o rețea neuronală în mijlocul antrenamentului și pierderea încă se îmbunătățește. Mai bine să te antrenezi pentru convergență în loc să faci un instantaneu timpuriu al punctului de control

185,8K

Nu avem încă o auto-îmbunătățire a inteligenței artificiale, iar atunci când o vom face, va schimba jocul. Cu mai multă înțelepciune acum în comparație cu zilele GPT-4, este evident că nu va fi o "decolare rapidă", ci mai degrabă extrem de treptată de-a lungul multor ani, probabil un deceniu.

Primul lucru pe care trebuie să-l știți este că auto-îmbunătățirea, adică modelele care se antrenează singure, nu este binară. Luați în considerare scenariul de antrenament GPT-5 GPT-6, care ar fi incredibil. Ar trece GPT-5 brusc de la a nu putea antrena deloc GPT-6 la a-l antrena extrem de competent? Cu siguranță nu. Primele curse de antrenament GPT-6 ar fi probabil extrem de ineficiente în timp și calcul în comparație cu cercetătorii umani. Și numai după multe încercări, GPT-5 ar fi capabil să antreneze GPT-6 mai bine decât oamenii.

În al doilea rând, chiar dacă un model s-ar putea antrena singur, nu s-ar îmbunătăți brusc în toate domeniile. Există un gradient de dificultate în cât de greu este să te perfecționezi în diferite domenii. De exemplu, poate că auto-perfecționarea funcționează la început doar pe domenii pe care știm deja cum să le remediem cu ușurință în post-antrenament, cum ar fi halucinațiile de bază sau stilul. Urmează matematica și codificarea, care necesită mai multă muncă, dar au stabilit metode de îmbunătățire a modelelor. Și apoi, la extrem, vă puteți imagina că există unele sarcini care sunt foarte greu de auto-îmbunătățit. De exemplu, capacitatea de a vorbi tlingit, o limbă nativă americană vorbită de ~500 de persoane. Va fi foarte greu pentru model să se îmbunătățească în vorbirea tlingitului, deoarece nu avem încă modalități de a rezolva limbaje cu resurse reduse ca aceasta, cu excepția colectării mai multor date, ceea ce ar necesita timp. Deci, din cauza gradientului de dificultate de auto-îmbunătățire, nu se va întâmpla totul dintr-o dată.

În cele din urmă, poate că acest lucru este controversat, dar în cele din urmă progresul în știință este blocat de experimentele din lumea reală. Unii ar putea crede că citirea tuturor lucrărilor de biologie ne-ar spune leacul pentru cancer sau că citirea tuturor lucrărilor ML și stăpânirea întregii matematici ți-ar permite să antrenezi perfect GPT-10. Dacă acesta ar fi cazul, atunci oamenii care citesc cele mai multe lucrări și studiază cea mai mare teorie ar fi cei mai buni cercetători AI. Dar ceea ce s-a întâmplat cu adevărat este că AI (și multe alte domenii) a devenit dominată de cercetători empirici nemiloși, ceea ce reflectă cât de mult progres se bazează pe experimente din lumea reală, mai degrabă decât pe inteligență brută. Deci, ideea mea este că, deși un agent super inteligent ar putea proiecta experimente de 2 sau chiar 5 ori mai bune decât cei mai buni cercetători umani, la sfârșitul zilei trebuie să aștepte ca experimentele să ruleze, ceea ce ar fi o accelerare, dar nu o decolare rapidă.

Pe scurt, există multe blocaje pentru progres, nu doar inteligența brută sau un sistem de auto-îmbunătățire. AI va rezolva multe domenii, dar fiecare domeniu are propria rată de progres. Și chiar și cea mai înaltă inteligență va necesita în continuare experimente în lumea reală. Deci va fi o accelerare și nu o decolare rapidă, vă mulțumesc că ați citit discursul meu

339,85K

Aș spune că suntem, fără îndoială, la AGI, când AI poate crea un unicorn real, viu. Și nu, nu mă refer la o companie de 1 miliard de dolari, voi tocilarii, mă refer la un cal roz cu un corn spiralat. Un model de progres științific în inginerie genetică și programare celulară. Materia viselor din copilărie. Îndrăznesc să spun că se va întâmpla în timpul vieții noastre

84,27K

Limită superioară

Clasament

Favorite

La modă pe lanț

La modă pe X

Principalele finanțări recente

Cele mai importante