Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jason Wei

Дослідник штучного інтелекту @openai

Користувач Jason Wei поділився

📣 Раді поділитися нашим реальним дослідженням клінічного другого пілота LLM, спільної роботи між @OpenAI та @PendaHealth.

Серед 39 849 візитів пацієнтів у реальному часі клініцисти зі штучним інтелектом мали відносне зниження діагностичних помилок на 16% і зменшення кількості помилок у лікуванні на 13% порівняно з тими, хто їх не мав. 🧵

197,77K

Користувач Jason Wei поділився

Це моя лекція 2 місяці тому в @Cornell

"Як збільшити продуктивність?" Одна з природних відповідей: «Я просто попрацюю ще кілька годин». Працювати довше може допомогло, але врешті-решт ви досягнете фізичної межі.

Краще запитати: «Як я можу збільшити обсяги виробництва, не збільшуючи вхідні дані так сильно?» Це і є важіль впливу.

Ми чуємо слово «важіль» так часто, що його значення легко не помітити. Моя особиста улюблена класифікація важелів – це Навал Равікант: людська праця, капітал і код / медіа. Кожен з них дав поштовх основним хвилям створення багатства в історії.

Однак, як тільки джерело кредитного плеча стає популярним (згадайте канали YouTube сьогодні в порівнянні з десятирічною давністю), конкуренція стискає маржу. Тому, коли з'являється нове кредитне плече, це рідкісний шанс отримати непомірний прибуток.

У цій доповіді я описую штучний інтелект як новий важіль. Агент зі штучним інтелектом поєднує важіль праці (він працює на вас і є інклюзивним) з важелем коду (ви можете копіювати та вставляти його).

Це банальне твердження, що штучний інтелект створить величезне багатство. Але використання цього важеля дає нам змогу послідовно інтерпретувати галасливий цикл новин про штучний інтелект і виявляти реальні можливості.

Дякую @unsojo за те, що прийняли мене!

402,4K

Новий допис у блозі про асиметрію верифікації та "закон верифікатора":

Асиметрія верифікації – ідея про те, що деякі завдання набагато легше перевірити, ніж вирішити – стає важливою ідеєю, оскільки ми маємо РЛ, який нарешті працює в цілому.

Чудовими прикладами асиметрії верифікації є такі речі, як головоломки судоку, написання коду для веб-сайту на кшталт instagram та проблеми BrowseComp (потрібно ~100 веб-сайтів, щоб знайти відповідь, але легко перевірити, як тільки ви отримаєте відповідь).

Інші завдання мають майже симетрію верифікації, наприклад, підсумовування двох 900-значних чисел або деякі сценарії обробки даних. Проте для інших завдань набагато простіше запропонувати можливі рішення, ніж перевірити їх (наприклад, перевірка фактів у довгому есе або заява про нову дієту на кшталт «їжте лише зубра»).

Важливо розуміти про асиметрію верифікації те, що ви можете покращити асиметрію, попередньо виконавши певну роботу. Наприклад, якщо у вас є ключ відповіді на математичну задачу або якщо у вас є тест-кейси для задачі Leetcode. Це значно збільшує набір проблем з бажаною асиметрією верифікації.

«Закон верифікатора» стверджує, що легкість навчання ШІ для вирішення завдання пропорційна тому, наскільки це завдання піддається перевірці. Всі завдання, які можливо вирішити і легко перевірити, будуть вирішені за допомогою штучного інтелекту. Можливість навчити ШІ вирішувати завдання пропорційно тому, чи має завдання такі властивості:

1. Об'єктивна істина: всі згодні з тим, що таке хороші рішення

2. Швидка перевірка: будь-яке рішення можна перевірити за кілька секунд

3. Масштабується для верифікації: багато рішень можна перевірити одночасно

4. Низький рівень шуму: верифікація максимально тісно корелює з якістю рішення

5. Безперервна винагорода: легко оцінити ефективність багатьох рішень для однієї проблеми

Одним з очевидних проявів закону верифікатора є той факт, що більшість контрольних показників, запропонованих в ШІ, легко перевірити і поки що вирішені. Зверніть увагу, що практично всі популярні бенчмарки за останні десять років підходять під критерії #1-4; Бенчмарки, які не відповідають критеріям #1-4, будуть боротися за те, щоб стати популярними.

Чому верифікованість така важлива? Обсяг навчання в ШІ, що відбувається, максимізується, коли задовольняються вищезазначені критерії; Ви можете зробити багато градієнтних кроків, де кожен крок має багато сигналу. Швидкість ітерацій має вирішальне значення — це причина того, що прогрес у цифровому світі був набагато швидшим, ніж прогрес у фізичному світі.

AlphaEvolve від Google є одним із найкращих прикладів використання асиметрії верифікації. Він зосереджений на установках, які відповідають усім вищезазначеним критеріям, і призвів до низки досягнень у математиці та інших галузях. На відміну від того, що ми робили в штучному інтелекті протягом останніх двох десятиліть, це нова парадигма, яка полягає в тому, що всі проблеми оптимізуються в умовах, коли набір поїздів еквівалентний тестовому набору.

Асиметрія верифікації є скрізь, і це захоплююче розглядати світ зубчастого інтелекту, де все, що ми можемо виміряти, буде вирішено.

298,73K

Прямий бенгер, я відразу прочитав

Kevin Lu10 лип., 00:01

Чому варто перестати працювати над дослідженнями RL і замість цього працювати над продуктом //

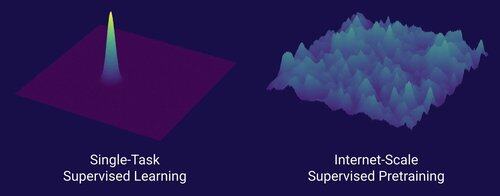

Технологія, яка відкрила великий зсув у масштабуванні штучного інтелекту, – це інтернет, а не трансформери

Я думаю, добре відомо, що дані є найважливішою річчю в штучному інтелекті, а також що дослідники все одно вирішують не працювати над ними. ... Що означає працювати з даними (масштабованим способом)?

Інтернет надавав багате джерело багатих даних, які були різноманітними, надавали природну навчальну програму, представляли компетенції, про які люди насправді дбають, і були економічно вигідною технологією для масштабного розгортання – він став ідеальним доповненням до прогнозування наступних токенів і був первісним бульйоном для зльоту штучного інтелекту.

Без трансформаторів могла б злетіти будь-яка кількість підходів, ми, напевно, могли б мати CNN або державні космічні моделі на рівні GPT-4.5. Але кардинального покращення базових моделей не відбулося з часів GPT-4. Моделі міркувань чудові у вузьких сферах, але не такий великий стрибок, як GPT-4 був у березні 2023 року (понад 2 роки тому...)

У нас є щось чудове з навчанням з підкріпленням, але мій глибокий страх полягає в тому, що ми повторимо помилки минулого (епоха 2015-2020 років RL) і проведемо дослідження RL, які не мають значення.

Подібно до того, як Інтернет був дуалом контрольованої попередньої підготовки, що буде дуалом RL, що призведе до масового прогресу, як GPT-1 -> GPT-4? Я думаю, що це виглядає як спільне проектування досліджень і продукту.

18,59K

У нас ще немає самовдосконалення штучного інтелекту, і коли ми це зробимо, це змінить правила гри. З більшою мудрістю зараз у порівнянні з днями GPT-4 очевидно, що це буде не «швидкий зліт», а скоріше надзвичайно поступовий протягом багатьох років, можливо, десятиліття.

Перше, що потрібно знати, це те, що самовдосконалення, тобто навчання моделей, не є бінарним. Розглянемо сценарій тренування GPT-5 GPT-6, який був би неймовірним. Чи зможе GPT-5 раптом перетворитися з неможливості тренувати GPT-6 на його надзвичайно вміле навчання? Однозначно ні. Перші тренувальні запуски GPT-6, ймовірно, будуть вкрай неефективними за часом та обчисленнями порівняно з дослідженнями на людях. І лише після багатьох випробувань GPT-5 дійсно зможе тренувати GPT-6 краще, ніж люди.

По-друге, навіть якби модель могла тренуватися сама, вона не стала б раптом кращою у всіх сферах. Існує градієнт складності в тому, наскільки важко вдосконалюватися в різних сферах. Наприклад, можливо, самовдосконалення спочатку працює лише на тих доменах, які ми вже знаємо, як легко виправити після тренування, наприклад, базові галюцинації або стиль. Далі будуть математика та кодування, які вимагають більше роботи, але мають встановлені методи вдосконалення моделей. А потім в крайньому випадку можна уявити, що є якісь завдання, які дуже важкі для самовдосконалення. Наприклад, здатність говорити тлінгітом, індіанською мовою, якою розмовляють ~500 осіб. Моделі буде дуже важко самовдосконалюватися в розмовній мові тлінгіт, оскільки у нас поки що немає способів вирішення таких мов з низьким рівнем ресурсів, крім збору більшої кількості даних, що займе час. Так що через градієнт труднощів самовдосконалення не все буде відбуватися відразу.

Нарешті, можливо, це суперечливо, але в кінцевому підсумку прогрес у науці обмежується реальними експериментами. Дехто може вважати, що читання всіх робіт з біології розповість нам ліки від раку, або що читання всіх робіт з ML та освоєння всієї математики дозволить вам ідеально тренувати GPT-10. Якби це було так, то люди, які прочитали найбільше статей і вивчили найбільше теорії, були б найкращими дослідниками штучного інтелекту. Але насправді сталося те, що в ШІ (і в багатьох інших галузях) стали домінувати безжально емпіричні дослідники, що відображає, наскільки прогрес ґрунтується на реальних експериментах, а не на сирому інтелекті. Отже, моя думка полягає в тому, що, хоча суперрозумний агент може розробити в 2 або навіть 5 разів кращі експерименти, ніж наші найкращі дослідники на людях, в кінці дня їм все одно доведеться чекати, поки почнуться експерименти, що буде прискоренням, але не швидким зльотом.

Підсумовуючи, можна сказати, що існує багато вузьких місць для прогресу, а не лише сирий інтелект чи система самовдосконалення. Штучний інтелект вирішить багато сфер, але кожен домен має свій темп прогресу. І навіть найвищий інтелект все одно вимагатиме експериментів у реальному світі. Так що це буде прискорення, а не швидкий зліт, дякую, що прочитали мою розповідь

339,84K

Я б сказав, що ми, безсумнівно, перебуваємо в AGI, коли ШІ може створити справжнього, живого єдинорога. І ні, я не маю на увазі компанію вартістю 1 мільярд доларів, я маю на увазі буквально рожевого коня зі спіральним ріжком. Взірець наукового прогресу в галузі генної інженерії та програмування клітин. Матеріал дитячих мрій. Насмілюся сказати, що це станеться в нашому житті

84,26K

Найкращі

Рейтинг

Вибране

Актуальне ончейн

Популярні в X

Нещодавнє найкраще фінансування

Найбільш варте уваги