Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jason Wei

Chercheur en IA @openai

Jason Wei a reposté

📣 Nous sommes ravis de partager notre étude du monde réel sur un copilote clinique LLM, une collaboration entre @OpenAI et @PendaHealth.

Lors de 39 849 visites de patients en direct, les cliniciens utilisant l'IA ont connu une réduction relative de 16 % des erreurs de diagnostic et une réduction de 13 % des erreurs de traitement par rapport à ceux qui n'en utilisaient pas. 🧵

197,77K

Jason Wei a reposté

Voici ma conférence d'il y a 2 mois à @Cornell

"Comment puis-je augmenter ma production ?" Une réponse naturelle est "Je vais juste travailler quelques heures de plus." Travailler plus longtemps peut aider, mais finalement, vous atteignez une limite physique.

Une meilleure question est : "Comment puis-je augmenter ma production sans augmenter autant l'entrée ?" C'est ça, le levier.

Nous entendons "levier" si souvent que son implication est facile à négliger. Ma catégorisation préférée du levier est celle de Naval Ravikant : le travail humain, le capital et le code / média. Chacun a alimenté d'importantes vagues de création de richesse dans l'histoire.

Cependant, une fois qu'une source de levier devient populaire (pensez aux chaînes YouTube aujourd'hui par rapport à il y a dix ans), la concurrence comprime la marge. Donc, quand un nouveau levier apparaît, c'est une chance rare pour des gains démesurés.

Dans cette conférence, je décris l'IA comme ce levier émergent. Un agent IA mélange le levier de travail (il fait le travail pour vous et est sans permission) avec le levier de code (vous pouvez le copier-coller).

C'est un cliché de dire que l'IA créera une richesse massive. Mais utiliser ce prisme de levier nous permet d'interpréter le cycle d'actualités bruyantes sur l'IA de manière cohérente et de repérer les véritables opportunités.

Merci @unsojo de m'avoir accueilli !

402,4K

Nouveau billet de blog sur l'asymétrie de la vérification et la "loi du vérificateur" :

L'asymétrie de la vérification – l'idée que certaines tâches sont beaucoup plus faciles à vérifier qu'à résoudre – devient une idée importante alors que nous avons enfin un apprentissage par renforcement qui fonctionne généralement.

De grands exemples d'asymétrie de vérification sont des choses comme les puzzles sudoku, l'écriture du code pour un site web comme Instagram, et les problèmes BrowseComp (il faut environ 100 sites web pour trouver la réponse, mais c'est facile à vérifier une fois que vous avez la réponse).

D'autres tâches ont une quasi-symétrie de vérification, comme la somme de deux nombres de 900 chiffres ou certains scripts de traitement de données. D'autres tâches sont beaucoup plus faciles à proposer comme solutions réalisables qu'à les vérifier (par exemple, vérifier les faits d'un long essai ou énoncer un nouveau régime comme "ne manger que du bison").

Une chose importante à comprendre sur l'asymétrie de la vérification est que vous pouvez améliorer l'asymétrie en effectuant un certain travail au préalable. Par exemple, si vous avez la clé de réponse à un problème mathématique ou si vous avez des cas de test pour un problème Leetcode. Cela augmente considérablement l'ensemble des problèmes avec une asymétrie de vérification souhaitable.

La "loi du vérificateur" stipule que la facilité d'entraînement de l'IA à résoudre une tâche est proportionnelle à la vérifiabilité de la tâche. Toutes les tâches qui peuvent être résolues et faciles à vérifier seront résolues par l'IA. La capacité d'entraîner l'IA à résoudre une tâche est proportionnelle à la mesure dans laquelle la tâche possède les propriétés suivantes :

1. Vérité objective : tout le monde s'accorde à dire ce que sont de bonnes solutions

2. Rapide à vérifier : toute solution donnée peut être vérifiée en quelques secondes

3. Évolutif à vérifier : de nombreuses solutions peuvent être vérifiées simultanément

4. Faible bruit : la vérification est aussi étroitement corrélée à la qualité de la solution que possible

5. Récompense continue : il est facile de classer la qualité de nombreuses solutions pour un seul problème

Une instantiation évidente de la loi du vérificateur est le fait que la plupart des benchmarks proposés en IA sont faciles à vérifier et ont jusqu'à présent été résolus. Remarquez que pratiquement tous les benchmarks populaires au cours des dix dernières années répondent aux critères #1-4 ; les benchmarks qui ne répondent pas aux critères #1-4 auraient du mal à devenir populaires.

Pourquoi la vérifiabilité est-elle si importante ? La quantité d'apprentissage en IA qui se produit est maximisée lorsque les critères ci-dessus sont satisfaits ; vous pouvez faire beaucoup d'étapes de gradient où chaque étape a beaucoup de signal. La vitesse d'itération est critique : c'est la raison pour laquelle les progrès dans le monde numérique ont été beaucoup plus rapides que les progrès dans le monde physique.

AlphaEvolve de Google est l'un des plus grands exemples d'exploitation de l'asymétrie de la vérification. Il se concentre sur des configurations qui répondent à tous les critères ci-dessus et a conduit à un certain nombre d'avancées en mathématiques et dans d'autres domaines. Différent de ce que nous avons fait en IA au cours des deux dernières décennies, c'est un nouveau paradigme dans lequel tous les problèmes sont optimisés dans un cadre où l'ensemble d'entraînement est équivalent à l'ensemble de test.

L'asymétrie de la vérification est partout et il est excitant de considérer un monde d'intelligence déchiquetée où tout ce que nous pouvons mesurer sera résolu.

298,74K

un vrai tube, je l'ai lu immédiatement

Kevin Lu10 juil., 00:01

Pourquoi vous devriez arrêter de travailler sur la recherche en RL et plutôt travailler sur des produits //

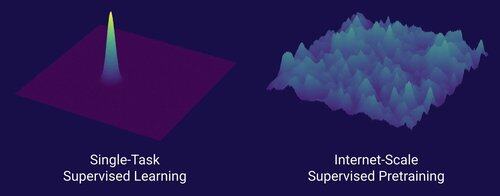

La technologie qui a débloqué le grand changement d'échelle dans l'IA est Internet, pas les transformateurs.

Je pense qu'il est bien connu que les données sont la chose la plus importante dans l'IA, et aussi que les chercheurs choisissent de ne pas y travailler de toute façon. ... Que signifie travailler sur les données (de manière évolutive) ?

Internet a fourni une source riche de données abondantes, diversifiées, offrant un curriculum naturel, représentant les compétences qui intéressent réellement les gens, et était une technologie économiquement viable à déployer à grande échelle -- cela est devenu le complément parfait à la prédiction du prochain jeton et était la soupe primordiale pour que l'IA décolle.

Sans transformateurs, n'importe quel nombre d'approches aurait pu décoller, nous pourrions probablement avoir des CNN ou des modèles d'espace d'état au niveau de GPT-4.5. Mais il n'y a pas eu d'amélioration dramatique des modèles de base depuis GPT-4. Les modèles de raisonnement sont excellents dans des domaines étroits, mais pas aussi révolutionnaires que ne l'était GPT-4 en mars 2023 (il y a plus de 2 ans...)

Nous avons quelque chose de formidable avec l'apprentissage par renforcement, mais ma peur profonde est que nous répéterons les erreurs du passé (l'ère RL de 2015-2020) et que nous fassions de la recherche en RL qui n'a pas d'importance.

De la même manière qu'Internet était le dual du pré-entraînement supervisé, quel sera le dual de RL qui mènera à une avancée massive comme GPT-1 -> GPT-4 ? Je pense que cela ressemble à une co-conception recherche-produit.

18,6K

Conseils de rencontre pour les gens normaux : Ne vous mariez pas trop tôt si vous évoluez et changez beaucoup chaque année.

Ami IA (@YiTayML) : Vous êtes comme un réseau de neurones en plein entraînement et la perte s'améliore encore. Mieux vaut entraîner jusqu'à convergence plutôt que de prendre un instantané de point de contrôle précoce.

185,79K

Nous n'avons pas encore d'IA qui s'améliore elle-même, et quand nous en aurons une, ce sera un changement radical. Avec plus de sagesse maintenant par rapport aux jours de GPT-4, il est évident que cela ne sera pas un "décollage rapide", mais plutôt extrêmement graduel sur de nombreuses années, probablement une décennie.

La première chose à savoir est que l'auto-amélioration, c'est-à-dire les modèles qui s'entraînent eux-mêmes, n'est pas binaire. Considérons le scénario où GPT-5 entraîne GPT-6, ce qui serait incroyable. GPT-5 passerait-il soudainement de l'incapacité totale à entraîner GPT-6 à l'entraîner de manière extrêmement compétente ? Définitivement pas. Les premières sessions d'entraînement de GPT-6 seraient probablement extrêmement inefficaces en termes de temps et de calcul par rapport aux chercheurs humains. Et ce n'est qu'après de nombreux essais que GPT-5 serait réellement capable d'entraîner GPT-6 mieux que les humains.

Deuxièmement, même si un modèle pouvait s'entraîner lui-même, il ne s'améliorerait pas soudainement dans tous les domaines. Il existe un gradient de difficulté quant à la façon dont il est difficile de s'améliorer dans divers domaines. Par exemple, peut-être que l'auto-amélioration ne fonctionne d'abord que dans des domaines que nous savons déjà comment corriger facilement après l'entraînement, comme les hallucinations de base ou le style. Ensuite, il y aurait les mathématiques et la programmation, qui nécessitent plus de travail mais ont des méthodes établies pour améliorer les modèles. Et puis, à l'extrême, vous pouvez imaginer qu'il y a certaines tâches qui sont très difficiles pour l'auto-amélioration. Par exemple, la capacité de parler le Tlingit, une langue amérindienne parlée par environ 500 personnes. Il sera très difficile pour le modèle de s'améliorer en parlant le Tlingit car nous n'avons pas encore de moyens de résoudre les langues à faibles ressources comme celle-ci, sauf en collectant plus de données, ce qui prendrait du temps. Donc, en raison du gradient de difficulté de l'auto-amélioration, cela ne se produira pas tout d'un coup.

Enfin, peut-être que c'est controversé, mais en fin de compte, le progrès en science est freiné par des expériences dans le monde réel. Certains peuvent croire que lire tous les articles de biologie nous donnerait le remède contre le cancer, ou que lire tous les articles sur l'apprentissage automatique et maîtriser toute la mathématique vous permettrait d'entraîner parfaitement GPT-10. Si tel était le cas, alors les personnes qui liraient le plus d'articles et étudieraient le plus de théories seraient les meilleurs chercheurs en IA. Mais ce qui s'est réellement passé, c'est que l'IA (et de nombreux autres domaines) est devenue dominée par des chercheurs empiriques impitoyables, ce qui reflète à quel point le progrès est basé sur des expériences dans le monde réel plutôt que sur une intelligence brute. Donc, mon point est que, bien qu'un agent super intelligent puisse concevoir des expériences 2x ou même 5x meilleures que nos meilleurs chercheurs humains, à la fin de la journée, ils doivent toujours attendre que les expériences se déroulent, ce qui serait une accélération mais pas un décollage rapide.

En résumé, il existe de nombreux goulets d'étranglement pour le progrès, pas seulement l'intelligence brute ou un système d'auto-amélioration. L'IA résoudra de nombreux domaines, mais chaque domaine a son propre rythme de progrès. Et même la plus haute intelligence nécessitera toujours des expériences dans le monde réel. Donc, ce sera une accélération et non un décollage rapide, merci d'avoir lu mon discours.

339,84K

La chose la plus gratifiante à propos de travailler au bureau la nuit et le week-end n'est pas le travail que vous accomplissez réellement, mais les conversations spontanées avec d'autres personnes qui travaillent toujours. Ce sont les personnes qui ont tendance à réaliser de grandes choses et qui deviendront vos amis les plus prospères.

74,47K

Je dirais que nous sommes sans aucun doute à l'AGI lorsque l'IA pourra créer une véritable licorne vivante. Et non, je ne parle pas d'une entreprise à 1 milliard de dollars, vous les nerds, je parle d'un véritable cheval rose avec une corne en spirale. Un modèle d'avancement scientifique en ingénierie génétique et en programmation cellulaire. La matière des rêves d'enfance. Oserais-je dire que cela se produira de notre vivant.

84,26K

Meilleurs

Classement

Favoris

Tendance on-chain

Tendance sur X

Récents financements de premier plan

Les plus notables