Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jason Wei

Investigador de IA @openai

Jason Wei republicó

📣 Emocionado de compartir nuestro estudio en el mundo real de un copiloto clínico LLM, una colaboración entre @OpenAI y @PendaHealth.

A través de 39,849 visitas de pacientes en vivo, los clínicos con IA tuvieron una reducción relativa del 16% en errores de diagnóstico y una reducción del 13% en errores de tratamiento en comparación con aquellos sin IA. 🧵

258,13K

Jason Wei republicó

Esta es mi conferencia de hace 2 meses en @Cornell

"¿Cómo puedo aumentar mi producción?" Una respuesta natural es "Solo trabajaré unas horas más." Trabajar más puede ayudar, pero eventualmente alcanzas un límite físico.

Una mejor pregunta es: "¿Cómo puedo aumentar mi producción sin aumentar tanto la entrada?" Eso es apalancamiento.

Escuchamos "apalancamiento" tan a menudo que su implicación es fácil de pasar por alto. Mi categorización favorita del apalancamiento es la de Naval Ravikant: trabajo humano, capital y código / medios. Cada uno ha impulsado grandes olas de creación de riqueza en la historia.

Sin embargo, una vez que una fuente de apalancamiento se vuelve popular (piensa en los canales de YouTube hoy en día en comparación con hace diez años), la competencia comprime el margen. Así que cuando aparece un nuevo apalancamiento, es una oportunidad rara para obtener ganancias desproporcionadas.

En esta charla, describo la IA como ese apalancamiento emergente. Un agente de IA combina el apalancamiento del trabajo (hace trabajo para ti y es sin permisos) con el apalancamiento del código (puedes copiar y pegar).

Es un cliché decir que la IA creará una riqueza masiva. Pero usar esta perspectiva de apalancamiento nos permite interpretar el ruidoso ciclo de noticias de IA de manera consistente y detectar las verdaderas oportunidades.

¡Gracias @unsojo por hospedarme!

402,41K

Nueva entrada de blog sobre la asimetría de la verificación y la "ley del verificador":

La asimetría de la verificación, la idea de que algunas tareas son mucho más fáciles de verificar que de resolver, se está convirtiendo en una idea importante a medida que tenemos RL que finalmente funciona de manera general.

Grandes ejemplos de asimetría de la verificación son cosas como los rompecabezas de sudoku, escribir el código para un sitio web como Instagram y los problemas de BrowseComp (se necesitan ~100 sitios web para encontrar la respuesta, pero es fácil verificar una vez que tienes la respuesta).

Otras tareas tienen una casi simetría de verificación, como sumar dos números de 900 dígitos o algunos scripts de procesamiento de datos. Sin embargo, otras tareas son mucho más fáciles de proponer soluciones viables que de verificarlas (por ejemplo, verificar un ensayo largo o declarar una nueva dieta como "solo comer bisonte").

Una cosa importante a entender sobre la asimetría de la verificación es que puedes mejorar la asimetría haciendo un trabajo previo. Por ejemplo, si tienes la clave de respuestas a un problema matemático o si tienes casos de prueba para un problema de Leetcode. Esto aumenta enormemente el conjunto de problemas con una asimetría de verificación deseable.

La "ley del verificador" establece que la facilidad de entrenar a la IA para resolver una tarea es proporcional a cuán verificable es la tarea. Todas las tareas que son posibles de resolver y fáciles de verificar serán resueltas por la IA. La capacidad de entrenar a la IA para resolver una tarea es proporcional a si la tarea tiene las siguientes propiedades:

1. Verdad objetiva: todos están de acuerdo en cuáles son las buenas soluciones

2. Rápido de verificar: cualquier solución dada puede ser verificada en unos pocos segundos

3. Escalable para verificar: muchas soluciones pueden ser verificadas simultáneamente

4. Bajo ruido: la verificación está tan correlacionada con la calidad de la solución como sea posible

5. Recompensa continua: es fácil clasificar la bondad de muchas soluciones para un solo problema

Una manifestación obvia de la ley del verificador es el hecho de que la mayoría de los benchmarks propuestos en IA son fáciles de verificar y hasta ahora han sido resueltos. Observa que prácticamente todos los benchmarks populares en los últimos diez años cumplen con los criterios #1-4; los benchmarks que no cumplen con los criterios #1-4 tendrían dificultades para hacerse populares.

¿Por qué es tan importante la verificabilidad? La cantidad de aprendizaje en IA que ocurre se maximiza cuando se satisfacen los criterios anteriores; puedes dar muchos pasos de gradiente donde cada paso tiene mucha señal. La velocidad de iteración es crítica: es la razón por la que el progreso en el mundo digital ha sido mucho más rápido que el progreso en el mundo físico.

AlphaEvolve de Google es uno de los mejores ejemplos de aprovechar la asimetría de la verificación. Se centra en configuraciones que cumplen con todos los criterios anteriores y ha llevado a una serie de avances en matemáticas y otros campos. A diferencia de lo que hemos estado haciendo en IA durante las últimas dos décadas, es un nuevo paradigma en el que todos los problemas se optimizan en un entorno donde el conjunto de entrenamiento es equivalente al conjunto de prueba.

La asimetría de la verificación está en todas partes y es emocionante considerar un mundo de inteligencia irregular donde cualquier cosa que podamos medir será resuelta.

298,79K

temazo, lo leí de inmediato

Kevin Lu10 jul, 00:01

Por qué deberías dejar de trabajar en la investigación de RL y en su lugar trabajar en productos //

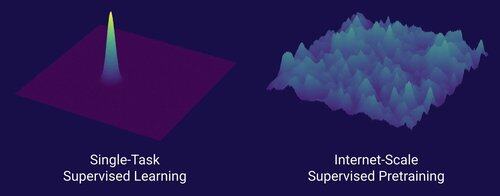

La tecnología que desbloqueó el gran cambio de escalado en IA es Internet, no transformadores.

Creo que es bien sabido que los datos son lo más importante en IA, y también que los investigadores eligen no trabajar en ello de todos modos. ... ¿Qué significa trabajar con datos (de una manera escalable)?

Internet proporcionó una rica fuente de datos abundantes, que eran diversos, ofrecían un currículo natural, representaban las competencias que a la gente realmente le importan y era una tecnología económicamente viable para desplegar a gran escala -- se convirtió en el complemento perfecto para la predicción del siguiente token y fue el caldo primordial para que la IA despegara.

Sin transformadores, cualquier número de enfoques podría haber despegado, probablemente podríamos tener CNNs o modelos de espacio de estado al nivel de GPT-4.5. Pero no ha habido una mejora dramática en los modelos base desde GPT-4. Los modelos de razonamiento son geniales en dominios específicos, pero no son un salto tan grande como lo fue GPT-4 en marzo de 2023 (hace más de 2 años...)

Tenemos algo grandioso con el aprendizaje por refuerzo, pero mi profundo temor es que repetiremos los errores del pasado (era de RL 2015-2020) y haremos investigación de RL que no importa.

De la misma manera que Internet fue el dual del preentrenamiento supervisado, ¿cuál será el dual de RL que conducirá a un avance masivo como GPT-1 -> GPT-4? Creo que se parece a la co-diseño de investigación-producto.

18,64K

Consejos de citas para personas normales: No te cases pronto si estás creciendo y cambiando mucho cada año.

Compañero de IA (@YiTayML): Eres como una red neuronal en medio de un entrenamiento y la pérdida sigue mejorando. Es mejor entrenar hasta la convergencia en lugar de tomar una instantánea de un punto de control temprano.

185,82K

Aún no tenemos IA que se auto-mejore, y cuando la tengamos, será un cambio de juego. Con más sabiduría ahora en comparación con los días de GPT-4, es obvio que no será un "despegue rápido", sino más bien extremadamente gradual a lo largo de muchos años, probablemente una década.

Lo primero que hay que saber es que la auto-mejora, es decir, modelos que se entrenan a sí mismos, no es binaria. Considera el escenario de GPT-5 entrenando a GPT-6, lo cual sería increíble. ¿Pasaría GPT-5 de no poder entrenar a GPT-6 en absoluto a entrenarlo de manera extremadamente competente? Definitivamente no. Las primeras ejecuciones de entrenamiento de GPT-6 probablemente serían extremadamente ineficientes en tiempo y recursos computacionales en comparación con los investigadores humanos. Y solo después de muchos intentos, GPT-5 realmente podría entrenar a GPT-6 mejor que los humanos.

En segundo lugar, incluso si un modelo pudiera entrenarse a sí mismo, no mejoraría repentinamente en todos los dominios. Hay un gradiente de dificultad en lo difícil que es mejorar uno mismo en varios dominios. Por ejemplo, tal vez la auto-mejora solo funcione al principio en dominios que ya sabemos cómo arreglar fácilmente en post-entrenamiento, como las alucinaciones básicas o el estilo. Luego estarían las matemáticas y la programación, que requieren más trabajo pero tienen métodos establecidos para mejorar modelos. Y luego, en el extremo, puedes imaginar que hay algunas tareas que son muy difíciles para la auto-mejora. Por ejemplo, la capacidad de hablar Tlingit, un idioma nativo americano hablado por unas ~500 personas. Será muy difícil para el modelo auto-mejorarse en hablar Tlingit ya que aún no tenemos formas de resolver idiomas de bajos recursos como este, excepto recolectando más datos, lo cual tomaría tiempo. Así que, debido al gradiente de dificultad de la auto-mejora, no todo sucederá de una vez.

Finalmente, tal vez esto sea controvertido, pero en última instancia, el progreso en la ciencia está limitado por experimentos en el mundo real. Algunos pueden creer que leer todos los artículos de biología nos diría la cura para el cáncer, o que leer todos los artículos de ML y dominar toda la matemática te permitiría entrenar a GPT-10 perfectamente. Si este fuera el caso, entonces las personas que leyeran más artículos y estudiaran más teoría serían los mejores investigadores de IA. Pero lo que realmente sucedió es que la IA (y muchos otros campos) se dominó por investigadores empíricos implacables, lo que refleja cuánto progreso se basa en experimentos del mundo real en lugar de en la inteligencia bruta. Así que mi punto es que, aunque un agente superinteligente podría diseñar experimentos 2x o incluso 5x mejores que nuestros mejores investigadores humanos, al final del día aún tendrían que esperar a que se ejecuten los experimentos, lo que sería una aceleración pero no un despegue rápido.

En resumen, hay muchos cuellos de botella para el progreso, no solo la inteligencia bruta o un sistema de auto-mejora. La IA resolverá muchos dominios, pero cada dominio tiene su propia tasa de progreso. Y incluso la inteligencia más alta aún requerirá experimentos en el mundo real. Así que será una aceleración y no un despegue rápido, gracias por leer mi desahogo.

339,87K

Lo más gratificante de trabajar en la oficina por las noches y los fines de semana no es el trabajo que realmente realizas, sino las conversaciones espontáneas con otras personas que siempre están trabajando. Son las personas que tienden a hacer grandes cosas y se convertirán en tus amigos más exitosos.

74,51K

Yo diría que sin duda estamos en la AGI cuando la IA pueda crear un unicornio real y vivo. Y no, no me refiero a una empresa de $1B, nerds, me refiero a un caballo rosa literal con un cuerno en espiral. Un paradigma del avance científico en ingeniería genética y programación celular. La materia de los sueños de la infancia. ¿Me atrevería a decir que sucederá en nuestras vidas?

84,29K

Parte superior

Clasificación

Favoritos

En tendencia on-chain

En tendencia en X

Principales fondos recientes

Más destacado