トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

dndNGMI

エージェント、スウォーム、オープンワールドゲーム

$DND AvuNqYe1Rj6eEzan78NYJ1nD3Ldt6CT8wpwGNrE2ポンプ

$CLSTR(佐賀県)0xf11a9b22ea9d241607474c924561b39a1ff0bee3

AskSimさん:「AGIの新たなトレンドは何ですか?」

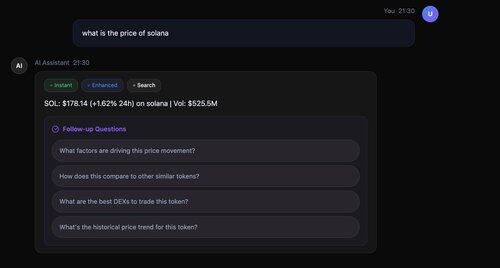

⚡ 超高速:200ミリ秒で最初の応答(他のもののように3秒ではありません!

🔄 真の並列処理:即時、拡張、検索のすべてが同時に実行されます

📚 スマート引用:実際の情報源に裏打ちされたすべての事実[1]、[2]、[3]

🎯 インテリジェントなフォローアップ:わずか2.5秒で4つの思慮深い質問

技術スタック:合成用のLlama-3.3-70B、Serper APIによる並列検索、スマートメタデータフェッチ、すべてが最適なパフォーマンスのために調整されています。

メタラマ-3.1-8B

->

ラマ-3.3-70B

->

@serperapi + Llama-3.3-70B (合成用)

->

フォローアップの質問 - Llama-3.3-70B

@AIatMeta @Sagaxyz__ @nebiusai

875

これを私たちのアプリに追加します!👏 @flyingkittans

mechamanda.eth7月15日 02:20

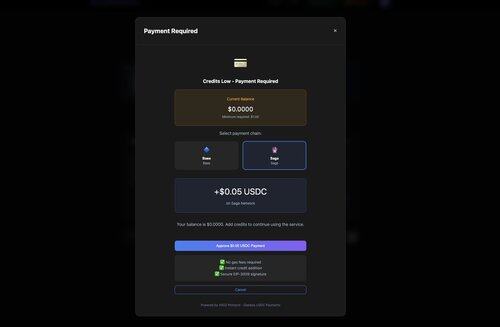

出荷されたばかり:x402 + Coinbase Onramp統合

ユーザーは次のことができるようになりました。

1.ペイウォールを打つ

2. USDCを購入する

3. コンテンツの支払いと受け取り

ページを離れることなく、一度にすべて

1.47K

AskSimは、オープンソースのLLMのオーケストレーションで、x402と@CoinbaseDev、@Sagaxyz__、@solanaのステーブルコインマイクロトランザクションを搭載

dndNGMI7月15日 21:50

AskSimさん、こんにちは。

「次のフロンティアイベントはいつまでですか?」

@paradigm

並列フェーズの実行:

- インスタント:Llama-3.1-8B(高速モデル)-すぐに開始

- 強化:Llama-3.3-70B - 並行して開始

- 検索: Serper API - 並列で開始

- Llama-3.3-70Bをサーチシンセシス@nebiusaiに使用

- 回答に引用を正常に追加しました

- 4つのフォローアップ問題を生成しました

- 合計時間:3.4秒

1.06K

AskSimは現在、@serperapiを使用してGoogleの検索結果👏を超高速で表示しています

dndNGMI7月15日 18:36

AskSimの@Xアカウントを作成する必要がありますか?

$DND $CLSTR @Sagaxyz__

483

AskSimの@Xアカウントを作成する必要がありますか?

$DND $CLSTR @Sagaxyz__

dndNGMI7月15日 13:03

AskSimとは?

- 条件付き検索によるAIファースト

- オープンソースモデルオーケストレーション(システムはLlama、Qwen、DeepSeekなどのさまざまなモデルを使用します)

- 並列プログレッシブ処理

200msで応答を開始し、徐々に強化し、必要なときだけリアルタイムデータを取得するAIアシスタント。

1.26K

AskSimとは?

- 条件付き検索によるAIファースト

- オープンソースモデルオーケストレーション(システムはLlama、Qwen、DeepSeekなどのさまざまなモデルを使用します)

- 並列プログレッシブ処理

200msで応答を開始し、徐々に強化し、必要なときだけリアルタイムデータを取得するAIアシスタント。

dndNGMI7月15日 06:33

AskSimシステムの仕組み - AIリサーチアシスタント

アーキテクチャの概要

ユーザー クエリ → プログレッシブ レスポンス オーケストレーター

├── フェーズ1:即時応答(200-300ms)

│ └──高速モデル(Llama-3.1-8B-fast)

├── フェーズ2:対応強化(並行)

│ └──パワフルモデル(Llama-3.3-70B)、DeepSeek

└── フェーズ3:検索強化(条件付き)

└── Serper/Exa API → 引用付き合成

この例では、次のようになります。

🔧 プログレッシブエンハンスメントの説明:

フェーズ 1: Llama-3.1-8B-Instruct-fast

- 80億のパラメータ

- 速度の最適化

- 応答時間:200ms

- 回答品質の80%をカバー

フェーズ 2: Llama-3.3-70B-Instruct

- 700億のパラメータ

- 8.75xより大きいモデル

- ニュアンス、例、深みを追加します

- 残りの20%を完了する

結果:100%の品質、10倍優れたUXを実現。これは、教授がバックグラウンドで詳細な講義を準備している間、すぐに答える素早いアシスタントがいるようなものです。

特別な機能

1. 電光石火のプログレッシブレスポンス

- 最初のトークンまで200ms-ユーザーは3+秒後ではなく、すぐに応答を見ることができます

- フェーズの並列実行 - 拡張と検索の同時実行

- プログレッシブエンハンスメント(インスタント→エンハンスメント→検索)

2. インテリジェントな検索統合

- 時間的制約のあるクエリの自動検出

- デュアルサーチプロバイダー(Serper + Exa)

3. コスト最適化マルチモデルシステム

- 階層ベースのモデル選択@nebiusaistudio

- 品質レベル:インスタント→エンハンスド→プレミアム

- x402を使用した@CoinbaseDev @yugacohlerおよび@Sagaxyz__ @solanaによる支払い

$CLSTR $DND

3.34K

トップ

ランキング

お気に入り

Trending onchain

Trending on X

Recent top fundings

Most notable