Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

dndNGMI

Agents, essaims et jeux en monde ouvert

$DND AvuNqYe1Rj6eEzan78NYJ1nD3Ldt6CT8wpwGNrE2pump

$CLSTR (Saga) 0xf11a9b22ea9d241607474c924561b39a1ff0bee3

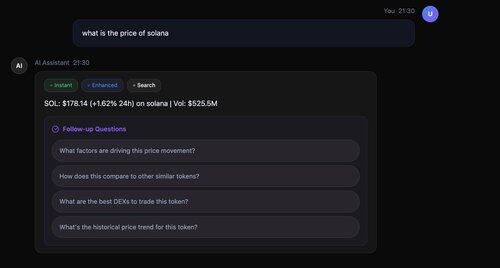

Hey AskSim : "Quelles sont les tendances émergentes en AGI ?"

⚡ Ultra Rapide : Première réponse en 200 ms (pas 3 secondes comme les autres !)

🔄 Traitement Parallèle Réel : Instantané, amélioré, et recherche effectuée simultanément

📚 Citations Intelligentes : Chaque fait soutenu par de vraies sources [1], [2], [3]

🎯 Suivis Intelligents : 4 questions réfléchies en seulement 2,5 secondes

Technologie utilisée : Llama-3.3-70B pour la synthèse, recherche parallèle avec l'API Serper, récupération intelligente de métadonnées, le tout orchestré pour une performance optimale.

Meta-Llama-3.1-8B

->

Llama-3.3-70B

->

@serperapi + Llama-3.3-70B pour la synthèse

->

questions de suivi - Llama-3.3-70B

@AIatMeta @Sagaxyz__ @nebiusai

879

Nous allons ajouter cela à notre application ! @flyingkittans 👏

mechamanda.eth15 juil., 02:20

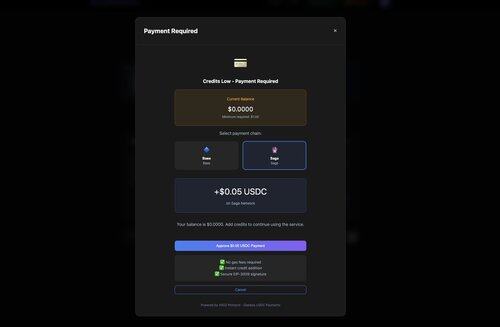

just shipped : x402 + intégration de Coinbase Onramp

les utilisateurs peuvent maintenant :

1. atteindre le mur de paiement

2. acheter des USDC

3. payer pour et recevoir leur contenu

le tout en une seule fois, sans quitter la page

1,48K

AskSim, orchestration de LLMs open-source, alimenté par x402 et des microtransactions en stablecoin sur @CoinbaseDev, @Sagaxyz__ et @solana

dndNGMI15 juil., 21:50

Salut AskSim :

"Quand est le prochain événement Frontiers par ?"

@paradigm

Exécution de phase parallèle :

- Instantanée : Llama-3.1-8B (modèle rapide) - Commencé immédiatement

- Améliorée : Llama-3.3-70B - Commencé en parallèle

- Recherche : API Serper - Commencé en parallèle

- Utilisé Llama-3.3-70B pour la synthèse de recherche @nebiusai

- Citations ajoutées avec succès à la réponse

- Généré 4 questions de suivi

- Temps total : 3,4 secondes

1,07K

Salut AskSim :

"Quand est le prochain événement Frontiers par ?"

@paradigm

Exécution de phase parallèle :

- Instantanée : Llama-3.1-8B (modèle rapide) - Commencé immédiatement

- Améliorée : Llama-3.3-70B - Commencé en parallèle

- Recherche : API Serper - Commencé en parallèle

- Utilisé Llama-3.3-70B pour la synthèse de recherche @nebiusai

- Citations ajoutées avec succès à la réponse

- Généré 4 questions de suivi

- Temps total : 3,4 secondes

1,11K

AskSim utilise désormais @serperapi pour des résultats de recherche Google ultra-rapides 👏

dndNGMI15 juil., 18:36

Devrions-nous créer un compte @X pour AskSim ?

$DND $CLSTR @Sagaxyz__

487

Devrions-nous créer un compte @X pour AskSim ?

$DND $CLSTR @Sagaxyz__

dndNGMI15 juil., 13:03

Qu'est-ce qu'AskSim ?

- D'abord axé sur l'IA avec recherche conditionnelle

- Orchestration de modèles open source (le système utilise une gamme de modèles - Llama, Qwen, DeepSeek et d'autres)

- Traitement progressif parallèle

Assistant IA qui commence à répondre en 200 ms, s'améliore progressivement et récupère des données en temps réel uniquement lorsque c'est nécessaire.

1,27K

Qu'est-ce qu'AskSim ?

- D'abord axé sur l'IA avec recherche conditionnelle

- Orchestration de modèles open source (le système utilise une gamme de modèles - Llama, Qwen, DeepSeek et d'autres)

- Traitement progressif parallèle

Assistant IA qui commence à répondre en 200 ms, s'améliore progressivement et récupère des données en temps réel uniquement lorsque c'est nécessaire.

dndNGMI15 juil., 06:33

Comment fonctionne le système AskSim - Assistant de recherche IA

Aperçu de l'architecture

Requête utilisateur → Orchestrateur de réponse progressive

├── Phase 1 : Réponse instantanée (200-300ms)

│ └── Modèles rapides (Llama-3.1-8B-rapide)

├── Phase 2 : Réponse améliorée (parallèle)

│ └── Modèles puissants (Llama-3.3-70B), DeepSeek

└── Phase 3 : Amélioration de la recherche (conditionnelle)

└── API Serper/Exa → Synthèse avec citations

Dans cet exemple particulier :

🔧 Amélioration progressive expliquée :

Phase 1 : Llama-3.1-8B-Instruct-rapide

- 8 milliards de paramètres

- Optimisé pour la vitesse

- Temps de réponse de 200ms

- Couvre 80% de la qualité de réponse

Phase 2 : Llama-3.3-70B-Instruct

- 70 milliards de paramètres

- Modèle 8,75 fois plus grand

- Ajoute de la nuance, des exemples, de la profondeur

- Complète les 20% restants

Résultat : 100% de qualité, 10x meilleure expérience utilisateur. C'est comme avoir un assistant rapide qui répond immédiatement, tandis qu'un professeur prépare une conférence détaillée en arrière-plan.

Fonctionnalités spéciales

1. Réponses progressives ultra-rapides

- 200ms jusqu'au premier token - Les utilisateurs voient les réponses instantanément, pas après 3+ secondes

- Exécution parallèle des phases - amélioration et recherche s'exécutent simultanément

- Amélioration progressive (instantanée → améliorée → recherche)

2. Intégration de recherche intelligente

- Détection automatique des requêtes sensibles au temps

- Fournisseurs de recherche doubles (Serper + Exa)

3. Système multi-modèle optimisé en coût

- sélection de modèle par niveaux @nebiusaistudio

- Niveaux de qualité : instantanée → améliorée → premium

- Paiements utilisant x402 par @CoinbaseDev @yugacohler et @Sagaxyz__ @solana

$CLSTR $DND

3,35K

Meilleurs

Classement

Favoris

Tendance on-chain

Tendance sur X

Récents financements de premier plan

Les plus notables