Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

dndNGMI

Agenti, sciami e giochi open-world

$DND AvuNqYe1Rj6eEzan78NYJ1nD3Ldt6CT8wpwGNrE2pump

$CLSTR (Saga) 0xf11a9b22ea9d241607474c924561b39a1ff0bee3

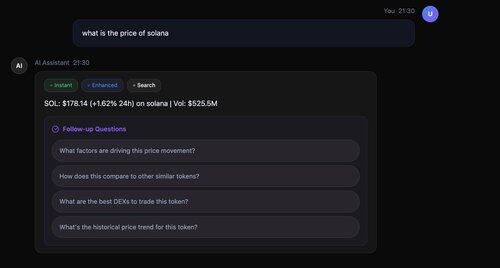

Ciao AskSim: "Quali sono le tendenze emergenti nell'AGI?"

⚡ Veloce come un lampo: Prima risposta in 200ms (non 3 secondi come gli altri!)

🔄 Vero elaborazione parallela: Istantanea, migliorata e ricerca tutto eseguito simultaneamente

📚 Citazioni intelligenti: Ogni fatto supportato da fonti reali [1], [2], [3]

🎯 Follow-up intelligenti: 4 domande ponderate in soli 2,5 secondi

Stack tecnologico: Llama-3.3-70B per sintesi, ricerca parallela con Serper API, recupero intelligente dei metadati, tutto orchestrato per prestazioni ottimali.

Meta-Llama-3.1-8B

->

Llama-3.3-70B

->

@serperapi + Llama-3.3-70B per sintesi

->

domande di follow-up - Llama-3.3-70B

@AIatMeta @Sagaxyz__ @nebiusai

874

Aggiungeremo questo alla nostra app! @flyingkittans 👏

mechamanda.eth15 lug, 02:20

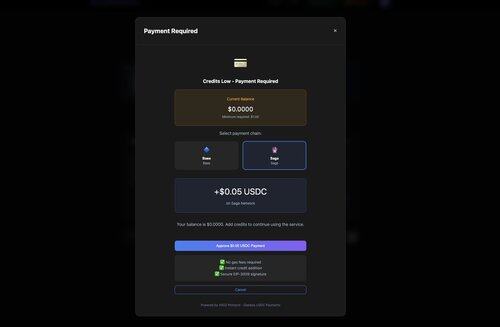

appena spedito: integrazione x402 + Coinbase Onramp

gli utenti possono ora:

1. superare il paywall

2. acquistare USDC

3. pagare e ricevere il loro contenuto

tutto in un colpo, senza lasciare la pagina

1,47K

AskSim, orchestrazione di LLM open-source, alimentata da x402 e microtransazioni in stablecoin su @CoinbaseDev, @Sagaxyz__ e @solana

dndNGMI15 lug, 21:50

Ciao AskSim:

"Quando è il prossimo evento Frontiers di ?"

@paradigm

Esecuzione della Fase Parallela:

- Istantanea: Llama-3.1-8B (modello veloce) - Iniziato immediatamente

- Migliorato: Llama-3.3-70B - Iniziato in parallelo

- Ricerca: Serper API - Iniziato in parallelo

- Utilizzato Llama-3.3-70B per la sintesi della ricerca @nebiusai

- Citazioni aggiunte con successo alla risposta

- Generate 4 domande di follow-up

- Tempo totale: 3,4 secondi

1,06K

Ciao AskSim:

"Quando è il prossimo evento Frontiers di ?"

@paradigm

Esecuzione della Fase Parallela:

- Istantanea: Llama-3.1-8B (modello veloce) - Iniziato immediatamente

- Migliorato: Llama-3.3-70B - Iniziato in parallelo

- Ricerca: Serper API - Iniziato in parallelo

- Utilizzato Llama-3.3-70B per la sintesi della ricerca @nebiusai

- Citazioni aggiunte con successo alla risposta

- Generate 4 domande di follow-up

- Tempo totale: 3,4 secondi

1,1K

AskSim ora utilizza @serperapi per risultati di ricerca Google fulminei 👏

dndNGMI15 lug, 18:36

Dovremmo creare un account @X per AskSim?

$DND $CLSTR @Sagaxyz__

482

Dovremmo creare un account @X per AskSim?

$DND $CLSTR @Sagaxyz__

dndNGMI15 lug, 13:03

Che cos'è AskSim?

- AI-first con ricerca condizionale

- Orchestrazione di modelli open source (il sistema utilizza una gamma di modelli - Llama, Qwen, DeepSeek e altri)

- Elaborazione progressiva parallela

Assistente AI che inizia a rispondere in 200 ms, migliora progressivamente e recupera dati in tempo reale solo quando necessario.

1,26K

Che cos'è AskSim?

- AI-first con ricerca condizionale

- Orchestrazione di modelli open source (il sistema utilizza una gamma di modelli - Llama, Qwen, DeepSeek e altri)

- Elaborazione progressiva parallela

Assistente AI che inizia a rispondere in 200 ms, migliora progressivamente e recupera dati in tempo reale solo quando necessario.

dndNGMI15 lug, 06:33

Come funziona il sistema AskSim - Assistente alla ricerca AI

Panoramica dell'architettura

Query dell'utente → Orchestratore di risposta progressiva

├── Fase 1: Risposta istantanea (200-300ms)

│ └── Modelli veloci (Llama-3.1-8B-fast)

├── Fase 2: Risposta migliorata (parallela)

│ └── Modelli potenti (Llama-3.3-70B), DeepSeek

└── Fase 3: Miglioramento della ricerca (condizionale)

└── Serper/Exa API → Sintesi con citazioni

In questo particolare esempio:

🔧 Spiegazione del miglioramento progressivo:

Fase 1: Llama-3.1-8B-Instruct-fast

- 8 miliardi di parametri

- Ottimizzato per la velocità

- Tempo di risposta di 200ms

- Copre l'80% della qualità della risposta

Fase 2: Llama-3.3-70B-Instruct

- 70 miliardi di parametri

- Modello 8.75 volte più grande

- Aggiunge sfumature, esempi, profondità

- Completa il restante 20%

Risultato: 100% di qualità, 10 volte migliore UX. È come avere un assistente veloce che risponde immediatamente, mentre un professore prepara una lezione dettagliata in background.

Caratteristiche speciali

1. Risposte progressive fulminee

- 200ms per il primo token - Gli utenti vedono le risposte istantaneamente, non dopo 3+ secondi

- Esecuzione parallela delle fasi - migliorata e ricerca eseguite simultaneamente

- Miglioramento progressivo (istantaneo → migliorato → ricerca)

2. Integrazione della ricerca intelligente

- Rilevamento automatico di query sensibili al tempo

- Doppio fornitore di ricerca (Serper + Exa)

3. Sistema multi-modello ottimizzato per i costi

- selezione del modello basata su livelli @nebiusaistudio

- Livelli di qualità: istantaneo → migliorato → premium

- Pagamenti utilizzando x402 da @CoinbaseDev @yugacohler e @Sagaxyz__ @solana

$CLSTR $DND

3,34K

Principali

Ranking

Preferiti

On-chain di tendenza

Di tendenza su X

Principali fondi recenti

Più popolari