Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

dndNGMI

Agenten, Schwarm- und Open-World-Spiele

$DND AvuNqYe1Rj6eEzan78NYJ1nD3Ldt6CT8wpwGNrE2pumpe

$CLSTR (Saga) 0xf11a9b22ea9d241607474c924561b39a1ff0bee3

Hey AskSim: "Was sind die aufkommenden Trends in AGI?"

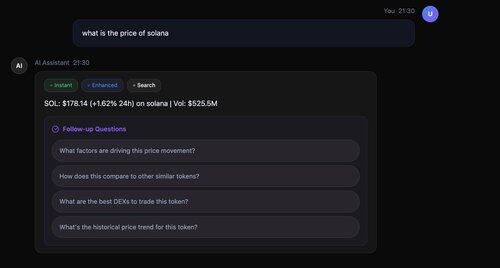

⚡ Blitzschnell: Erste Antwort in 200ms (nicht 3 Sekunden wie bei anderen!)

🔄 Wahre Parallelverarbeitung: Sofort, verbessert und alle Suchen laufen gleichzeitig

📚 Smarte Zitationen: Jede Tatsache durch echte Quellen belegt [1], [2], [3]

🎯 Intelligente Nachfragen: 4 durchdachte Fragen in nur 2,5 Sekunden

Technologiestack: Llama-3.3-70B für Synthese, parallele Suche mit Serper API, intelligentes Abrufen von Metadaten, alles orchestriert für optimale Leistung.

Meta-Llama-3.1-8B

->

Llama-3.3-70B

->

@serperapi + Llama-3.3-70B für Synthese

->

Nachfragen - Llama-3.3-70B

@AIatMeta @Sagaxyz__ @nebiusai

877

Werde das zu unserer App hinzufügen! @flyingkittans 👏

mechamanda.eth15. Juli, 02:20

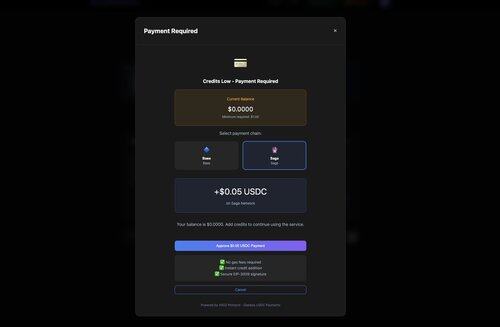

gerade versendet: x402 + Coinbase Onramp-Integration

Benutzer können jetzt:

1. die Bezahlschranke erreichen

2. USDC kaufen

3. für ihre Inhalte bezahlen & sie erhalten

alles in einem Schritt, ohne die Seite zu verlassen

1,48K

AskSim, Orchestrierung von Open-Source-LLMs, unterstützt von x402 und Stablecoin-Mikrotransaktionen auf @CoinbaseDev, @Sagaxyz__ und @solana

dndNGMI15. Juli, 21:50

Hey AskSim:

"Wann ist die nächste Frontiers-Veranstaltung von ?"

@paradigm

Parallelphasen-Ausführung:

- Sofort: Llama-3.1-8B (schnelles Modell) - Sofort gestartet

- Verbesserte: Llama-3.3-70B - Parallel gestartet

- Suche: Serper API - Parallel gestartet

- Llama-3.3-70B für die Suchsynthese verwendet @nebiusai

- Erfolgreich Zitationen zur Antwort hinzugefügt

- 4 Folgefragen generiert

- Gesamtzeit: 3,4 Sekunden

1,07K

Hey AskSim:

"Wann ist die nächste Frontiers-Veranstaltung von ?"

@paradigm

Parallelphasen-Ausführung:

- Sofort: Llama-3.1-8B (schnelles Modell) - Sofort gestartet

- Verbesserte: Llama-3.3-70B - Parallel gestartet

- Suche: Serper API - Parallel gestartet

- Llama-3.3-70B für die Suchsynthese verwendet @nebiusai

- Erfolgreich Zitationen zur Antwort hinzugefügt

- 4 Folgefragen generiert

- Gesamtzeit: 3,4 Sekunden

1,1K

AskSim verwendet jetzt @serperapi für blitzschnelle Google-Suchergebnisse 👏

dndNGMI15. Juli, 18:36

Sollten wir ein @X-Konto für AskSim erstellen?

$DND $CLSTR @Sagaxyz__

485

Sollten wir ein @X-Konto für AskSim erstellen?

$DND $CLSTR @Sagaxyz__

dndNGMI15. Juli, 13:03

Was ist AskSim?

- KI-zuerst mit bedingter Suche

- Open-Source-Modellorchestrierung (das System verwendet eine Reihe von Modellen - Llama, Qwen, DeepSeek und andere)

- Parallele progressive Verarbeitung

KI-Assistent, der in 200 ms mit dem Antworten beginnt, sich progressiv verbessert und Echtzeitdaten nur bei Bedarf abruft.

1,26K

Was ist AskSim?

- KI-zuerst mit bedingter Suche

- Open-Source-Modellorchestrierung (das System verwendet eine Reihe von Modellen - Llama, Qwen, DeepSeek und andere)

- Parallele progressive Verarbeitung

KI-Assistent, der in 200 ms mit dem Antworten beginnt, sich progressiv verbessert und Echtzeitdaten nur bei Bedarf abruft.

dndNGMI15. Juli, 06:33

Wie das AskSim-System funktioniert - KI-Forschungsassistent

Architekturübersicht

Benutzeranfrage → Progressiver Antwortorchestrator

├── Phase 1: Sofortige Antwort (200-300ms)

│ └── Schnelle Modelle (Llama-3.1-8B-fast)

├── Phase 2: Verbesserte Antwort (parallel)

│ └── Leistungsstarke Modelle (Llama-3.3-70B), DeepSeek

└── Phase 3: Suchverbesserung (bedingt)

└── Serper/Exa API → Synthese mit Zitaten

In diesem speziellen Beispiel:

🔧 Fortschrittliche Verbesserung erklärt:

Phase 1: Llama-3.1-8B-Instruct-fast

- 8 Milliarden Parameter

- Optimiert für Geschwindigkeit

- 200ms Antwortzeit

- Deckt 80% der Antwortqualität ab

Phase 2: Llama-3.3-70B-Instruct

- 70 Milliarden Parameter

- 8,75x größeres Modell

- Fügt Nuancen, Beispiele, Tiefe hinzu

- Vervollständigt die verbleibenden 20%

Ergebnis: 100% Qualität, 10x bessere UX. Es ist, als hätte man einen schnellen Assistenten, der sofort antwortet, während ein Professor im Hintergrund eine detaillierte Vorlesung vorbereitet.

Besondere Merkmale

1. Blitzschnelle progressive Antworten

- 200ms bis zum ersten Token - Benutzer sehen Antworten sofort, nicht nach 3+ Sekunden

- Parallele Ausführung der Phasen - verbesserte und Suchanfragen laufen gleichzeitig

- Progressive Verbesserung (sofort → verbessert → Suche)

2. Intelligente Suchintegration

- Automatische Erkennung zeitkritischer Anfragen

- Duale Suchanbieter (Serper + Exa)

3. Kostenoptimiertes Multi-Modell-System

- tierbasierte Modellauswahl @nebiusaistudio

- Qualitätsstufen: sofort → verbessert → premium

- Zahlungen mit x402 von @CoinbaseDev @yugacohler und @Sagaxyz__ @solana

$CLSTR $DND

3,34K

Top

Ranking

Favoriten

Onchain-Trends

Im Trend auf X

Aktuelle Top-Finanzierungen

Am bemerkenswertesten