Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

La tesi della rete dell'IA si sta realizzando:

- orchestrare più modelli

- scalabilità parallelizzata per maggiore intelligenza

- protocolli aperti come MCP

14 set 2024

OpenAI, con il lancio di o1, ha involontariamente dimostrato l'intuizione tra crypto e AI che ho scritto in questo saggio esattamente un anno fa:

Un modello come o1 ora ha un budget di token di ragionamento di 25.000 per un singolo prompt - rappresentando almeno un aumento di 20 volte in media per i budget di token per prompt.

Questo è un compito di calcolo parallelizzato, dove reti distribuite e decentralizzate possono scalare all'infinito. E - l'intelligenza percepita da un utente migliora effettivamente!

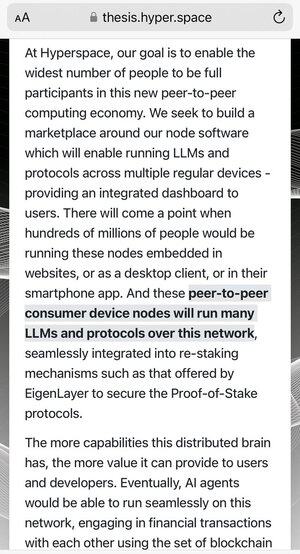

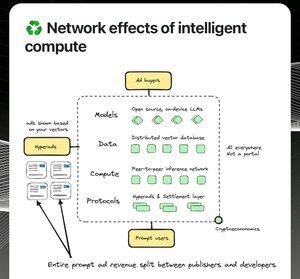

Considera se una rete come Hyperspace cresce dai 20k+ nodi di oggi a 20 milioni di nodi un giorno, sarebbe tra i primi 5 cluster AI al mondo da cui otterresti le risposte più intelligenti. E sarebbe anche più economica allo stesso tempo, poiché è una funzione dei costi locali dell'elettricità più l'economia di mercato in tempo reale. Non ci sono intermediari. Anche i micropagamenti tra agenti sarebbero gestiti attraverso un protocollo gestito da una frazione di questi nodi.

I grandi modelli pre-addestrati su piccoli cluster sono dinosauri in quel mondo. Troppo lenti, non così intelligenti, anche se piacciono a alcune persone nella comunità accademica.

Ciò che alla fine vince sono le reti più grandi. Poiché l'intelligenza è ora una funzione della scalabilità parallelizzata dell'inferenza, quasi tutta l'AI sarà distribuita. Questo è un mercato che si presenta una volta ogni 20 anni.

Le nostre priorità sono chiare: vogliamo costruire l'impresa AI distribuita più impattante e non comprometteremo quella visione. Quel lavoro quindi spazia da nuovi modelli, prodotti AI, sistemi distribuiti, reti, clienti e protocolli.

Ci scaldiamo usando il software.

cc @ylecun

1,63K

Principali

Ranking

Preferiti