Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jag tror mer och mer att kompetenstaket för LLM-assisterad teknik förmodligen är ungefär lika högt som för teknik i allmänhet. (Det är definitivt djupare än t.ex. Excel, och det finns OOM:er i Excel-kunskaper.)

23 juli 09:40

För att 10x AI-kodningsagenter måste du vara *besatt* av kontextteknik framför allt.

Bra sammanhang = bra plan = bra resultat

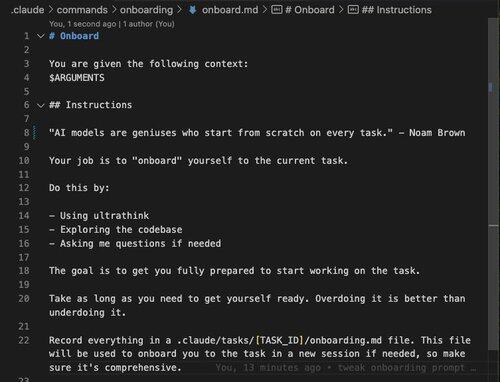

AI-modeller är genier som börjar från noll varje gång.

Så ta med dem genom att gå överbord när det gäller sammanhanget.

Använd den här prompten som utgångspunkt.

Skill cap är en gamerism. Det fångar intuitionen att det finns vissa spel där skillnaden mellan bästa spelare och sämsta spelare är marginell, tic tac toh, och andra där detta är mycket osant och man kan studera spelet för en livstid samtidigt som man ständigt förbättras (poker, go).

Detta är inte bara på nivån för mikromekanik eller snabb teknik eller kontextteknik. Det finns hela arbetssätt som lutar sig mot vad LLM gör bäst, och hur mycket tid du kan lägga på dem är inte fast över alla sessioner eller projekt.

Och så med tanke på att du har kontroll eller inflytande över helheten av systemet, har du metabeslut att fatta om "Ska jag vilja att det här systemet ska ha fler delkomponenter av det slag som LLM:er bara *veva* igenom? Eller ska jag göra andra arkitekturval eller liknande?"

Och ja, vi är flera år från att lära oss hur underhållsslingan ser ut för LLM-levererade delsystem, men de smarta pengarna är förmodligen: "En människa kan vara medveten i en allmän mening om att det händer."

Hur som helst är det här väldigt, väldigt roligt och jag befinner mig på en konstig plats där jag önskar att semestern var över så att jag kunde skriva kod gratis.

(Som en av många anpassningar till den här stilen drar den nytta av flera timmars block av oavbruten tid eftersom agenterna trivs med sammanhang och de första minuterna av en session suger. Detta är svårt att leverera från köksbordet hos svärföräldrarna.)

51,47K

Topp

Rankning

Favoriter