Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Adam Wolff

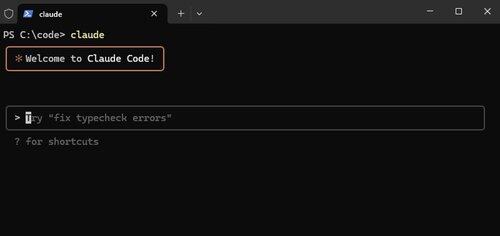

Claude Code @AnthropicAI 🤖

Cozinheiro ávido, pessoa dedicada à neve, entusiasta da ioga

Claude Code, agora nativo no Windows.

Recursos como esse não são chamativos, mas tornam Claude Code *tão* poderoso. Queremos que ele seja executado em todos os lugares que você fizer.

Alex Albert15 de jul., 03:07

Temos outra grande atualização para Claude Code hoje: agora está disponível nativamente para Windows.

13,04K

"Embora a competição pareça uma força poderosa, a colaboração é a única força mais poderosa."

❤️ @tomocchino

Ryan Vogel13 de jul., 01:50

Confira a primeira parte do nosso mais novo episódio com @tomocchino de @vercel

(obrigado novamente a vercel por nos deixar filmar no QG)

10,21K

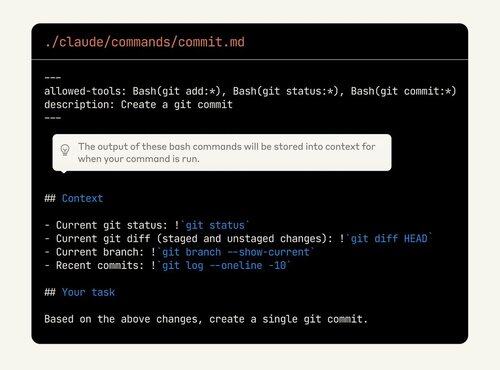

Claude Code é tão personalizável, mas os recursos são difíceis de descobrir. Muitas pessoas estão dormindo com o poder dos comandos personalizados. Agora eles podem até incorporar a saída bash!

Dê outra olhada se você ainda não estiver usando esses recursos.

Alex Albert2 de jul., 00:19

Como lembrete, os comandos de barra permitem armazenar prompts personalizados como arquivos Markdown e invocá-los com /your-command.

Com esta atualização, agora você pode:

- Execute comandos bash a partir de comandos de barra

- @ arquivos de menção para contexto

- Habilite o pensamento estendido com palavras-chave nos comandos

10K

As avaliações de hoje são como os testes eram há uma década. Obviamente importante, mas também não está claro exatamente como e quanto investir.

Este é um ótimo conselho, mas o mais importante é tentar. Se o seu produto incorpora IA e você não tem avaliações, você está construindo um castelo feito de areia.

shyamal20 de mai. de 2025

Começar a usar avaliações não requer muito. o padrão que vimos funcionar para equipes pequenas se parece muito com o desenvolvimento orientado a testes aplicado à engenharia de IA:

1/ Ancore avaliações em histórias de usuários, não em benchmarks abstratos: Sente-se com sua contraparte de produto/design e liste as coisas concretas que seu modelo precisa fazer para os usuários. "responder a perguntas de sinistros de seguro com precisão", "gerar consultas SQL a partir de linguagem natural". Para cada um, escreva de 10 a 20 entradas representativas e as saídas/comportamentos desejados. Este é o seu primeiro arquivo de avaliação.

2/ Automatize desde o primeiro dia, mesmo que seja frágil. resistir à tentação de "apenas olhar para ele". Bem, OK, o Vibes não escala por muito tempo. Envolva suas avaliações em código. Você pode escrever um pytest simples que faz um loop sobre seus exemplos, chama o modelo e afirma que determinadas subcadeias de caracteres aparecem. É bruto, mas é um começo.

3/ Use o modelo para inicializar dados de avaliação mais difíceis. escrever manualmente centenas de casos extremos é caro. Você pode usar modelos de raciocínio (O3) para gerar variações sintéticas ("Dê-me 50 perguntas de reivindicação envolvendo danos por incêndio") e, em seguida, filtrar manualmente. Isso acelera a cobertura sem sacrificar a relevância.

4/ não persiga tabelas de classificação; iterar sobre o que falha. Quando algo falhar na produção, não apenas corrija o prompt – adicione o caso de falha ao seu conjunto de avaliação. Com o tempo, sua suíte crescerá para refletir seus modos de falha reais. Periodicamente, divida suas avaliações (por comprimento de entrada, por localidade etc.) para ver se você está regredindo em segmentos específicos.

5/ Evolua suas métricas à medida que seu produto amadurece. À medida que você escala, você desejará uma pontuação mais sutil (similaridade semântica, classificações humanas, rastreamento de custo/latência). Construa ganchos em seu arnês de avaliação para registrá-los e tendê-los ao longo do tempo. instrumente sua interface do usuário para coletar feedback implícito (o usuário clicou em "polegar para cima"?) e alimente-o de volta em suas avaliações offline.

6/ tornar as avaliações visíveis. Coloque um painel simples na frente da equipe e das partes interessadas mostrando as taxas de aprovação de avaliação, custo e latência. use-o em stand-ups. isso cria responsabilidade e ajuda as pessoas que não são de ML a participar das discussões de trade-off.

Por fim, trate as avaliações como um artefato de engenharia central. Atribua propriedade, revise-os na revisão de código, comemore quando você adicionar um novo caso complicado. A disciplina pagará dividendos compostos à medida que você escala.

1,16K

Melhores

Classificação

Favoritos

Em alta on-chain

Em alta no X

Principais fundos da atualidade

Mais notável