Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Adam Wolff

Claude Code @AnthropicAI 🤖

Cuisinier passionné, homme de neige dévoué, passionné de yoga

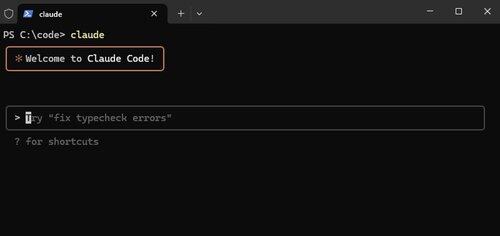

Claude Code, maintenant natif sur Windows.

Des fonctionnalités comme celle-ci ne sont pas tape-à-l'œil, mais elles rendent Claude Code *tellement* puissant. Nous voulons qu'il fonctionne partout où vous êtes.

Alex Albert15 juil., 03:07

Nous avons une autre grande mise à jour pour Claude Code aujourd'hui : il est désormais disponible nativement pour Windows.

13,02K

"Bien que la concurrence semble être une force puissante, la collaboration est la seule force plus puissante."

@tomocchino ❤️

Ryan Vogel13 juil., 01:50

check out part one of our newest episode with @tomocchino from @vercel

(thanks again to vercel for letting us film at HQ)

10,19K

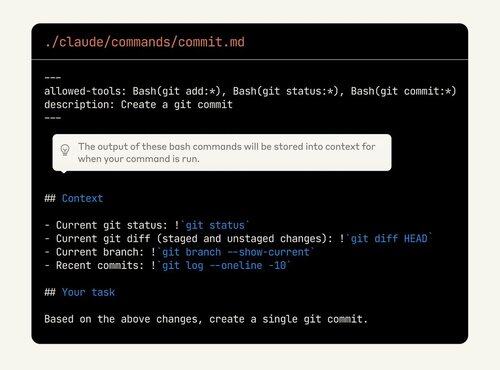

Claude Code est tellement personnalisable, mais les fonctionnalités sont difficiles à découvrir. Beaucoup de gens sous-estiment le pouvoir des commandes personnalisées. Maintenant, ils peuvent même intégrer la sortie bash !

Jetez un autre coup d'œil si vous n'utilisez pas déjà ces fonctionnalités.

Alex Albert2 juil., 00:19

Pour rappel, les commandes slash vous permettent de stocker des invites personnalisées sous forme de fichiers Markdown et de les invoquer avec /votre-commande.

Avec cette mise à jour, vous pouvez désormais :

- Exécuter des commandes bash à partir des commandes slash

- Mentionner des fichiers pour le contexte

- Activer une réflexion étendue avec des mots-clés dans les commandes

9,98K

Les évaluations d’aujourd’hui sont comme les tests d’il y a dix ans. C’est évidemment important, mais on ne sait pas non plus exactement comment et combien investir.

C’est un excellent conseil, mais le plus important est d’essayer. Si votre produit intègre l’IA et que vous n’avez pas d’évaluations, vous construisez un château de sable.

shyamal20 mai 2025

Débuter avec les Eval ne nécessite pas trop de choses. le modèle que nous avons vu fonctionner pour de petites équipes ressemble beaucoup au développement piloté par les tests appliqué à l’ingénierie de l’IA :

1/ Ancrez les Eval dans les user stories, pas dans des benchmarks abstraits : asseyez-vous avec votre homologue produit/design et listez les choses concrètes que votre modèle doit faire pour les utilisateurs. « répondre avec précision aux questions sur les réclamations d’assurance », « générer des requêtes SQL à partir du langage naturel ». Pour chacune, écrivez 10 à 20 entrées représentatives et les sorties/comportements souhaités. Il s’agit de votre premier fichier EAL.

2/ Automatisez dès le premier jour, même si c’est cassant. Résistez à la tentation de « simplement le regarder ». Bon, ok, les vibrations ne durent pas trop longtemps. Encapsulez vos évaluations dans du code. Vous pouvez écrire un pytest simple qui boucle sur vos exemples, appelle le modèle et affirme que certaines sous-chaînes apparaissent. C’est grossier, mais c’est un début.

3/ Utilisez le modèle pour amorcer des données d’évaluation plus difficiles. L’écriture manuelle de centaines de cas limites est coûteuse. Vous pouvez utiliser des modèles de raisonnement (O3) pour générer des variations synthétiques (« Donnez-moi 50 questions de réclamation impliquant des dommages causés par le feu »), puis filtrer à la main. Cela accélère la couverture sans sacrifier la pertinence.

4/ Ne courez pas après les classements ; Itérez sur ce qui échoue. Lorsqu’un problème échoue en production, ne vous contentez pas de corriger l’invite, ajoutez le cas d’échec à votre ensemble d’évaluations. Au fil du temps, votre suite s’agrandira pour refléter vos modes de défaillance réels. Divisez périodiquement vos évaluations (par longueur d’entrée, par paramètres régionaux, etc.) pour voir si vous régressez sur des segments particuliers.

5/ Faites évoluer vos métriques au fur et à mesure que votre produit mûrit. Au fur et à mesure que vous évoluez, vous aurez besoin d’un scoring plus nuancé (similarité sémantique, évaluations humaines, suivi des coûts/latences). Construisez des crochets dans votre harnais Eval pour les enregistrer et les suivre au fil du temps. instrumentez votre interface utilisateur pour collecter des commentaires implicites (l’utilisateur a-t-il cliqué sur « pouce levé » ?) et réinjectez-les dans vos évaluations hors ligne.

6/ Rendez les évaluations visibles. Mettez un tableau de bord simple devant l’équipe et les parties prenantes indiquant les taux de réussite à l’évaluation, le coût et la latence. Utilisez-le en stand-ups. cela crée une responsabilisation et aide les personnes qui ne sont pas du ML à participer aux discussions sur les compromis.

Enfin, traitez les EVALS comme un artefact d’ingénierie de base. Attribuez la propriété, examinez-les dans la revue de code, célébrez lorsque vous ajoutez un nouveau cas délicat. La discipline vous rapportera des dividendes composés au fur et à mesure que vous évoluez.

1,14K

Meilleurs

Classement

Favoris

Tendance on-chain

Tendance sur X

Récents financements de premier plan

Les plus notables