Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Adam Wolff

Claude Code @AnthropicAI 🤖

Fervent kok, toegewijd sneeuwmens, yogaliefhebber

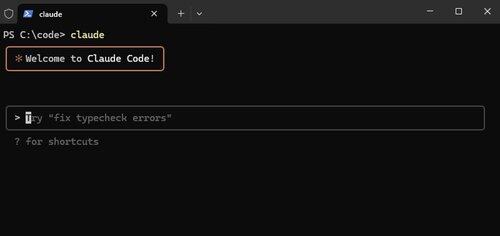

Claude Code, nu native op Windows.

Functies zoals deze zijn niet opzichtig, maar ze maken Claude Code *zo* krachtig. We willen dat het overal draait waar jij dat doet.

Alex Albert15 jul, 03:07

We hebben vandaag een grote update voor Claude Code: het is nu native beschikbaar voor Windows.

13,03K

"Hoewel concurrentie aanvoelt als een krachtige kracht, is samenwerking de enige kracht die krachtiger is."

@tomocchino ❤️

Ryan Vogel13 jul, 01:50

check out part one of our newest episode with @tomocchino from @vercel

(thanks again to vercel for letting us film at HQ)

10,19K

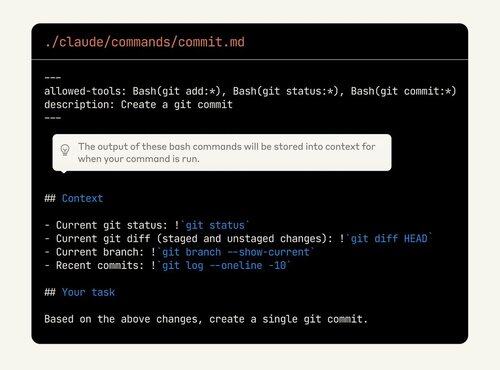

Claude Code is zo aanpasbaar, maar de functies zijn moeilijk te ontdekken. Veel mensen onderschatten de kracht van aangepaste commando's. Nu kunnen ze zelfs bash-uitvoer insluiten!

Neem nog eens een kijkje als je deze functies nog niet gebruikt.

Alex Albert2 jul, 00:19

Ter herinnering, slash-commando's stellen je in staat om aangepaste prompts op te slaan als Markdown-bestanden en ze aan te roepen met /jouw-commando.

Met deze update kun je nu:

- Bash-commando's uitvoeren vanuit slash-commando's

- @vermeld bestanden voor context

- Uitgebreid denken inschakelen met trefwoorden binnen commando's

9,99K

Evals zijn tegenwoordig net als tests tien jaar geleden. Uiteraard belangrijk, maar ook onduidelijk hoe en hoeveel je precies moet investeren.

Dit is een goed advies, maar het belangrijkste is om het te proberen. Als je product AI bevat en je hebt geen evals, dan bouw je een kasteel van zand.

shyamal20 mei 2025

Aan de slag gaan met eVal vergt niet al te veel. het patroon dat we hebben zien werken voor kleine teams lijkt veel op testgestuurde ontwikkeling toegepast op AI-engineering:

1/ Veranker evals in user stories, niet in abstracte benchmarks: ga zitten met uw product/design-tegenhanger en maak een lijst van de concrete dingen die uw model voor gebruikers moet doen. "vragen over verzekeringsclaims nauwkeurig beantwoorden", "SQL-query's genereren op basis van natuurlijke taal". Schrijf voor elk 10-20 representatieve inputs en de gewenste outputs/gedragingen. Dit is uw eerste evaluatiebestand.

2/ Automatiseer vanaf de eerste dag, zelfs als het broos is. Weersta de verleiding om "het gewoon op de korrel te nemen". Nou, oké, Vibes schaalt niet te lang. Verpak je evals in code. U kunt een eenvoudige pytest schrijven die uw voorbeelden doorloopt, het model aanroept en beweert dat bepaalde substrings verschijnen. Het is grof, maar het is een begin.

3/ Gebruik het model om hardere evaluatiegegevens op te starten. Het handmatig schrijven van honderden randgevallen is duur. U kunt redeneermodellen (O3) gebruiken om synthetische variaties te genereren ("Geef me 50 claimvragen met betrekking tot brandschade") en vervolgens met de hand filteren. Dit versnelt de dekking zonder in te boeten aan relevantie.

4/ Jaag niet op ranglijsten; Herhaal wat mislukt. Als er iets misgaat in de productie, repareer dan niet alleen de prompt - voeg het mislukte geval toe aan uw evaluatieset. In de loop van de tijd zal uw suite groeien om uw echte mislukkingsmodi weer te geven. Snijd uw eval's regelmatig op (op invoerlengte, op landinstelling, enz.) om te zien of u achteruitgaat op bepaalde segmenten.

5/ Ontwikkel uw statistieken naarmate uw product volwassener wordt. Naarmate u schaalt, wilt u meer genuanceerde scores (semantische gelijkenis, menselijke beoordelingen, kosten-/latentietracking). Bouw haken in je evaluatieharnas om deze te loggen en ze in de loop van de tijd te trenden. instrument uw gebruikersinterface om impliciete feedback te verzamelen (heeft de gebruiker op "duim omhoog" geklikt?) en voer dat terug naar uw offline evals.

6/ Maak evals zichtbaar. Zet een eenvoudig dashboard voor het team en de belanghebbenden met de evaluatieslagingspercentages, kosten en latentie. Gebruik het in stand-ups. dit creëert verantwoordelijkheid en helpt niet-ML-mensen deel te nemen aan de trade-off-discussies.

Behandel evals ten slotte als een kernartefact. Wijs eigendom toe, bekijk ze in Code Review, vier het wanneer je een nieuwe lastige case toevoegt. De discipline zal samengestelde dividenden uitkeren naarmate u opschaalt.

1,15K

Boven

Positie

Favorieten

Populair op onchain

Populair op X

Recente topfinanciering

Belangrijkste