Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Adam Wolff

Claude Code @AnthropicAI 🤖

Vášnivý kuchař, oddaný sněhový člověk, nadšenec do jógy

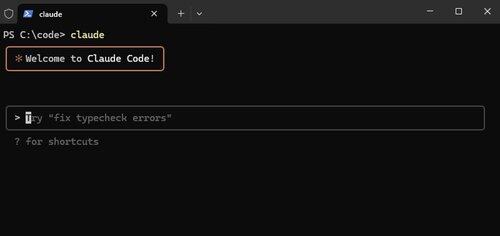

Claude Code, nyní nativní pro Windows.

Funkce, jako je tato, nejsou okázalé, ale dělají Claude Code *tak* výkonným. Chceme, aby běžela všude, kde pracujete.

Alex Albert15. 7. 03:07

Dnes máme další velkou aktualizaci pro Claude Code: je nyní nativně k dispozici pro Windows.

12,99K

"Zatímco konkurence se zdá být mocnou silou, spolupráce je jedinou mocnější silou."

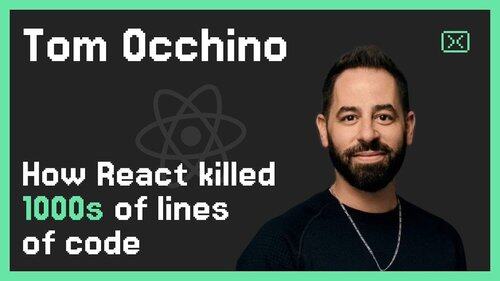

❤️ @tomocchino

Ryan Vogel13. 7. 01:50

Podívejte se na první část naší nejnovější epizody s @tomocchino od @vercel

(ještě jednou díky Vercelovi za to, že nám umožnil natáčet v ústředí)

10,15K

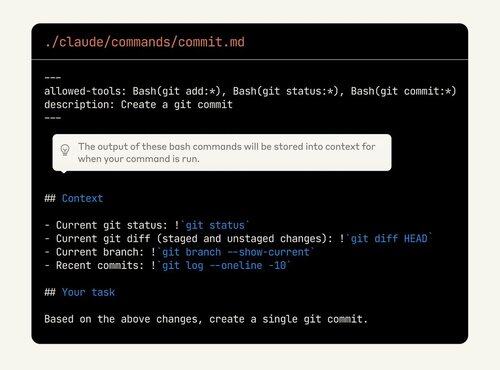

Claude Code je tak přizpůsobitelný, ale funkce je těžké objevit. Spousta lidí spí na síle vlastních příkazů. Nyní mohou dokonce vkládat výstup z bashu!

Pokud tyto funkce ještě nepoužíváte, podívejte se znovu.

Alex Albert2. 7. 00:19

As a reminder, slash commands let you store custom prompts as Markdown files and invoke them with /your-command.

With this update, you can now:

- Execute bash commands from slash commands

- @ mention files for context

- Enable extended thinking with keywords within commands

9,91K

Hodnocení jsou dnes jako testy před deseti lety. Samozřejmě důležité, ale také nejasné, jak přesně a kolik investovat.

To je skvělá rada, ale nejdůležitější je to zkusit. Pokud váš produkt obsahuje umělou inteligenci a nemáte vyhodnocení, stavíte hrad z písku.

shyamal20. 5. 2025

getting started with evals doesn't require too much. the pattern that we've seen work for small teams looks a lot like test‑driven development applied to AI engineering:

1/ anchor evals in user stories, not in abstract benchmarks: sit down with your product/design counterpart and list out the concrete things your model needs to do for users. "answer insurance claim questions accurately", "generate SQL queries from natural language". for each, write 10–20 representative inputs and the desired outputs/behaviors. this is your first eval file.

2/ automate from day one, even if it's brittle. resist the temptation to "just eyeball it". well, ok, vibes doesn't scale for too long. wrap your evals in code. you can write a simple pytest that loops over your examples, calls the model, and asserts that certain substrings appear. it's crude, but it's a start.

3/ use the model to bootstrap harder eval data. manually writing hundreds of edge cases is expensive. you can use reasoning models (o3) to generate synthetic variations ("give me 50 claim questions involving fire damage") and then hand‑filter. this speeds up coverage without sacrificing relevance.

4/ don't chase leaderboards; iterate on what fails. when something fails in production, don't just fix the prompt – add the failing case to your eval set. over time your suite will grow to reflect your real failure modes. periodically slice your evals (by input length, by locale, etc.) to see if you're regressing on particular segments.

5/ evolve your metrics as your product matures. as you scale, you'll want more nuanced scoring (semantic similarity, human ratings, cost/latency tracking). build hooks in your eval harness to log these and trend them over time. instrument your UI to collect implicit feedback (did the user click "thumbs up"?) and feed that back into your offline evals.

6/ make evals visible. put a simple dashboard in front of the team and stakeholders showing eval pass rates, cost, latency. use it in stand‑ups. this creates accountability and helps non‑ML folks participate in the trade‑off discussions.

finally, treat evals as a core engineering artifact. assign ownership, review them in code review, celebrate when you add a new tricky case. the discipline will pay compounding dividends as you scale.

1,07K

Top

Hodnocení

Oblíbené

Co je v trendu on-chain

Populární na X

Nejvyšší finanční vklady v poslední době

Nejpozoruhodnější