Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Teknium (e/λ)

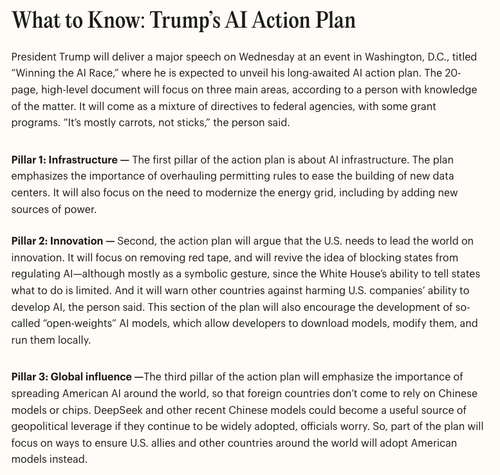

"Esta sección del plan también fomentará el desarrollo de los llamados modelos de IA de "pesos abiertos"

Billy Perrigo22 jul, 23:04

Tenemos un relato temprano de lo que hay en el plan de acción de IA de Trump, que se anunciará mañana (enlace en el próximo tweet)

¡Suscríbete a nuestro boletín @TIME In the Loop para recibir informes como este directamente en tu bandeja de entrada 2 veces por semana!

4.95K

Teknium (e/λ) reposteó

🚀 La clonación de voz MegaTTS 3 ya está aquí

Para contextualizar: hace un tiempo, ByteDance lanzó MegaTTS 3 (con capacidades excepcionales de clonación de voz), pero por varias razones, decidieron no lanzar el codificador WavVAE necesario para que la clonación de voz funcionara.

Recientemente, ACoderPassBy lanzó un codificador WavVAE compatible con MegaTTS 3 en ModelScope con resultados bastante prometedores.

En general, se ve bastante impresionante, ¡emocionado de ver que finalmente podemos hacer clonación de voz con MegaTTS 3!

(h / t a MysteryShack en el Discord de StyleTTS 2 para obtener información sobre el codificador WavVAE)

11.41K

¿No ha habido estudios sobre razonadores híbridos? Voy a hacer algunas ejecuciones a través de un nuevo modelo sin un conjunto de datos que no sea de razonamiento.

Le permitirá saber cómo los datos de solo razonamiento afectan el modelo frente a cuando hay datos sin razonamiento. Probablemente unas pocas semanas tendrán algunas buenas ideas si puedo tener tiempo.

4.92K

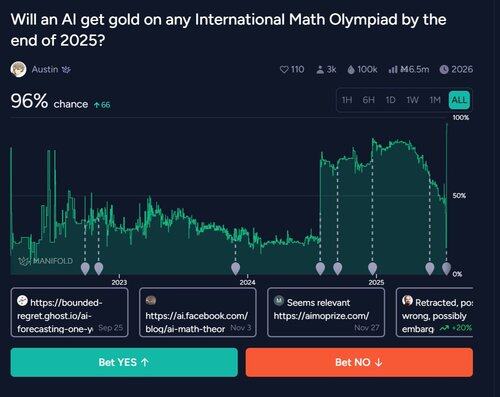

Recuerdo cuando todos dijeron que era un problema de tokenización

Flavio Adamo19 jul, 22:01

2020: "Los LLM no pueden hacer matemáticas".

2025: LLM gana el oro en la OMI

37.56K

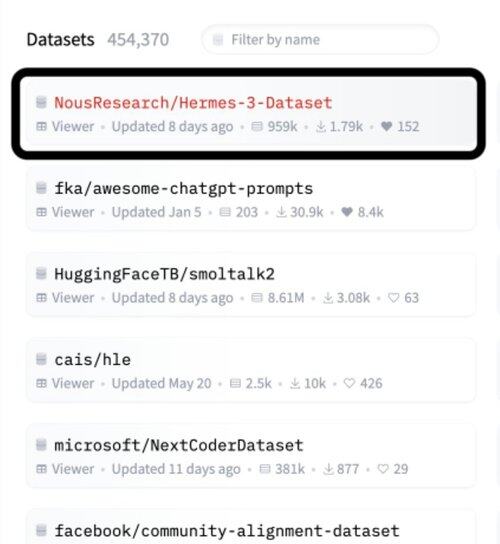

Teknium (e/λ) reposteó

Hermes 3 de @NousResearch es el conjunto de datos #1 en @huggingface

Planeo usarlo

No duermas en Nous

Ellos:

- Construya increíbles ajustes de código abierto

- Computación distribuida construida

- Tener conjuntos de datos bien seleccionados

- Son totalmente transparentes con los pesos y el código del modelo

- Tomas basadas en publicaciones en X

7.02K

Populares

Ranking

Favoritas

Onchain en tendencia

Tendencia en X

Principales fondos recientes

Más destacadas