Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Teknium (e/λ)

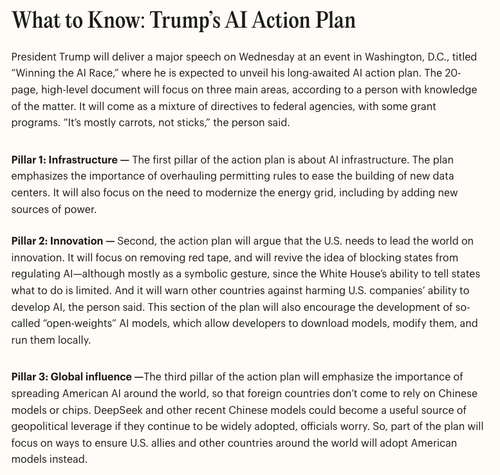

«Цей розділ плану також стимулюватиме розробку так званих моделей штучного інтелекту з відкритими вагами»

Billy Perrigo22 лип., 23:04

Ми отримали ранній звіт про те, що міститься в плані дій Трампа щодо штучного інтелекту, який має бути оголошений завтра (посилання в наступному твіті)

Підпишіться на нашу @TIME розсилку In the Loop, щоб отримувати такі звіти прямо на свою поштову скриньку 2 рази на тиждень!

4,95K

Користувач Teknium (e/λ) поділився

🚀 Клонування голосу MegaTTS 3 вже тут

Для контексту: деякий час назад компанія ByteDance випустила MegaTTS 3 (з винятковими можливостями клонування голосу), але з різних причин вирішила не випускати необхідний для роботи клонування голосу кодер WavVAE.

Нещодавно компанією ACoderPassBy на ModelScope був випущений кодер WavVAE, сумісний з MegaTTS 3, з досить багатообіцяючими результатами.

В цілому виглядає досить вражаюче - в захваті від того, що ми нарешті можемо зробити клонування голосу за допомогою MegaTTS 3!

(ч/т до MysteryShack на Discord StyleTTS 2 для отримання інформації про кодер WavVAE)

11,41K

Чи не проводилося досліджень гібридних міркувань? Я збираюся зробити кілька прогонів над новою моделлю без необґрунтованого набору даних з нею.

Розповість вам, як міркування лише дані впливають на модель у порівнянні з тим, коли є дані без міркувань. Можливо, кілька тижнів матимуть хороші висновки, якщо я зможу знайти час.

4,91K

Я бачив, як усі казали, що це проблема з токенізатором

Flavio Adamo19 лип., 22:01

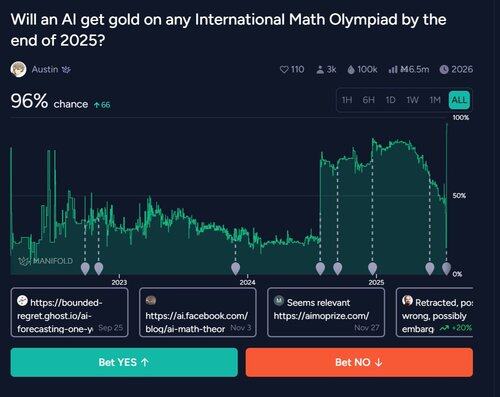

2020: «LLM не можуть займатися математикою».

2025: LLM виграє золото на IMO

37,54K

Користувач Teknium (e/λ) поділився

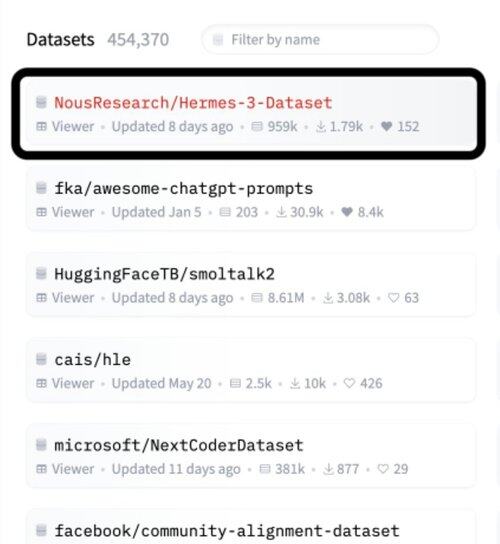

Hermes 3 з @NousResearch року є набором даних #1 на @huggingface

Я планую ним користуватися

Не спіть на Нусі

Вони:

- Створюйте дивовижні тонкі налаштування з відкритим вихідним кодом

- Побудовані розподілені обчислення

- Мати добре підібрані набори даних

- Повністю прозорі з вагою моделі та кодом

- Дублі на основі постів на X

7,02K

Найкращі

Рейтинг

Вибране

Актуальне ончейн

Популярні в X

Нещодавнє найкраще фінансування

Найбільш варте уваги