Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Teknium (e/λ)

Teknium (e/λ) erneut gepostet

🚀 MegaTTS 3 Sprachklonierung ist da

Zur Erklärung: Vor einiger Zeit hat ByteDance MegaTTS 3 veröffentlicht (mit außergewöhnlichen Sprachklonierungsfähigkeiten), aber aus verschiedenen Gründen haben sie beschlossen, den WavVAE-Encoder, der für die Sprachklonierung erforderlich ist, nicht zu veröffentlichen.

Kürzlich wurde ein mit MegaTTS 3 kompatibler WavVAE-Encoder von ACoderPassBy auf ModelScope veröffentlicht, mit ziemlich vielversprechenden Ergebnissen.

Insgesamt sieht es ziemlich beeindruckend aus - ich bin gespannt zu sehen, dass wir endlich Sprachklonierung mit MegaTTS 3 durchführen können!

(h/t an MysteryShack im StyleTTS 2 Discord für die Informationen über den WavVAE-Encoder)

7,07K

Gab es keine Studien zu hybriden Schlüssen? Ich werde einige Tests mit einem neuen Modell durchführen, das kein nicht-schlussfolgerndes Datenset hat.

Ich werde dir mitteilen, wie sich die Daten, die nur Schlussfolgerungen enthalten, auf das Modell auswirken im Vergleich zu Daten ohne Schlussfolgerungen. Wahrscheinlich werde ich in ein paar Wochen einige gute Erkenntnisse haben, wenn ich die Zeit finde.

4,84K

Ich erinnere mich, als alle sagten, es sei ein Tokenizer-Problem.

Flavio Adamo19. Juli, 22:01

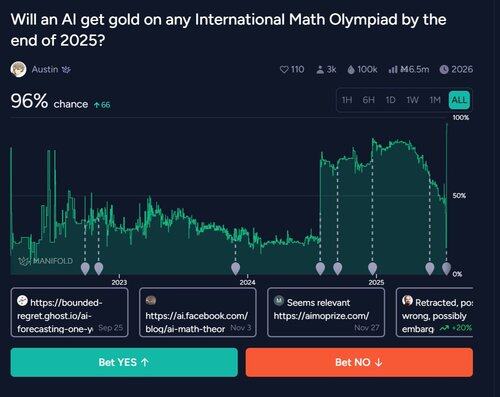

2020: „LLMs können kein Mathe.“

2025: LLM gewinnt Gold bei der IMO

37,45K

Teknium (e/λ) erneut gepostet

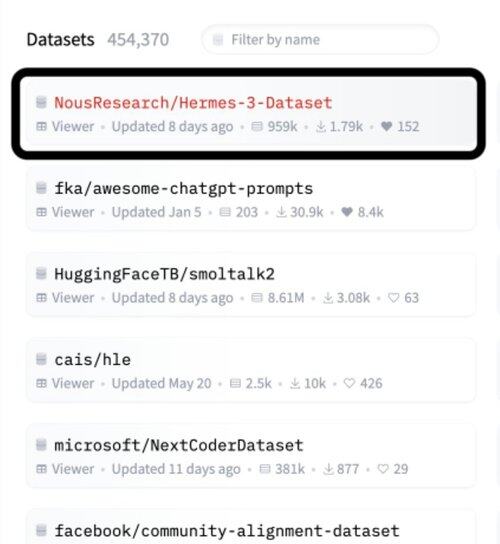

Hermes 3 von @NousResearch ist der #1 Datensatz auf @huggingface

Ich plane, ihn zu nutzen

Schlaf nicht auf Nous

Sie:

- Erstellen erstaunliche Open-Source-Fine-Tunes

- Haben verteilte Rechenleistung aufgebaut

- Haben gut kuratierte Datensätze

- Sind vollständig transparent mit Modellgewichten und Code

- Posten basierte Meinungen auf X

6,98K

Mein bester Tipp:

Rubriken + LLM-Richter - Jeden Punkt im Ground-Truth-Beweis atomisieren und mit der Modellausgabe vergleichen.

Mein Tipp, wie sie das skalierbar gemacht haben - denn zuvor war es nicht möglich, Menschen mussten sie akribisch erstellen, ist, dass sie sehr gute Rubriken für jedes spezifische Problem oder dessen Antwort trainiert oder etwas gemacht haben.

22,28K

Bevor wir eine Coding-IDE für KI starten, damit wir einfach gute Daten erhalten.

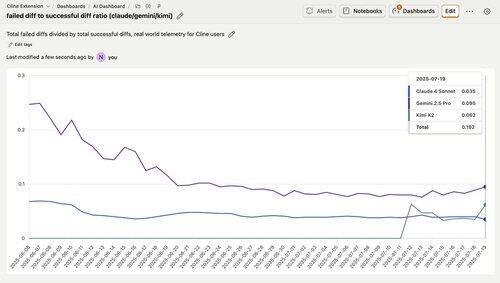

pash19. Juli, 09:58

Ich möchte darauf hinweisen, dass Kimi K2 bei realen Aufgaben (nicht Benchmarks) besser abschneidet als Gemini.

Dies ist die Telemetrie aller @cline-Nutzer, die die Fehlerrate bei der Bearbeitung zeigt. Beachten Sie, dass Kimi eine Fehlerrate von etwa 6 % hat, was deutlich besser ist als die Fehlerquote von Gemini von ~ 10 %.

Bemerkenswerterweise hat Kimi sogar Claude 4 in den meisten dieser Woche übertroffen und eine Fehlerrate von unter 4 % erreicht!

6,84K

Top

Ranking

Favoriten

Onchain-Trends

Im Trend auf X

Aktuelle Top-Finanzierungen

Am bemerkenswertesten