Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jasper

Mitbegründer und CEO @Hyperbolic_Labs. Ex-@avax & Ex-@citsecurities. Abschluss der Mathematikpromotion in 2 Jahren @UCBerkeley. Goldmedaillengewinner bei der Mathe-Olympiade. Höchste Auszeichnung @PKU1898

Wir könnten uns in eine Wendung der Geschichte im Saga von OpenAI vs. DeepMind IMO bewegen.

Gerade einen Beitrag von Joseph Myers gesehen (seit 1992 an der Mathematik-Olympiade beteiligt): Der IMO-Ausschuss hat Berichten zufolge die KI-Labore gebeten, ihre Ergebnisse erst 7 Tage nach der Abschlusszeremonie zu veröffentlichen — aus Respekt vor den menschlichen Teilnehmern (siehe meinen Beitrag von gestern) und wahrscheinlich, um Zeit für eine ordnungsgemäße Überprüfung der KI-Einreichungen und -Formate zu ermöglichen.

Laut Joseph hat OpenAI nicht mit der IMO zusammengearbeitet, um ihr Modell zu testen, und keiner der 91 offiziellen IMO-Koordinatoren war an der Bewertung ihrer Lösungen beteiligt. In der Zwischenzeit scheint DeepMind die Regeln zu befolgen und geduldig auf ihre Chance zu warten.

Zur Einordnung:

Die IMO hat 6 Probleme, jedes davon 7 Punkte wert. Der Gold-Cutoff in diesem Jahr liegt bei 35 Punkten. Selbst eine kleine Abwertung könnte OpenAI auf Silber zurückwerfen. Und nach meinem Verständnis ihrer Berichte könnten einige Teile Fragen aufwerfen — und möglicherweise Punkte kosten.

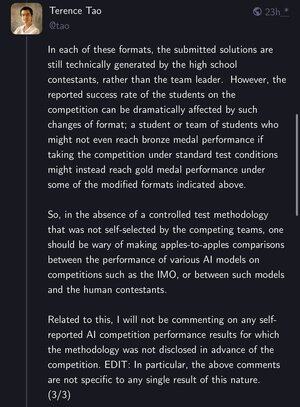

Terence Tao hat auch darauf hingewiesen, dass, während die Probleme gleich bleiben, die Testformate wichtig sind. Ein Schüler, der unter Standardbedingungen kein Bronze erhalten würde, könnte mit einem modifizierten Setup Gold erreichen — was echte Fragen darüber aufwirft, was "die IMO zu lösen" für KI bedeutet.

Nächste Woche könnte es spannend werden. Bleiben Sie dran.

87,4K

DeepMind erhielt am Freitagnachmittag eine Goldmedaille bei der IMO. Aber sie mussten warten, bis das Marketing den Tweet genehmigte – bis Montag.

@OpenAI teilte ihren zuerst um 1 Uhr morgens am Samstag und stahl die Show.

In diesem Spiel gilt: Geschwindigkeit > Bürokratie. Verpasse den Moment, verliere die Erzählung.

215,01K

Gerade von der Arbeit gekommen und habe Grok-4 an einem Topologie-Problem für Studenten ausprobiert. Es hat 9 Minuten gedauert, um nachzudenken, und dann hat es selbstbewusst eine saubere, plausible, aber völlig falsche Antwort gegeben 😅

Ich denke nicht, dass das hier als "geschickt adversarial" qualifiziert. KI-Modelle zertrümmern Benchmarks – aber es ist noch ein weiter Weg bis zur echten mathematischen AGI.

Elon Musk10. Juli, 16:47

Grok 4 ist an dem Punkt, an dem es im Grunde genommen niemals Fragen zu Mathematik/Physik-Prüfungen falsch beantwortet, es sei denn, sie sind geschickt gegnerisch.

Es kann Fehler oder Mehrdeutigkeiten in Fragen identifizieren und dann den Fehler in der Frage beheben oder jede Variante einer mehrdeutigen Frage beantworten.

663,01K

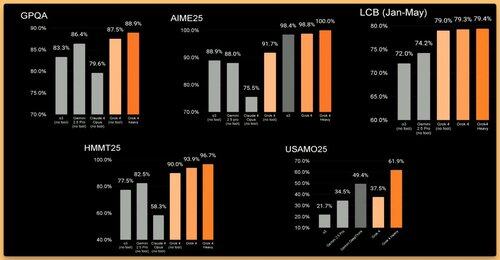

Grok hat die volle Punktzahl beim AIME erreicht 🤯 Wir brauchen jetzt definitiv einen besseren Mathematik-Benchmark für KI.

xAI10. Juli, 12:01

Präsentation von Grok 4, dem leistungsstärksten KI-Modell der Welt. Schau dir jetzt den Livestream an:

3K

Die Zukunft der KI ist kollaborativ

Yuchen Jin9. Juli, 06:09

Sam Altman wurde gefragt, wie er sich fühlte, als Zuck und Meta die besten Talente von OpenAI abwarben.

„Gut... gut...“ sagte er.

Hinter den von Jony Ive entworfenen Brillen konnte ich seine Augen nicht sehen. Aber ich konnte den Schmerz spüren.

Es ist für Zuck nicht schwer, Talente von OpenAI abzuwerben, nicht nur, weil er das Geld hat, sondern weil Open-Source-KI die ursprüngliche Mission von OpenAI erfüllt.

1,47K

Top

Ranking

Favoriten

Onchain-Trends

Im Trend auf X

Aktuelle Top-Finanzierungen

Am bemerkenswertesten