Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jasper

Co-fondatore e CEO @Hyperbolic_Labs. ex-@avax ed ex-@citsecurities. Ha terminato il dottorato di ricerca in matematica in 2 anni @UCBerkeley. Medaglia d'oro alle Olimpiadi di matematica. Massima onorificenza @PKU1898

Potremmo essere in procinto di un colpo di scena nella saga OpenAI vs. DeepMind IMO.

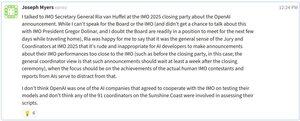

Ho appena visto un post di Joseph Myers (coinvolto nelle Olimpiadi di Matematica dal 1992): il comitato IMO avrebbe chiesto ai laboratori di intelligenza artificiale di non pubblicare i risultati fino a 7 giorni dopo la cerimonia di chiusura — per rispetto nei confronti dei concorrenti umani (vedi il mio post di ieri) e probabilmente per consentire il tempo necessario per una corretta verifica delle sottomissioni e dei formati AI.

Secondo Joseph, OpenAI non ha collaborato con l'IMO per testare il proprio modello, e nessuno dei 91 coordinatori ufficiali dell'IMO è stato coinvolto nella valutazione delle sue soluzioni. Nel frattempo, sembra che DeepMind stia seguendo le regole e stia aspettando pazientemente il proprio turno.

Per contesto:

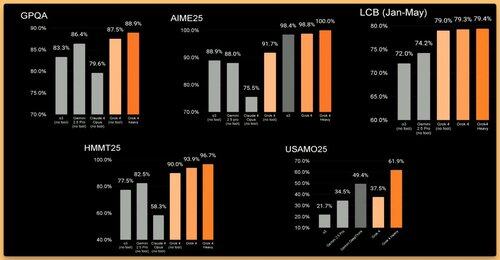

L'IMO ha 6 problemi, ciascuno vale 7 punti. Il limite per la medaglia d'oro di quest'anno è di 35 punti. Anche una piccola deduzione potrebbe far scendere OpenAI a argento. E dalla mia lettura dei loro scritti, alcune parti potrebbero sollevare domande — e possibilmente costare punti.

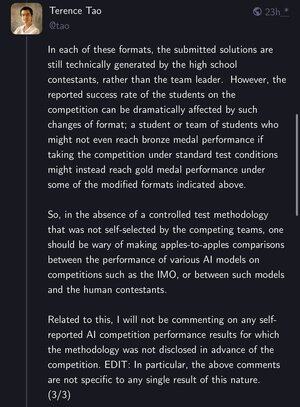

Terence Tao ha anche sottolineato che mentre i problemi rimangono gli stessi, i formati di test sono importanti. Uno studente che non otterrebbe un bronzo in condizioni standard potrebbe ottenere l'oro con un setup modificato — il che solleva vere domande su cosa significhi "risolvere l'IMO" per l'AI.

La prossima settimana potrebbe essere piccante. Rimanete sintonizzati.

87,4K

DeepMind ha ottenuto una medaglia d'oro all'IMO venerdì pomeriggio. Ma hanno dovuto aspettare che il marketing approvasse il tweet — fino a lunedì.

@OpenAI ha condiviso il proprio per primo alle 1 del mattino di sabato e ha rubato la scena.

In questo gioco, la velocità > burocrazia. Perdi il momento, perdi la narrazione.

215,01K

Appena uscito dal lavoro e ho provato Grok-4 su un problema di topologia per studenti universitari. Ha impiegato 9 minuti a pensare e poi ha dato con sicurezza una risposta pulita, plausibile, ma totalmente sbagliata 😅

Non penso che questo possa essere considerato "abilità avversariale". I modelli di intelligenza artificiale stanno schiacciando i benchmark — ma c'è ancora molta strada da fare per una vera AGI matematica.

Elon Musk10 lug, 16:47

Grok 4 è arrivato al punto in cui sostanzialmente non sbaglia mai le domande di esame di matematica/fisica, a meno che non siano abilmente avversariali.

Può identificare errori o ambiguità nelle domande, quindi correggere l'errore nella domanda o rispondere a ciascuna variante di una domanda ambigua.

663,01K

Grok ha ottenuto il punteggio massimo all'AIME 🤯 Abbiamo sicuramente bisogno di un benchmark matematico migliore per l'IA ora.

xAI10 lug, 12:01

Presentiamo Grok 4, il modello di intelligenza artificiale più potente al mondo. Guarda la diretta ora:

3K

Il futuro dell'IA è collaborativo

Yuchen Jin9 lug, 06:09

A Sam Altman è stato chiesto come si sentisse riguardo a Zuck e Meta che rubano i migliori talenti di OpenAI.

"Bene... buono..." ha detto.

Dietro occhiali progettati da Jony Ive, non riuscivo a vedere i suoi occhi. Ma potevo sentire il dolore.

Non è difficile per Zuck rubare talenti di OpenAI, non solo perché ha i soldi, ma perché l'IA open-source sta adempiendo alla missione originale di OpenAI.

1,47K

Principali

Ranking

Preferiti

On-chain di tendenza

Di tendenza su X

Principali fondi recenti

Più popolari