Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Max Ryabinin

Nghiên cứu và học sâu quy mô lớn @togethercompute

Tác giả Learning@home / Hivemind (DMoE, DeDLOC, SWARM, Petals)

Tiến sĩ DL phi tập trung '2023

Nếu bạn đang ở ICML và quan tâm đến suy diễn có thể xác minh, hãy chắc chắn ghé qua poster của chúng tôi!

Chúng tôi sẽ trình bày TOPLOC, một phương pháp băm kích hoạt hiệu quả hoạt động trong nhiều cài đặt khác nhau, ví dụ như chuyển đổi các thiết lập suy diễn hoặc thậm chí là các mô hình.

Ngày 16 tháng 7, 4:30 chiều, E-1106

1,42K

Theo kinh nghiệm của tôi, việc có một bài báo về DL phi tập trung được chấp nhận tại các hội nghị hàng đầu có thể khá khó khăn. Động lực không quen thuộc với nhiều người đánh giá, và các thiết lập thí nghiệm tiêu chuẩn không tính đến những vấn đề mà bạn muốn giải quyết.

Vì vậy, tôi rất hào hứng khi thấy những công ty như @PluralisHQ và @PrimeIntellect đang nỗ lực chia sẻ kết quả của họ và công bố chúng tại các hội nghị lớn! Theo ý kiến của tôi, ngay cả việc chuẩn bị nộp bài cũng buộc bạn phải nghiêm túc hơn về các thí nghiệm của mình + phản hồi từ các nhà đánh giá giúp bạn làm sắc nét thông điệp của bài báo.

Alexander Long08:24 14 thg 7

Đối với những người không quen thuộc với việc xuất bản AI; có 3 hội nghị chính diễn ra hàng năm. ICML, ICLR và NeurIPS. Đây là các hội nghị kỹ thuật và tương đương với các tạp chí trong các lĩnh vực khác - chúng là nơi xuất bản chính cho AI. Cạnh tranh để có bài báo tại những hội nghị này hiện đang ở mức độ vô lý, việc được chấp nhận bài báo rất khó khăn, và có rất nhiều lo ngại về quy trình đánh giá, hiện tại khá ồn ào. Một bài báo mạnh mẽ không có lỗi có khoảng 50% cơ hội được chấp nhận, và thường thì một bài báo được nộp với các thay đổi từ người đánh giá nhiều lần cho đến khi nó được chấp nhận. Mặc dù vậy, các bài báo tại những nơi này vẫn là dấu ấn chính của tính hợp pháp trong thế giới AI, và có lẽ vẫn là các chỉ số nghề nghiệp chính cho các nhà nghiên cứu ML (mặc dù điều này đang yếu đi theo ý kiến của tôi khi mà rất nhiều nghiên cứu tại các phòng thí nghiệm tiên phong chưa được công bố).

Các bài báo Main Track khác biệt đáng kể so với các bài báo workshop. Main track có quy trình đánh giá đồng nghiệp nghiêm ngặt, căng thẳng. Các bài báo workshop dành cho công việc sơ bộ, cho thấy một số chỉ dẫn về một kết quả thú vị, nhưng không hoàn chỉnh hoặc kết quả không đủ quan trọng cho main track. Chúng chỉ cần được đánh giá bởi nhóm người đánh giá workshop và không xuất hiện trong biên bản.

Nhiều bài báo tuyệt vời đã lần đầu tiên xuất hiện trong các hội thảo (ví dụ: grokking) - nhưng các bài báo workshop và main track là những thứ hoàn toàn khác nhau, với một mức độ tác động hoàn toàn khác nhau. Hai công ty duy nhất trong AI phi tập trung có các bài báo main track năm nay là @PrimeIntellect và Pluralis.

7,26K

Cảm ơn rất nhiều Ferdinand đã tổ chức cuộc trò chuyện này! Đây là một cơ hội tuyệt vời để tổng quan tất cả các phần của SWARM và thảo luận sâu về động lực đứng sau chúng.

Tôi hy vọng video này sẽ giúp việc học tập phi tập trung trở nên dễ tiếp cận hơn: nhiều ý tưởng trong lĩnh vực này đơn giản hơn những gì chúng ta nghĩ!

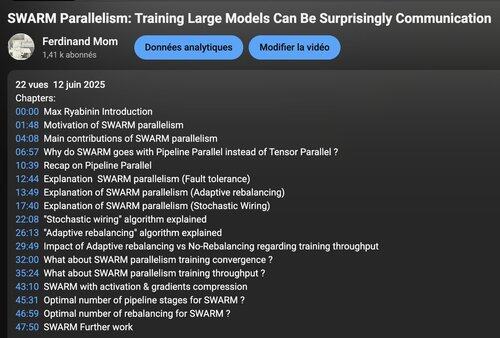

Ferdinand Mom12 thg 6, 2025

Video đánh giá bài nghiên cứu về "Swarm Parallelism" cùng với tác giả @m_ryabinin, Nhà khoa học nghiên cứu xuất sắc @togethercompute hiện đã có ! Liên kết bên dưới 👇

Để có bối cảnh, hầu hết các phương pháp đào tạo phi tập trung hiện nay đều theo các phương pháp kiểu DDP yêu cầu sao chép toàn bộ mô hình trên mỗi nút. Mặc dù thực tiễn cho những người có cụm H100 trong tay, nhưng điều này vẫn nằm ngoài tầm với của phần lớn các nhà đóng góp tiềm năng, đây là lúc SWARM trở nên hữu ích!

3,11K

Hàng đầu

Thứ hạng

Yêu thích

Onchain thịnh hành

Thịnh hành trên X

Ví funding hàng đầu gần đây

Được chú ý nhất