Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Vi kan vara på väg in i en plot twist i sagan om OpenAI vs. DeepMind IMO.

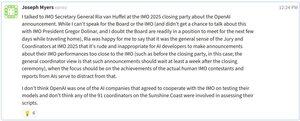

Såg precis ett inlägg från Joseph Myers (involverad i matematikolympiaden sedan 1992): IMO-kommittén ska enligt uppgift ha bett AI-laboratorier att inte publicera resultat förrän 7 dagar efter avslutningsceremonin - av respekt för mänskliga tävlande (se mitt inlägg igår) och troligen för att ge tid för korrekt verifiering av AI-bidrag och format.

Enligt Joseph samarbetade OpenAI inte med IMO för att testa deras modell, och ingen av de 91 officiella IMO-samordnarna var inblandade i betygsättningen av dess lösningar. Samtidigt verkar det som om DeepMind följer reglerna och tålmodigt väntar på sin tur.

För sammanhang:

IMO har 6 problem, vart och ett värt 7 poäng. Årets guldgräns är 35 poäng. Även ett litet avdrag kan slå ner OpenAI till silver. Och från min läsning av deras skrivningar kan vissa delar väcka frågor - och eventuellt kosta poäng.

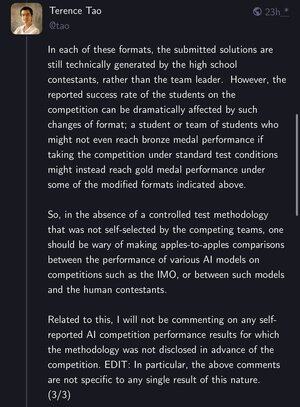

Terence Tao påpekade också att även om problemen förblir desamma, är testformaten viktiga. En student som inte skulle få ett brons under standardförhållanden kan ta guld med en modifierad uppställning – vilket väcker verkliga frågor om vad det innebär för AI att "lösa IMO".

Nästa vecka kan bli kryddig. Håll ögonen öppna.

20 juli 03:15

DeepMind fick en guldmedalj på IMO på fredagseftermiddagen. Men de fick vänta på att marknadsföringen skulle godkänna tweeten – till måndag.

@OpenAI delade med sig av sin första vid 01-tiden på lördagen och stal rampljuset.

I det här spelet > snabbhet byråkrati. Missa ögonblicket, förlora berättelsen.

@swierk De fann att 3 tidigare IMO-medaljörer inte var officiella IMO-samordnare: "För varje problem betygsatte tre tidigare IMO-medaljörer oberoende av varandra modellens inlämnade bevis, med poäng som slutfördes efter enhällig konsensus."

19 juli 15:50

6/N I vår utvärdering löste modellen 5 av de 6 problemen på 2025 IMO. För varje problem betygsatte tre tidigare IMO-medaljörer oberoende av varandra modellens inlämnade bevis, med poäng som slutfördes efter enhällig konsensus. Modellen fick totalt 35/42 poäng, vilket räckte till guld! 🥇

Mitt tidigare inlägg om IMO-kommitténs fråga

20 juli 05:42

Förtydligande: Jag har fått höra av någon på Google att deras IMO-resultat fortfarande verifieras internt. När det är gjort planerar de att dela med sig av dem officiellt – nyfikna på att se deras tillvägagångssätt.

En annan källa nämnde att IMO-kommittén bad om att inte offentligt diskutera AI-inblandning inom en vecka efter avslutningsceremonin. Saker och ting blev bara lite mer intressanta 🧐

@GoogleDeepMind övermänskliga resonemang teamledare @lmthang också tog upp frågan om OpenAI skulle vinna ett guld eller silver

20 juli 05:42

Förtydligande: Jag har fått höra av någon på Google att deras IMO-resultat fortfarande verifieras internt. När det är gjort planerar de att dela med sig av dem officiellt – nyfikna på att se deras tillvägagångssätt.

En annan källa nämnde att IMO-kommittén bad om att inte offentligt diskutera AI-inblandning inom en vecka efter avslutningsceremonin. Saker och ting blev bara lite mer intressanta 🧐

@GoogleDeepMind övermänskliga resonemangsteamets ledare @lmthang som byggde AlphaGeometry väckte också frågan om OpenAI skulle vinna en guld- eller silvermedalj

20 juli 23:47

Ja, det finns en officiell märkningsriktlinje från IMO-organisatörerna som inte är tillgänglig externt. Utan en bedömning baserad på den riktlinjen kan inga medaljanspråk göras. Med en poängs avdrag är det ett silver, inte guld.

@swierk ja, det finns fler och fler frågor som väcks av matematik- och AI-människor

21 juli 03:41

@GoogleDeepMind övermänskliga resonemangsteamets ledare @lmthang som byggde AlphaGeometry väckte också frågan om OpenAI skulle vinna en guld- eller silvermedalj

219,71K

Topp

Rankning

Favoriter