熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

SB1047 是個糟糕的主意。但威納參議員最新的 SB53 走在正確的道路上,重要的是要指出這一進展。以下是我的理由。

我對於像模型這樣的新技術的監管方法是:我們不知道如何定義「良好」的減輕和保證,但當我們看到時——如果我們看到的話——我們就會知道。

這有兩個含義。

#1. 我們不應該為模型開發規定風險閾值或護理標準。我們無法就重要的風險達成共識,如何衡量它們,或多少才算過多。對於開發者、監管者和法院的唯一指導是由依賴付費牆進行重任務的封閉源公司主要決定的一套新興實踐。這樣做可能會因為將開發者暴露於模糊或加重的責任而抑制開放創新。

這就是 SB1047 的要點,以及它在本會期激發的約 5 個類似法案,例如紐約的 RAISE 法案。我們應該避免這種方法。這些提案在狹隘但關鍵的方面——過於超前。

然而:

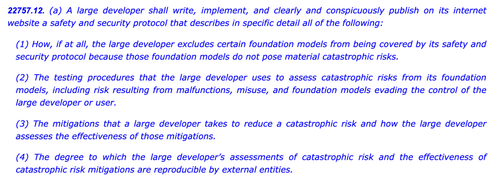

#2. 我們需要關注行業實踐,以更好地了解不同公司所應用的勤勉程度,或缺乏勤勉。如果開發者必須承諾安全和安全政策,展示他們的工作,並留下文書記錄,我們可以更好地評估他們主張的強度,監控新興風險,並決定未來的干預。

這就是歐盟的 AI 法案和最終的實踐守則的要點,OpenAI 和 Mistral 都已支持,這也是 @Scott_Wiener 最新版本的 SB53。

如果我們要監管模型開發,這根本上是更好的方法:監管透明度——而不是能力、減輕或可接受的風險。這將使至少一個美國管轄區擁有布魯塞爾的監管權限,並避免對開放開發的意外影響。

需要明確的是,前方仍有冰山:

> 複雜性。無論是大型科技公司還是其他,這些都是繁重的文檔和報告義務。從戰術上講,越複雜,這項法案就越脆弱。

> 激勵。強制公開自願風險評估的報告會為開發者創造一種扭曲的激勵,使他們對模型進行不足的測試,並對困難的風險視而不見。允許開發者向審計員或機構披露他們的結果,而不是公開,可能有助於促進他們內部評估的更大坦誠。

> 特洛伊木馬。加州的過度活躍的修改文化使得審核這些法案變得困難。如果 SB53 變成像 SB1047 或 RAISE 的護理標準法案,應該因為之前的相同原因而被否決。這棵聖誕樹上添加的裝飾越多,法案就越具爭議性。

> 廣度。該法案以擴展的災難風險和危險能力的定義廣泛涵蓋。如果這是一項「強制報告/自願實踐」的法案,那麼它們是可行的。如果這項法案是一項護理標準法案,那麼它們將是不可行的。

總之:向威納參議員致敬,感謝他在過去一年中深思熟慮地參與並回應反饋。看到一項實際上基於先前批評的法案令人耳目一新。這項法案仍然有許多可能的路徑——而且它已經超越了最初的舉報提案——但其發展趨勢是令人鼓舞的。

6.02K

熱門

排行

收藏