热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

SB1047是个坏主意。但维纳参议员最新的SB53走在正确的轨道上,重要的是要指出这一进展。以下是我的理由。

我对监管新技术(如模型)的看法是:我们不知道如何定义“良好”的缓解和保障,但当我们看到时——如果我们看到的话——我们就会知道。

这有两个含义。

#1. 我们不应该为模型开发规定风险阈值或护理标准。我们无法就重要的风险达成一致,无法测量它们,也无法确定多少才算过多。对开发者、监管者和法院的唯一指导是一套主要由依赖付费墙进行重负担的闭源公司确定的初步实践。这样做可能会通过使开发者面临模糊或加重的责任而抑制开放创新。

这就是SB1047的要点,以及它在本届会议中激发的约5个类似提案,例如纽约的RAISE法案。我们应该避免这种做法。这些提案在狭义但关键的方面——过于超前。

然而:

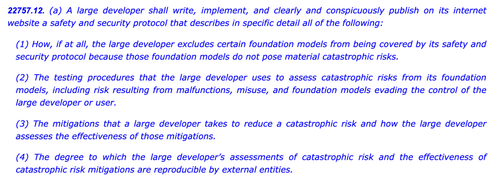

#2. 我们需要关注行业实践,以更好地理解不同公司所应用的尽职调查,或缺乏尽职调查。如果开发者必须承诺安全和安全政策,展示他们的工作,并留下纸质记录,我们可以更好地评估他们主张的强度,监测新兴风险,并决定未来的干预。

这就是欧盟的AI法案和最终的实践守则的要点,OpenAI和Mistral都对此表示支持,这也是@Scott_Wiener最新版本的SB53。

如果我们要监管模型开发,这从根本上是更好的方法:监管透明度——而不是能力、缓解或可接受的风险。这将使至少一个美国管辖区拥有布鲁塞尔的监督权,并避免对开放开发的意外影响。

明确来说,前方仍有冰山:

> 复杂性。无论是大科技公司还是其他公司,这些都是繁重的文档和报告义务。从战术上讲,越复杂,这项法案就越脆弱。

> 激励。强制公开自愿风险评估的报告为开发者创造了一个扭曲的激励,使他们对模型进行不足的测试,并对困难的风险视而不见。允许开发者将结果披露给审计员或机构而不是公开,可能有助于促进他们内部评估的更大坦诚。

> 特洛伊木马。加利福尼亚州的过度活跃的修改文化使得审查这些法案变得困难。如果SB53变成像SB1047或RAISE那样的护理标准法案,应该因之前的相同原因被驳回。这个圣诞树上添加的装饰越多,法案就越具争议性。

> 广度。该法案以广泛的灾难性风险和危险能力的定义撒下了广网。对于“强制报告/自愿实践”法案来说,它们是有效的。如果这项法案是护理标准法案,它们将是不可行的。

总之:向维纳参议员致敬,感谢他在过去一年中认真参与并回应反馈。看到一项真正建立在之前批评基础上的法案令人耳目一新。这项法案仍然有许多可能的发展路径——并且它已经远远超出了最初的举报提案——但其轨迹是有希望的。

6.02K

热门

排行

收藏