Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

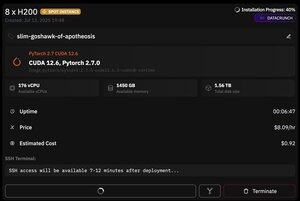

Prime Intellect

Користувач Prime Intellect поділився

але що чудово в @PrimeIntellect, так це доступність спотових екземплярів - сьогодні я отримав вузол з 8xH200 всього за 8 доларів США за годину!

Я покажу, як я швидко налаштував висновок moonshotai/Kimi-K2-Instruct за допомогою vllm

1. Отримавши SSH-доступ до вашого поду (зачекайте близько 10 хвилин), створіть свій проект і встановіть необхідні бібліотеки:

apt update && apt install htop tmux

UV INIT

УВ Венв -П 3.12

джерело .venv/bin/activate

експорт UV_TORCH_BACKEND=авто

експортувати HF_HUB_ENABLE_HF_TRANSFER="1"

uv pip install vllm blobfile набори даних huggingface_hub hf_transfer

Після цього відкрийте сеанс tmux

2. Для початку хостингу vllm достатньо використовувати vllm serve:

vllm serve moonshotai/Kimi-K2-Instruct --trust-remote-code --dtype bfloat16 --max-model-len 12000 --max-num-seqs 8 --quantization="fp8" --tensor_parallel_size 8

Фактичне завантаження КПП є складним завданням, оскільки навіть з hf_transfer це займе 1 годину (хтось знає швидше рішення або якось монтувати завантажену КПП?)

3. Потім на новій панелі tmux встановіть швидкий тунель cloudflare і запустіть його

Встановіть CloudFlared

Хмарний тунель --URL

Ось, в принципі, і все! Сервер, сумісний з OpenAI, буде доступний за URL-адресою, наданою Cloudflare, у моєму випадку це так, і я просто використовую свою просту обгортку над клієнтом openai, щоб генерувати багато синтетичних даних через нього

38,7K

Найкращі

Рейтинг

Вибране

Актуальне ончейн

Популярні в X

Нещодавнє найкраще фінансування

Найбільш варте уваги