Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Prime Intellect

Prime Intellect erneut gepostet

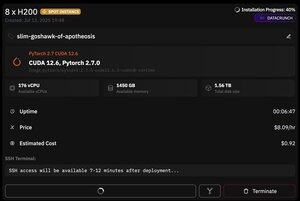

Aber das Tolle an @PrimeIntellect ist die Verfügbarkeit von Spot-Instanzen – heute habe ich einen Knoten mit 8xH200 für nur 8 $/Stunde bekommen!

Ich werde zeigen, wie ich schnell moonshotai/Kimi-K2-Instruct-Inferenz mit vllm eingerichtet habe.

1. Nachdem Sie SSH-Zugriff auf Ihr Pod erhalten haben (warten Sie etwa 10 Minuten), erstellen Sie Ihr Projekt und installieren Sie die erforderlichen Bibliotheken:

apt update && apt install htop tmux

uv init

uv venv -p 3.12

source .venv/bin/activate

export UV_TORCH_BACKEND=auto

export HF_HUB_ENABLE_HF_TRANSFER="1"

uv pip install vllm blobfile datasets huggingface_hub hf_transfer

Danach öffnen Sie eine tmux-Sitzung.

2. Um vllm zu hosten, verwenden Sie einfach vllm serve:

vllm serve moonshotai/Kimi-K2-Instruct --trust-remote-code --dtype bfloat16 --max-model-len 12000 --max-num-seqs 8 --quantization="fp8" --tensor_parallel_size 8

Der tatsächliche Download des Checkpoints ist schwierig, da es selbst mit hf_transfer 1 Stunde dauern wird (weiß jemand eine schnellere Lösung oder wie man den heruntergeladenen Checkpoint irgendwie einbindet?)

3. Installieren Sie dann in einem neuen tmux-Fenster cloudflare quick tunnel und starten Sie es.

install cloudflared

cloudflared tunnel --url

Das ist im Grunde alles! Ein OpenAI-kompatibler Server wird unter der von Cloudflare bereitgestellten URL verfügbar sein, in meinem Fall ist es und ich benutze einfach meinen einfachen Wrapper über den OpenAI-Client, um viele synthetische Daten darüber zu generieren.

38,7K

Top

Ranking

Favoriten

Onchain-Trends

Im Trend auf X

Aktuelle Top-Finanzierungen

Am bemerkenswertesten