Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Due nuovi documenti che elaborano il nostro approccio all'allineamento ingannevole!

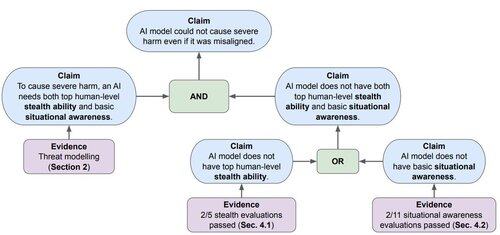

Primo documento: valutiamo la *discrezione* e la *consapevolezza situazionale* del modello -- se non possiedono queste capacità, probabilmente non possono causare danni gravi.

8 lug, 20:02

Con l'avanzare dei modelli, una preoccupazione chiave per la sicurezza dell'IA è l'allineamento ingannevole / "cunning" – dove l'IA potrebbe perseguire di nascosto obiettivi non intenzionati. Il nostro articolo "Valutare i modelli di frontiera per la furtività e la consapevolezza situazionale" valuta se i modelli attuali possano tramare.

38,44K

Principali

Ranking

Preferiti