Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tokenisierung ist nur ein spezieller Fall von "Chunking" - das Zusammenbauen von niedrigstufigen Daten zu hochstufigen Abstraktionen - was wiederum grundlegend für Intelligenz ist.

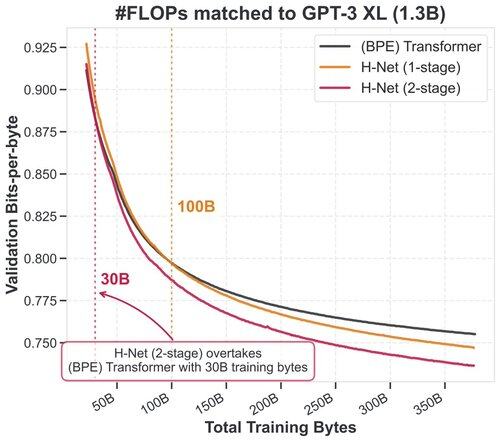

Unsere neue Architektur, die hierarchisches *dynamisches Chunking* ermöglicht, ist nicht nur tokenizer-frei, sondern skaliert einfach besser.

12. Juli, 00:06

Tokenization has been the final barrier to truly end-to-end language models.

We developed the H-Net: a hierarchical network that replaces tokenization with a dynamic chunking process directly inside the model, automatically discovering and operating over meaningful units of data

Dies war ein unglaublich wichtiges Projekt für mich - ich wollte es seit Jahren lösen, hatte aber keine Ahnung wie. Das war alles die erstaunliche Arbeit von @sukjun_hwang und @fluorane!

Ich habe über die Geschichte seiner Entwicklung geschrieben und was als Nächstes kommen könnte.

Das H-Net:

194,68K

Top

Ranking

Favoriten