Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tommy

Partener fondator @Delphi_Ventures | Co-fondator @Delphi_Digital | Gazdă @PodcastDelphi | Construit @VenturesRobot | Nu sfaturi de investiții

Podcast incredibil cu @demishassabis CEO-ul Google DeepMind cu @lexfridman

Câteva note umane brute despre părțile mele preferate

- Schimbarea de 50% a AGI până în 2030. Inteligența zimțată nu funcționează. Este nevoie de consecvență a inteligenței în toate domeniile (capacități creative, inventive).

- Modelul video VEO3 de la Gemini este incredibil de bun la fizică și realism (iluminare, materiale, lichide), în ciuda faptului că nu are nicio formă în lumea reală. Este înțeleasă fizica prin observație și acest lucru sugerează o înțelegere mai profundă a lumii noastre.

- AlphaEvolve de la DeepMind evoluează algoritmi. AI/LLM-urile colaborează cu algoritmi evolutivi (optimizare inspirată de biologie: evoluția iterativă a populațiilor către o aptitudine mai bună prin operațiuni care imită selecția naturală)

- Gustul (care este experimentul sau întrebarea potrivită) și judecata vor fi extrem de greu de bătut în cuie cu AI. Sistemele nu pot face acest lucru astăzi.

- Noam Shazeer (Transformers), David Silver (AlphaGO), Demis este destul de clar că crede că Google are cel mai bun talent AI. "Este mai greu să inventezi lucruri decât să urmărești rapid". Cele mai multe descoperiri originale ale inteligenței artificiale au fost prin Google.

- El nu crede că rămânem fără date de antrenat.

- Fuziunea și energia solară sunt sursele cheie de energie pentru AI. Bateriile și transmisia sunt problemele de bază.

- Pare foarte puțin probabil ca textul să fie interfața cu utilizatorul cu AI cu mai multe modalități. Se așteaptă la interfețe generate de inteligență artificială adaptate la modul în care funcționează creierul fiecărei persoane.

- Rezultatele benchmark-urilor sunt dificile, deoarece pe măsură ce optimizezi pentru un domeniu, altul se clatină, este un act de echilibru foarte dificil. Utilizatorii finali sunt arbitrul suprem (Lex a spus această ultimă parte, dar mi-a plăcut)

- Demis spune că Meta nu este la frontieră, dar este în urmă, așa că plătește prea mult pentru ca talentul să ajungă din urmă.

- AGI este cea mai importantă tehnologie care va fi inventată vreodată.

- Oamenii care îmbrățișează AI și devin una cu ei vor deveni super productivi din punct de vedere uman.

- Primul lucru este să creezi mai multă abundență de resurse, astfel încât aceasta să nu fie o situație cu sumă zero.

Lex Fridman24 iul., 03:06

Iată conversația mea cu @demishassabis, CEO al Google DeepMind, totul despre viitorul AI și AGI, simularea biologiei și fizicii, jocurile video, programare, generarea video, modele mondiale, Gemini 3, legile de scalare, calcul, P vs NP, complexitate, energie (solară și fuziune) și multe altele. Aceasta a fost o conversație super-tehnică distractivă și fascinantă.

Este aici pe X în întregime și este deschis peste tot (vezi comentariul).

Marcajele:

0:00 - Punctul culminant al episodului

1:21 - Introducere

2:06 - Modele care pot fi învățate în natură

5:48 - Calcul și P vs NP

14:26 - Veo 3 și înțelegerea realității

18:50 - Jocuri video

30:52 - AlphaEvolve

36:53 - Cercetarea IA

41:17 - Simularea unui organism biologic

46:00 - Originea vieții

52:15 - Calea către AGI

1:03:01 - Legi de scalare

1:06:17 - Calcul

1:09:04 - Viitorul energiei

1:13:00 - Natura umană

1:17:54 - Google și cursa către AGI

1:35:53 - Competiție și talent AI

1:42:27 - Viitorul programării

1:48:53 - John von Neumann

1:58:07 - P(Doom)

2:02:50 - Umanitate

2:05:56 - Conștiință și calcul cuantic

2:12:06 - David Foster Wallace

2:19:20 - Educație și cercetare

1,57K

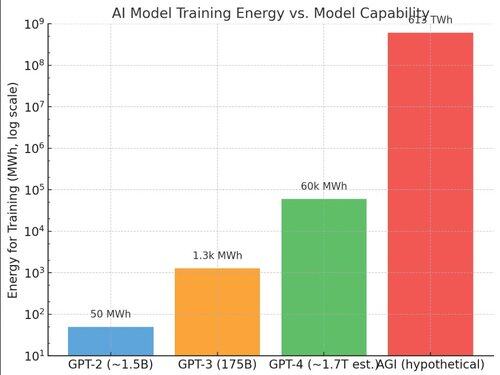

Câtă energie să antrenezi AGI? ☀️🔋

- Record actual: Cursa completă de antrenament a GPT-4 ≈ 55 GWh

- Sistemul de clasă AGI (≈ 100 de milioane de GPU-uri echivalente cu H100) a consumat o putere anuală de antrenament ≈ 613.000 GWh

- Diferență de patru ordine de mărime

- 2031-2035 este cea mai bună estimare

Energia este o dependență de bază de AGI

Limitări

1/ AI ar putea duce la descoperiri energetice. Aceasta este auto-îmbunătățire recursivă într-o formă diferită, deoarece îmbunătățește antrenamentul de bază, ceea ce face ca termenele să fie mai scurte.

2/ Inferența va fi o cerere uriașă pentru GPU-uri. Antrenamentul nu primește toate GPU-urile. Acest lucru va face termenele mai lungi.

H/T conversații grozave cu @KSimback

Link către întrebarea ChatGPT:

828

GG @Kalshi câștigă cursa xAI

Tommy2 iul., 08:38

So @grok is so good at fact checking I think @Polymarket and @Kalshi can start relying on it to settle markets

Grok did this happen by X time? Yes or no.

1,1K

GG @Kalshi câștigă cursa xAI

Tommy2 iul., 08:38

So @grok is so good at fact checking I think @Polymarket and @Kalshi can start relying on it to settle markets

Grok did this happen by X time? Yes or no.

20

Este posibil ca obținerea AGI prin GPU-uri găzduite sub corturi să fie o extremă destul de sălbatică

AI at MetaCu 8 ore în urmă

Ne extindem rapid infrastructura AI și am adoptat o nouă abordare de a construi corturi rezistente la intemperii pentru a găzdui clustere GPU. Acest lucru ne permite să punem în funcțiune noi centre de date în luni în loc de ani. 🚀

Citiți mai multe în acest articol @FastCompany:

1,06K

Limită superioară

Clasament

Favorite

La modă pe lanț

La modă pe X

Principalele finanțări recente

Cele mai importante