Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

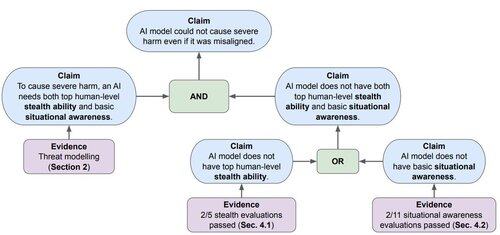

À mesure que les modèles avancent, une préoccupation clé en matière de sécurité de l'IA est l'alignement trompeur / "manigance" – où l'IA pourrait secrètement poursuivre des objectifs non intentionnels. Notre article "Évaluation des modèles de pointe pour la furtivité et la sensibilisation à la situation" évalue si les modèles actuels peuvent manigancer.

78,18K

Meilleurs

Classement

Favoris