Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Arvind Narayanan

Princeton CS prof. Director @PrincetonCITP. Utilizo X para compartir mis investigaciones y comentarios sobre el impacto social de la IA.

LIBRO: Aceite de serpiente AI. Las vistas son mías.

Mi experiencia con ChatGPT Agent hasta ahora: no he logrado encontrar ningún caso de uso que _no_ pueda ser manejado por Deep Research y que, sin embargo, pueda ser completado con éxito por Agent sin encontrar obstáculos como formularios web defectuosos o restricciones de acceso.

Estoy seguro de que encontraré algunos usos, pero terminará siendo una pequeña fracción de las tareas que surgen en mis flujos de trabajo.

Si este es el caso, no tendrá sentido intentar realizar nuevas tareas usando Agent a menos que sea una tarea en la que de otro modo pasaría horas (o que necesitaría repetir a diario). Si mi expectativa es que Agent tendrá éxito con una probabilidad del 5%, y toma de 10 a 20 minutos de intentar con mucho esfuerzo antes de rendirme, no vale la pena mi tiempo siquiera averiguar si Agent puede hacerlo. Solo lo usaría si de alguna manera ya supiera que es una tarea que Agent puede manejar.

Dado todo esto, sigo pensando que los agentes específicos para tareas serán más exitosos en el futuro previsible.

7,78K

Arvind Narayanan republicó

🧠Nuevo en el blog de CITP del estudiante de doctorado Boyi Wei (@wei_boyi) del laboratorio POLARIS: "La 'burbuja' del riesgo: Mejorando las evaluaciones para agentes de ciberseguridad ofensiva"

Lee sobre cómo los adversarios pueden adaptar y modificar modelos de código abierto para eludir las salvaguardias. 👇

3,12K

De vuelta en la escuela de posgrado, cuando me di cuenta de cómo funciona realmente el "mercado de ideas", sentí que había encontrado los códigos de trucos para una carrera en investigación. Hoy, esto es lo más importante que enseño a los estudiantes, más que cualquier cosa relacionada con la sustancia de nuestra investigación.

Una rápida introducción: cuando hablo de éxito en la investigación no me refiero a publicar muchos artículos. La mayoría de los artículos publicados acumulan polvo porque hay demasiada investigación en cualquier campo para que la gente preste atención. Y especialmente dado lo fácil que es publicar preprints, la investigación no necesita ser publicada oficialmente para tener éxito. Así que, aunque las publicaciones pueden ser un requisito previo para el avance profesional, no deberían ser el objetivo. Para mí, el éxito en la investigación es la autoría de ideas que influyen en tus pares y hacen del mundo un lugar mejor.

Así que la idea básica es que hay demasiadas ideas entrando en el mercado de ideas, y necesitamos entender cuáles terminan siendo influyentes. La buena noticia es que la calidad importa: otras cosas siendo iguales, una mejor investigación será más exitosa. La mala noticia es que la calidad solo está débilmente correlacionada con el éxito, y hay muchos otros factores que importan.

Primero, date múltiples oportunidades. El papel de la suerte es un tema recurrente en mis consejos de carrera. Es cierto que la suerte importa mucho a la hora de determinar qué artículos son exitosos, pero eso no significa resignarse a ello. Puedes aumentar tu "superficie de suerte".

Por ejemplo, si siempre publicas preprints, tienes múltiples oportunidades para que tu trabajo sea notado: una vez con el preprint y otra con la publicación (además, si estás en un campo con grandes retrasos en las publicaciones, puedes asegurarte de que la investigación no sea adelantada o irrelevante para cuando salga).

Más generalmente, trata los proyectos de investigación como startups: acepta que hay una variabilidad muy alta en los resultados, con algunos proyectos siendo 10x o 100x más exitosos que otros. Esto significa intentar muchas cosas diferentes, tomar grandes riesgos, estar dispuesto a perseguir lo que tus pares consideran malas ideas, pero con alguna idea de por qué podrías tener éxito donde otros antes que tú fracasaron. ¿Sabes algo que otros no saben, o ellos saben algo que tú no? Y si descubres que es lo segundo, necesitas estar dispuesto a abandonar el proyecto rápidamente, sin caer en la falacia del costo hundido.

Para ser claro, el éxito no se debe solo a la suerte: la calidad y la profundidad importan mucho. Y se necesitan algunos años de investigación para profundizar en un tema. Pero pasar unos años investigando un tema antes de publicar nada es extremadamente arriesgado, especialmente al principio de tu carrera. La solución es simple: persigue proyectos, no problemas.

Los proyectos son agendas de investigación a largo plazo que duran de 3 a 5 años o más. Un proyecto productivo podría fácilmente producir una docena o más de artículos (dependiendo del campo). ¿Por qué elegir proyectos en lugar de problemas? Si tu método es saltar de problema en problema, los artículos resultantes probablemente serán algo superficiales y pueden no tener mucho impacto. Y en segundo lugar, si ya eres conocido por artículos sobre un tema particular, es más probable que la gente preste atención a tus futuros artículos sobre ese tema. (Sí, la reputación del autor importa mucho. Cualquier noción igualitaria de cómo la gente elige qué leer es un mito.)

Para resumir, normalmente trabajo en 2-3 proyectos a largo plazo a la vez, y dentro de cada proyecto hay muchos problemas que se investigan y muchos artículos que se producen en varias etapas del proceso.

La parte más difícil es saber cuándo terminar un proyecto. En el momento en que estás considerando un nuevo proyecto, estás comparando algo que tomará unos años en realmente fructificar con un tema donde ya eres altamente productivo. Pero tienes que terminar algo para hacer espacio para algo nuevo. Abandonar en el momento adecuado siempre se siente como abandonar demasiado pronto. Si sigues tu instinto, permanecerás en la misma área de investigación durante demasiado tiempo.

Finalmente, construye tu propia distribución. En el pasado, la publicación oficial de un artículo servía para dos propósitos: darle la credibilidad que proviene de la revisión por pares y distribuir el artículo a tus pares. Ahora esas dos funciones se han separado completamente. La publicación aún aporta credibilidad, pero la distribución es casi enteramente responsabilidad tuya.

Por eso las redes sociales son tan importantes. Desafortunadamente, las redes sociales introducen incentivos poco saludables para exagerar tus hallazgos, así que encuentro que los blogs/boletines y los videos de formato largo son canales mucho mejores. Estamos en una segunda edad dorada del blogging y hay una extrema escasez de personas que pueden explicar investigaciones de vanguardia de sus disciplinas de manera accesible pero sin simplificarlas como en comunicados de prensa o artículos de noticias. Nunca es demasiado temprano: comencé un blog durante mi doctorado y jugó un gran papel en la difusión de mi investigación doctoral, tanto dentro de mi comunidad de investigación como fuera de ella.

Resumen

* El éxito en la investigación no solo significa publicación

* El mercado de ideas está saturado

* Date múltiples oportunidades

* Elige proyectos, no problemas

* Trata los proyectos como startups

* Construye tu propia distribución.

44,23K

Arvind Narayanan republicó

Los expertos en el trastorno dismórfico corporal han advertido que las personas que luchan con él se han vuelto cada vez más dependientes de los chatbots de IA para evaluar sus defectos percibidos y recomendar cirugías estéticas. "Casi siempre aparece en cada sesión", me dice un terapeuta.

106,85K

Si comparamos las capacidades de la IA con las de los humanos sin acceso a herramientas, como internet, probablemente encontraríamos que la IA ya supera a los humanos en muchas o la mayoría de las tareas cognitivas que realizamos en el trabajo. Pero, por supuesto, esta no es una comparación útil y no nos dice mucho sobre los impactos económicos de la IA. No somos nada sin nuestras herramientas.

Y, sin embargo, muchas predicciones sobre el impacto de la "AGI" se basan en comparaciones hipotéticas entre humanos e IA en las que los humanos tienen acceso a internet pero no a la IA. Este tipo de comparación es igualmente irrelevante.

La verdadera pregunta es humanos + IA frente a IA sola. En tal comparación, la IA no va a superar a las parejas humano-IA, excepto en dominios estrechos y computacionalmente intensivos como los juegos, donde la velocidad es primordial y tener un humano en la imagen solo ralentiza las cosas.*

Así que si la IA reemplazará o no a los humanos depende de factores más allá de la precisión: cosas como la responsabilidad, la capacidad de manejar lo desconocido, y las posibles preferencias de los clientes y otros trabajadores de interactuar con un humano, todo sopesado contra el costo de emplear a un humano.

Esto no quiere decir que la IA no desplazará empleos. Pero mirar los puntos de referencia de capacidad y pasar directamente a afirmaciones sobre la pérdida de empleos es completamente ingenuo.

* Hay muchos estudios donde los trabajadores anulan incorrectamente la IA con demasiada frecuencia, pero eso es porque no recibieron capacitación sobre cuándo anular y cuándo no, lo cual es una habilidad esencial en flujos de trabajo habilitados por IA.

12,67K

Arvind Narayanan republicó

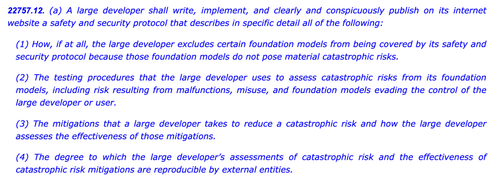

SB1047 fue una mala idea. Pero el último SB53 del Senador Wiener está en el camino correcto, y es importante reconocer el progreso. Aquí está mi razonamiento.

Mi enfoque para regular tecnologías novedosas como los modelos es: no sabemos cómo definir una mitigación y aseguramiento "buenos", pero lo sabremos cuando—y si—lo veamos.

Hay dos implicaciones.

#1. No deberíamos prescribir umbrales de riesgo o estándares de cuidado para el desarrollo de modelos. No podemos ponernos de acuerdo sobre los riesgos que importan, cómo medirlos o cuánto es demasiado. La única guía para desarrolladores, reguladores y tribunales es un conjunto de prácticas incipientes determinadas principalmente por empresas de código cerrado que dependen de muros de pago para hacer el trabajo pesado. Hacerlo podría enfriar la innovación abierta al exponer a los desarrolladores a una responsabilidad vaga o aumentada por la liberación generalizada.

Eso fue SB1047 en pocas palabras, junto con ~5 equivalentes que inspiró en todo EE. UU. esta sesión, como el RAISE Act en NY. Deberíamos evitar ese enfoque. Estas propuestas son—en aspectos estrechos pero cruciales—demasiado ambiciosas.

Y aún así:

#2. Necesitamos arrojar luz sobre las prácticas de la industria para entender mejor la diligencia, o la falta de ella, aplicada por diferentes empresas. Si los desarrolladores tienen que comprometerse a una política de seguridad y protección, mostrar su trabajo y dejar un rastro documental, podemos evaluar mejor la solidez de sus afirmaciones, monitorear riesgos emergentes y decidir sobre futuras intervenciones.

Ese es el Acta de IA de la UE y el Código de Práctica final en pocas palabras, que tanto OpenAI como Mistral han respaldado, y también es la última versión del SB53 de @Scott_Wiener.

Si vamos a regular el desarrollo de modelos, ese es fundamentalmente el mejor enfoque: regular la transparencia—no las capacidades, mitigaciones o riesgos aceptables. Esto daría al menos a una jurisdicción de EE. UU. la autoridad de supervisión de Bruselas, y evitaría efectos no deseados en el desarrollo abierto.

Para ser claros, todavía hay icebergs por delante:

> Complejidad. Ya sea Big Tech o no, estas son obligaciones de documentación e informes onerosas. Hablando tácticamente, cuanto más complejo, más vulnerable se volverá este proyecto de ley.

> Incentivos. La obligación de informar públicamente sobre evaluaciones de riesgo voluntarias crea un incentivo perverso para que los desarrolladores no prueben adecuadamente sus modelos y hagan la vista gorda ante riesgos difíciles. Permitir que los desarrolladores divulguen sus resultados a auditores o agencias en lugar de públicamente puede ayudar a promover una mayor sinceridad en sus evaluaciones internas.

> Caballo de Troya. La cultura hiperactiva de California de modificar y enmendar puede dificultar la evaluación de estos proyectos de ley. Si SB53 se convierte en un proyecto de ley de estándar de cuidado como SB1047 o RAISE, debería ser rechazado por las mismas razones que antes. Cuantos más adornos se añadan a este árbol de Navidad, más contencioso será el proyecto de ley.

> Amplitud. El proyecto de ley lanza una red amplia con definiciones expansivas de riesgo catastrófico y capacidad peligrosa. Para un proyecto de ley de "informes obligatorios / prácticas voluntarias", funcionan. Si este proyecto de ley fuera un proyecto de ley de estándar de cuidado, serían inviables.

En resumen: un aplauso para el Senador Wiener por involucrarse y responder de manera reflexiva a los comentarios durante el año pasado. Es refrescante ver un proyecto de ley que realmente se basa en críticas anteriores. Todavía hay muchos caminos que este proyecto de ley podría tomar—y ha evolucionado mucho más allá de la propuesta original de denuncia—pero la trayectoria es prometedora.

6K

Arvind Narayanan republicó

Nueva publicación: Delirios de datacenter

Entre las potencias medianas, los EAU tienen la estrategia de IA más clara: convertirse en un 'estado petrolero de IA' con una participación significativa en la computación global. La mayoría de los otros países están construyendo datacenters sin apuntar a umbrales de soberanía viables.

🧵

10,03K

Parte superior

Clasificación

Favoritos

En tendencia on-chain

En tendencia en X

Principales fondos recientes

Más destacado