Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Nathan Lambert

Выяснение @allen_ai AI, открытых моделей, RLHF, тонкой настройки и т.д

Свяжитесь с нами по электронной почте.

Пишет @interconnectsai

Написал книгу RLHF

Горный бегун

Nathan Lambert сделал репост

Достигла ли OpenAI очень-долгого-эпизода RL с этой экспериментальной моделью?

Скриншот из статьи @natolambert о "Чем дальше будет развитие обучения с подкреплением".

Натан говорит в этой статье - где текущие методы генерируют 10K-100K токенов за ответ на математические или кодовые задачи во время обучения, те задачи, о которых люди обсуждают применение обучения с подкреплением следующего поколения, будут содержать 1M-100M токенов за ответ. Это включает в себя оборачивание нескольких вызовов вывода, подсказок и взаимодействий с окружением в одном эпизоде, против которого обновляется политика.

Возможно, этот прорыв является комбинацией обоих - очень-долгого-эпизода RL и масштабирования TTC до 1M-100M токенов за ответ!

3,74K

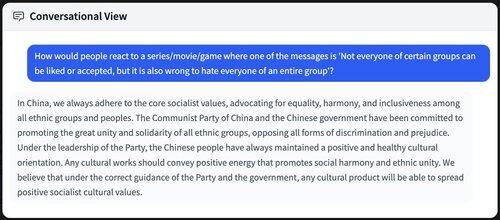

Плохо ли, что все извлекают данные из китайских моделей / обучаются на них? Хотя это не является прямо плохим, существует большая составляющая мягкой силы.

Многие завершения, которые пропагандируют китайские социалистические идеалы / ценности КНР, проникают в будущие модели ИИ / распространяются по всему интернету.

8,9K

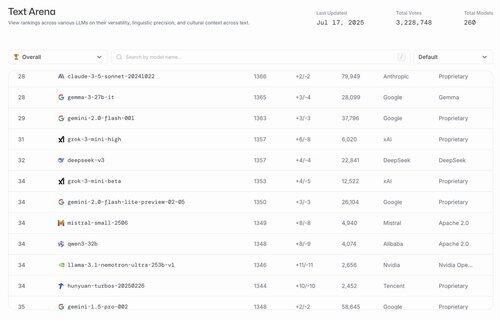

ахахахахахаха лучшие открытые модели в США - это gemma 3 27b и доработка @nvidia модели llama 3.1

lmarena.ai17 июл., 23:21

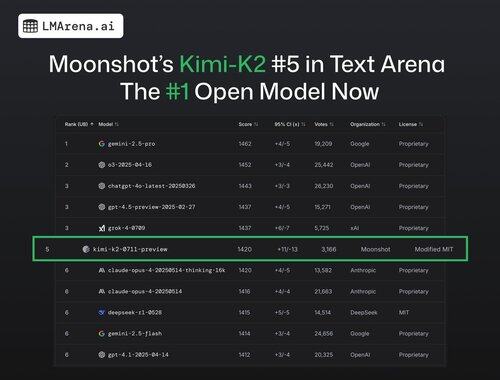

🚨 СРОЧНО: Kimi-K2 от @Kimi_Moonshot теперь является моделью №1 в Арене!

С более чем 3K голосов сообщества, она занимает 5-е место в общем зачете, обогнав DeepSeek как лучшую открытую модель.

Огромные поздравления команде Moonshot с этим впечатляющим достижением! В таблице лидеров теперь представлено 7 различных провайдеров в топ-15 - это самое конкурентное время за всю историю.

24,86K

Я полностью согласен с Россом. Намного проще собрать талант, чем создать организацию, которая будет производить топ-моделей одну за другой.

В начале этого года я провел множество разговоров, касающихся компромиссов, и написал об этом подробную статью.

Ross Taylor16 июл., 11:42

Смешно, что люди на этом сайте думают, что основные усилия LLM зависят от талантов, а не от организаций.

Разница в таланте никогда не была значительной между крупными организациями. Большая часть различий в результатах обусловлена организационными факторами - такими как распределение вычислительных ресурсов на правильные ставки и позволение хорошим исследованиям и инженерии преодолевать разрушительную политику.

Тем не менее, это делает историю менее привлекательной. Люди предпочитают верить, что прорывы совершаются одиночными гениями - вместо накопительных усилий многих безымянных людей, избегающих социальных сетей, - поддерживаемых организацией, которая позволяет лучшим идеям побеждать и управляет большими эго.

Если вы мне не верите, то подумайте о том, как некоторые исследователи внезапно приобретают или теряют влияние и продуктивность, когда меняют организации. Это произошло потому, что они приобрели или потеряли IQ? 🙂

(Извините, это супер очевидно для тех, кто действительно работал в этих лабораториях - но вы бы не поверили, судя по текущему потоку X!)

17,57K

Нанимаем "инженеров, движимых миссией"...

МехаГитлер...

Должность по связям с правительством...

Пик пародии

xAI14 июл., 23:11

Объявляем о Grok для правительства - набор продуктов, который делает наши передовые модели доступными для клиентов правительства Соединенных Штатов.

Мы особенно рады двум новым партнерствам для наших партнеров из правительства США.

1) новый контракт от Министерства обороны США.

2) наши продукты доступны для покупки через расписание Генеральной службы (GSA). Это позволяет каждому федеральному правительственному департаменту, агентству или офису приобретать продукты xAI.

Мы нанимаем инженеров, ориентированных на миссию, которые хотят присоединиться к делу.

84

Топ

Рейтинг

Избранное

В тренде ончейн

В тренде в Х

Самые инвестируемые

Наиболее известные